DeepSeek-R1 es un modelo de lenguaje de última generación enfocado en el razonamiento lógico y la resolución estructurada de problemas.

Diseñado para desarrolladores, este modelo destaca por su arquitectura técnica innovadora, su entrenamiento mediante aprendizaje por refuerzo, y sus amplias capacidades en tareas complejas (matemáticas, programación, análisis científico, etc.).

A continuación exploramos en detalle la arquitectura de DeepSeek R1, sus innovaciones clave, y cómo los desarrolladores pueden utilizarlo en aplicaciones reales vía API o implementación local.

Arquitectura técnica de DeepSeek R1

Estructura del modelo y tamaño: DeepSeek R1 es un modelo de gran escala, con una arquitectura Mixture-of-Experts (Mezcla de Expertos) que abarca 671 mil millones de parámetros en total, aunque solo activa alrededor de 37 mil millones de parámetros por token procesado . Esta arquitectura masiva y distribuida le permite lograr un equilibrio entre potencia y eficiencia.

Además, el modelo maneja un contexto extremadamente extenso de hasta 128,000 tokens, lo que significa que puede procesar entradas muy largas (documentos completos, código extenso, etc.) sin perder continuidad.

En esencia, DeepSeek R1 fue construido sobre los cimientos de modelos base previos pero optimizado específicamente para maximizar el razonamiento estructurado.

Mecanismos de atención avanzados: En su núcleo, la arquitectura de DeepSeek R1 emplea técnicas innovadoras para mejorar la eficiencia y la calidad de sus respuestas.

Por ejemplo, incorpora un mecanismo de atención latente multi-cabezal (multi-head latent attention) junto con estrategias innovadoras de balanceo de carga.

El mecanismo de atención multi-cabezal latente permite al modelo enfocarse en diferentes partes de la entrada simultáneamente, detectando patrones complejos y relaciones sutiles en los datos.

Por su parte, el esquema de balanceo de carga garantiza que los recursos de cómputo se utilicen de forma óptima, activando solo los expertos necesarios para cada token y tarea.

Estas características arquitectónicas sofisticadas hacen que DeepSeek R1 sea altamente eficaz en el procesamiento de problemas estructurados y aseguran una inferencia eficiente incluso con su gran tamaño.

Capacidades emergentes del modelo: Gracias a su diseño arquitectónico y de entrenamiento (que detallaremos más adelante), DeepSeek R1 exhibe comportamientos de razonamiento avanzados que emergen de forma natural.

El modelo demuestra habilidades como auto-reflexión y auto-verificación durante el proceso de generación de respuestas.

En la práctica, esto significa que DeepSeek R1 es capaz de evaluar sus propias soluciones intermedias, reconocer potenciales errores o incoherencias, y corregir el rumbo antes de finalizar una respuesta.

Este fenómeno de “cadena de pensamiento” (o Chain-of-Thought) largo le permite desglosar problemas complejos en pasos lógicos más pequeños y explicarlos de forma transparente.

Por ejemplo, puede elaborar pruebas matemáticas paso a paso o generar código comentado explicando la lógica detrás de cada sección.

Estas capacidades de razonamiento estructurado y verificación interna distinguen a DeepSeek R1 como una herramienta potente para desarrolladores que necesitan respuestas confiables y bien fundamentadas.

Innovaciones en el entrenamiento: aprendizaje por refuerzo y capacidades de razonamiento

Enfoque de entrenamiento híbrido (supervisado + refuerzo): A diferencia de los modelos de lenguaje tradicionales que dependen principalmente de enormes conjuntos de datos supervisados, DeepSeek R1 fue entrenado mediante una estrategia innovadora centrada en el aprendizaje por refuerzo (RL).

En particular, el equipo de DeepSeek adoptó un enfoque RL-first, donde el modelo desarrolló sus habilidades de razonamiento principalmente a través de ensayo y error con recompensas, en lugar de aprender únicamente de ejemplos estáticos.

Sin embargo, para estabilizar las fases iniciales del entrenamiento (evitando salidas incoherentes o divergencias), se incluyó una pequeña fase de ajuste supervisado inicial. Este “arranque en frío” consistió en exponer al modelo base a unos pocos miles de ejemplos de alta calidad antes de iniciar el RL. Dichos ejemplos proporcionaron una guía estructurada mínima (por ejemplo, problemas resueltos paso a paso) que sirvió como base sobre la cual el modelo pudiera refinar sus estrategias mediante refuerzo.

Esta combinación híbrida – un arranque supervisado seguido de un extenso entrenamiento por refuerzo – permitió que DeepSeek R1 iterativamente mejorara sus estrategias de solución de problemas a la vez que mantenía coherencia lingüística en sus respuestas, un equilibrio difícil de lograr solo con RL puro.

Aprendizaje por refuerzo especializado: Durante el entrenamiento por refuerzo, DeepSeek R1 utilizó un algoritmo de optimización de políticas personalizado llamado Group Relative Policy Optimization (GRPO), diseñado específicamente para incentivar las capacidades de razonamiento del modelo.

En lugar de requerir grandes cantidades de datos etiquetados, GRPO se enfoca en recompensar al modelo por la precisión de sus respuestas y el formato correcto de las soluciones, guiándolo hacia salidas lógicamente válidas y bien estructuradas. Por ejemplo, al resolver un problema matemático, el modelo recibiría mayor recompensa si su respuesta final es correcta y además presenta el razonamiento en un formato ordenado (pasos numerados, explicaciones claras) tal como se esperaría de un solucionador humano. Este esquema de recompensas motivó a DeepSeek R1 a desarrollar internamente pasos de razonamiento y verificación, en lugar de simplemente adivinar respuestas directas.

Cabe destacar que este trabajo de entrenamiento demostró por primera vez en la comunidad de IA que es posible incentivar el razonamiento complejo en modelos de lenguaje mediante RL puro, con un mínimo de guía supervisada inicial.

Pipeline de entrenamiento multi-etapa: La construcción de DeepSeek R1 implicó un cuidadoso proceso de entrenamiento en cuatro etapas distintas, diseñado para superar las limitaciones de un enfoque de RL puro y lograr un modelo más completo.

En resumen, el proceso fue el siguiente:

- Ajuste fino supervisado inicial: Se realizó una fine-tuning del modelo base utilizando miles de ejemplos de alta calidad cuidadosamente seleccionados. Estos ejemplos “cold-start” proveían soluciones ejemplares a diversos problemas (ej. soluciones matemáticas detalladas, fragmentos de código correctos, respuestas explicativas), para darle al modelo una noción básica de respuestas bien formadas.

- Aprendizaje por refuerzo enfocado en razonamiento: A continuación, el modelo entrenó mediante RL en tareas de razonamiento, abordando problemas complejos sin apoyo adicional de datos etiquetados. En esta fase, el modelo practicó resolución de problemas paso a paso, recibiendo recompensas por alcanzar respuestas correctas y mantener buena estructura en la explicación. Este paso permitió que emergieran comportamientos de razonamiento avanzados (como la auto-verificación mencionada) a través del aprendizaje de la propia experiencia del modelo.

- Generación de nuevos datos y ajuste supervisado intermedio: Cerca del final de la fase de RL, los investigadores emplearon una técnica de muestreo por rechazo (rejection sampling) para recopilar nuevos datos de entrenamiento. Esencialmente, hicieron que el modelo resolviera una variedad de preguntas y seleccionaron las mejores respuestas generadas como datos adicionales. Estas respuestas de alta calidad producidas por el propio modelo (particularmente en problemas de lógica, matemáticas, etc.) se combinaron con datos supervisados adicionales provenientes del conjunto base (incluyendo tareas de escritura, preguntas de conocimiento factual y auto-reflexión). Con este conjunto enriquecido de datos, se realizó un segundo ajuste fino supervisado del modelo. Esta etapa intermedia consolidó las habilidades: se aprovechó el conocimiento generado por el modelo durante el RL para afinarlo aún más bajo un entorno controlado, cubriendo además ámbitos no estrictamente de razonamiento (como respuestas conversacionales, preguntas directas, etc.) para darle versatilidad.

- Refinamiento final por refuerzo en todos los escenarios: Por último, el modelo así ajustado pasó por una última fase de aprendizaje por refuerzo, esta vez considerando prompts de todo tipo de escenarios (mezclando problemas matemáticos, instrucciones de programación, preguntas abiertas, etc.). Este refuerzo final permitió al modelo alinearse con las preferencias humanas y contextos diversos, asegurando que pudiera desempeñarse bien no solo en problemas de lógica pura, sino también en interacciones más generales. Al concluir esta etapa multi-modal de RL, se obtuvo el modelo final denominado DeepSeek R1.

Gracias a este riguroso proceso de entrenamiento, DeepSeek R1 logró capacidades de razonamiento sobresalientes sin sacrificar la calidad del lenguaje.

El modelo demostró ser robusto durante todo el entrenamiento, sin caídas catastróficas de desempeño ni necesidad de reinicios, lo cual es notable dado lo complejo del proceso de RL prolongado.

En términos prácticos, el resultado es un modelo que alcanza o supera el desempeño de los mejores modelos cerrados en múltiples tareas de razonamiento, manteniendo al mismo tiempo coherencia y fluidez en español (y potencialmente otros idiomas), gracias a esa pequeña semilla supervisada inicial.

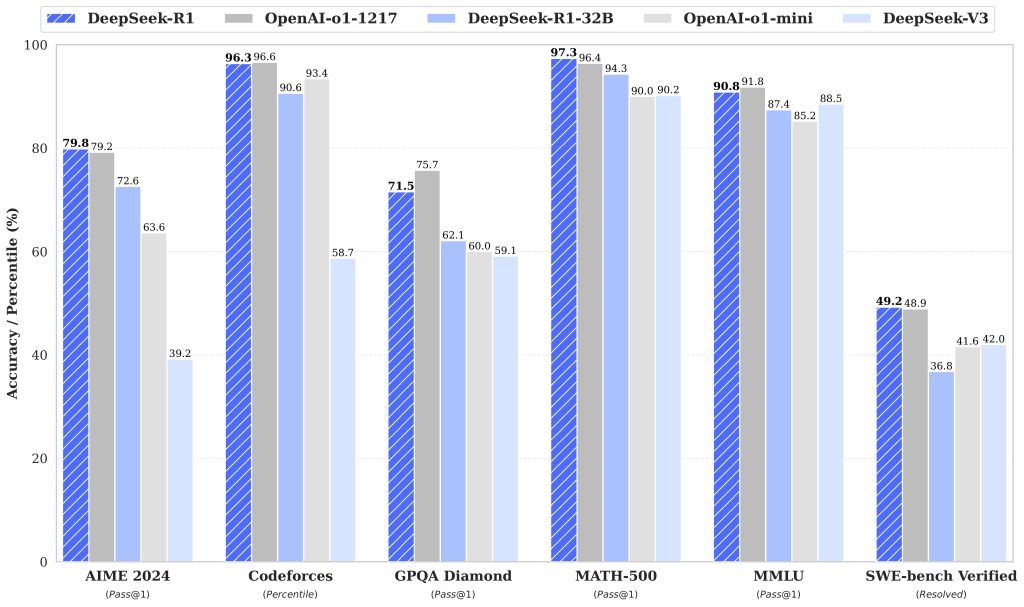

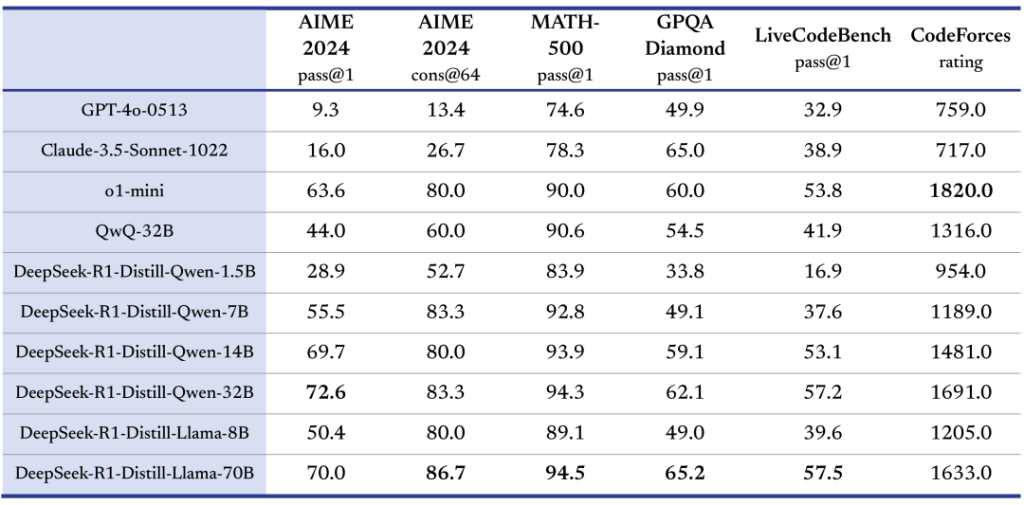

Capacidades destacadas y rendimiento: DeepSeek R1 ha sido evaluado en numerosos benchmarks que ponen a prueba sus facultades de razonamiento y conocimiento. Sus resultados han sido impresionantes en dominios lógico-matemáticos, situándose a la par de las mejores soluciones disponibles.

Por ejemplo, en conjuntos de problemas matemáticos de competencia, ha logrado tasas de éxito elevadas (rozando el 80–90% en ciertos exámenes difíciles), demostrando una comprensión profunda de matemáticas avanzadas.

También exhibe habilidades avanzadas en programación, habiendo sobresalido en pruebas de generación de código y resolución de desafíos algorítmicos. En un benchmark de ingeniería de software (SWE-bench), superó a otros enfoques al completar tareas de codificación complejas, evidenciando su alta competencia para generar y depurar código. Más allá de los números, lo importante es que DeepSeek R1 razona sobre el código, comprendiendo la intención de la tarea y produciendo soluciones estructuradas y comentadas cuando es necesario.

Todo esto lo hace ideal para ser aprovechado como motor en asistentes de programación, herramientas de revisión automática de código o resolución de problemas técnicos.

Adicionalmente, gracias a su ventana de contexto de 128K tokens y su entrenamiento orientado al razonamiento, DeepSeek R1 es muy capaz en tareas de análisis de texto extenso.

Puede ingerir documentos largos o múltiples fuentes y extraer conclusiones o responder preguntas detalladas sobre ellos, lo cual abre posibilidades para aplicaciones de QA (preguntas y respuestas) sobre documentación, asistentes de investigación, e incluso herramientas de búsqueda semántica donde se requiere analizar gran cantidad de información antes de responder.

En resumen, las capacidades de DeepSeek R1 abarcan desde razonamiento lógico riguroso (demostraciones matemáticas, puzzles lógicos), pasando por generación de código fuente y depuración automática, hasta comprensión de lenguaje natural en contexto amplio, todo ello manteniendo un tono y estructura de respuesta coherente y profesional.

Uso de DeepSeek R1 en aplicaciones reales

Una vez comprendidas la arquitectura y las capacidades de DeepSeek R1, es importante saber cómo pueden los desarrolladores aprovechar este modelo en sus propios proyectos.

Al ser un modelo open-source disponible para la comunidad, DeepSeek R1 ofrece varias vías de acceso: desde una API en la nube hasta la ejecución local del modelo (en diferentes tamaños), según las necesidades y recursos disponibles.

Acceso mediante API oficial

Para facilitar la integración en aplicaciones y servicios, DeepSeek AI proporciona una API oficial de DeepSeek R1.

Esta API está diseñada para ser compatible con el formato de las API de OpenAI, lo que significa que los desarrolladores familiarizados con servicios como GPT-4 o similares pueden adaptarse rápidamente al utilizar DeepSeek R1.

En la práctica, se puede enviar una petición HTTP con un prompt y recibir la respuesta generada por el modelo en formato JSON, de manera muy similar a otras APIs de lenguaje.

Algunos detalles clave sobre el uso de la API de DeepSeek R1:

- Obtención de credenciales: Es necesario registrarse en la plataforma de DeepSeek para obtener una clave de API personal. Una vez con la clave, las solicitudes se autentican mediante un encabezado HTTP (por ejemplo, usando Bearer Token como en muchas APIs REST).

- Punto de acceso: La URL base típica para las llamadas es

api.deepseek.com/v1(según la documentación oficial). Sobre este endpoint RESTful, se ofrecen métodos para generar texto, configurar parámetros de generación, etc. - Compatibilidad y documentación: La alta compatibilidad con el formato de OpenAI implica que las bibliotecas cliente existentes (por ejemplo, SDKs en Python, JavaScript, etc. diseñados para la API de OpenAI) pueden reutilizarse con mínimos cambios, simplemente cambiando el endpoint y la clave de autenticación. Además, DeepSeek proporciona documentación detallada y ejemplos de cómo realizar las llamadas a su API para diversas tareas.

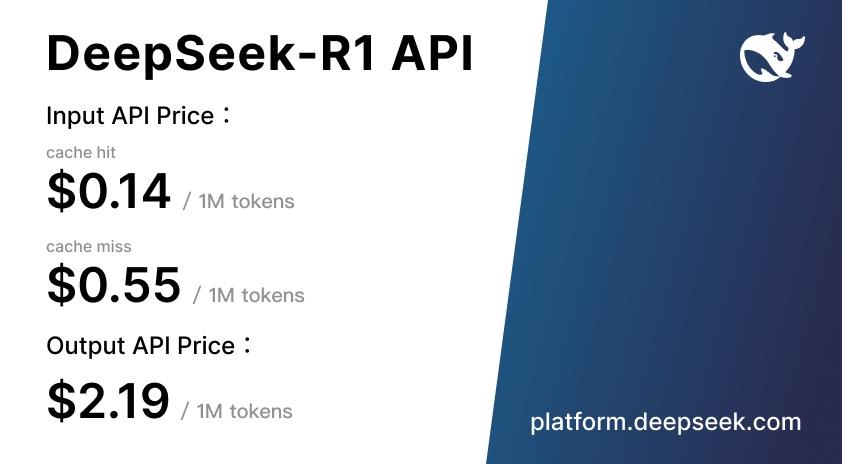

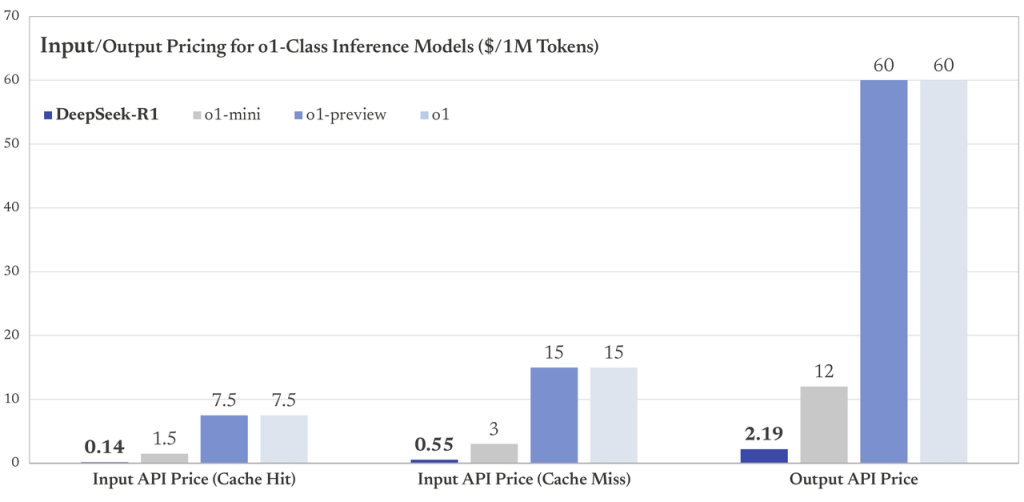

- Coste y disponibilidad: Al ser un proyecto abierto, la API de DeepSeek R1 tiene un costo significativamente menor comparado con APIs propietarias equivalentes. Según información proporcionada, el costo aproximado es de $0.14 por millón de tokens de entrada procesados (para casos de uso en que el resultado ya esté en caché), lo que la hace una opción muy competitiva en términos económicos para aplicaciones que requieran procesar grandes volúmenes de texto. Cabe destacar que la infraestructura de DeepSeek está optimizada para razonamiento, de modo que consultas complejas pueden aprovechar la potencia del modelo sin incurrir en costos prohibitivos.

En resumen, la vía de API es ideal para desarrolladores que quieran incorporar las capacidades de DeepSeek R1 en aplicaciones web, móviles o sistemas backend sin preocuparse por desplegar la infraestructura completa del modelo.

Por ejemplo, se podría integrar DeepSeek R1 en un editor de código como asistente inteligente para sugerir funciones o corregir errores; o en un chatbot avanzado dentro de una plataforma educativa que explique conceptos científicos paso a paso, todo ello consumiendo la API con llamadas remotas sencillas.

Implementación local y modelos destilados

Para casos en que la latencia, la privacidad de los datos o la personalización del modelo sean críticas, DeepSeek R1 también puede desplegarse localmente.

Dado que el modelo completo es muy grande (671B parámetros), su ejecución exige hardware de alta gama; por ejemplo, se recomienda disponer de GPUs con gran cantidad de VRAM (una tarjeta Nvidia RTX 3090 o superior es aconsejable) o alternativamente un servidor con decenas de gigabytes de RAM para ejecución en CPU.

En particular, para cargar el modelo completo en CPU se mencionan requerimientos del orden de ≥48 GB de RAM y unos 250 GB de espacio en disco para almacenarlo, aunque la generación sin aceleración GPU sería bastante lenta. Esto refleja la magnitud del modelo, que realmente está pensado para entornos computacionales robustos.

Consciente de que no todos los desarrolladores cuentan con ese nivel de hardware, el equipo de DeepSeek ha puesto a disposición versiones destiladas de DeepSeek R1. Un modelo destilado es una versión reducida en tamaño, que conserva en lo posible el conocimiento y habilidades del modelo grande, pero con muchos menos parámetros.

En el caso de DeepSeek R1, se liberaron seis variantes destiladas con tamaños de 1.5B, 7B, 8B, 14B, 32B y 70B parámetros. Estas versiones se han entrenado tomando modelos abiertos populares (por ejemplo, basados en las familias Qwen 2.5 y Llama 3) y afinándolos con datos sintéticos de razonamiento generados por el modelo R1 completo Así, logran encapsular los patrones de razonamiento complejos del modelo grande en redes más pequeñas, conservando un rendimiento notable en tareas de lógica.

De hecho, se reporta que el modelo destilado de 32B parámetros alcanzó nuevos récords de desempeño en benchmarks de razonamiento entre modelos densos (no MoE), superando incluso a modelos abiertos de mayor tamaño que habían sido entrenados de manera tradicional.

Esto confirma que la distilación fue efectiva: los modelos pequeños son eficientes y mantienen gran parte de la capacidad de DeepSeek R1.

Ejecutando DeepSeek R1 localmente: Con las variantes destiladas, muchos desarrolladores pueden ejecutar DeepSeek R1 en hardware más modesto. as variantes destiladas, muchos desarrolladores pueden ejecutar DeepSeek R1 en hardware más modesto. Por ejemplo, un modelo de 7B parámetros puede funcionar en una GPU de ~6 GB VRAM, e incluso en CPU con ~4 GB de RAM si se utilizan formatos optimizados como GGML/GGUF. Los modelos de 14B y 32B probablemente requieran GPUs de 16 GB o 24 GB para un rendimiento fluido, mientras que la variante de 70B parámetros podría correr en una GPU de 48 GB (o en múltiples GPUs en paralelo). Todas las versiones, incluyendo la de 70B, son significativamente más accesibles en términos de hardware que el modelo completo de 671B, y aun así brindan excelente desempeño para la mayoría de casos de uso.

Por ejemplo, un modelo de 7B parámetros puede funcionar en una GPU de ~6 GB VRAM, e incluso en CPU con ~4 GB de RAM si se utilizan formatos optimizados como GGML/GGUF.

Los modelos de 14B y 32B probablemente requieran GPUs de 16 GB o 24 GB para un rendimiento fluido, mientras que la variante de 70B parámetros podría correr en una GPU de 48 GB (o en múltiples GPUs en paralelo).

Todas las versiones, incluyendo la de 70B, son significativamente más accesibles en términos de hardware que el modelo completo de 671B, y aun así brindan excelente desempeño para la mayoría de casos de uso.

La comunidad ha desarrollado diversas herramientas para facilitar la carga y ejecución local de DeepSeek R1 en sus distintos tamaños. Algunas opciones populares incluyen:

- Ollama: Una herramienta que permite descargar y servir modelos de lenguaje abiertos de forma local. DeepSeek R1 (en tamaños desde 1.5B hasta 70B) se puede ejecutar con Ollama mediante comandos sencillos – básicamente, seleccionar la variante según el equilibrio velocidad vs. capacidad requerido (modelos más grandes responden mejor, pero requieren mejor GPU). Por ejemplo, con Ollama instalado, un desarrollador puede iniciar el modelo de 8B parámetros simplemente con

ollama run deepseek-r1:8ben la terminal. Ollama también expone un endpoint local (usando REST enlocalhost) para interactuar con el modelo, facilitando pruebas rápidas y la integración con aplicaciones locales vía HTTP. - vLLM / SGLang: Son frameworks optimizados para servir LLMs con alta eficiencia de memoria y throughput. DeepSeek R1 y especialmente sus variantes destiladas se pueden montar en un servidor vLLM; por ejemplo, cargando el modelo destilado de 32B con comandos provistos por la comunidad. Estas herramientas aprovechan técnicas de paginación de tensores y ejecución distribuida para manejar contextos grandes (recordemos que R1 soporta 128K tokens) de manera viable en hardware limitado.

- llama.cpp: Para quienes prefieren ejecutar en CPU o en dispositivos edge, la compatibilidad con llama.cpp es una gran ventaja. Los modelos destilados en formato GGML/GGUF pueden correr bajo llama.cpp, posibilitando por ejemplo correr la versión de 7B o incluso 14B completamente en CPU a costa de menor velocidad. De hecho, entusiastas han logrado correr la variante de 1.5B directamente en un navegador web móvil utilizando WebGPU, o en dispositivos como smartphones, mostrando la flexibilidad que ofrece tener modelos más pequeños con el “sabor” de DeepSeek R1.

Todas estas opciones significan que los desarrolladores tienen libertad para desplegar DeepSeek R1 según sus necesidades específicas: ya sea como servicio cloud vía API para escalabilidad inmediata, o embebido localmente para control total y cero dependencias externas.

Además, al ser código abierto bajo licencia MIT, no hay restricciones fuertes en cuanto a su uso comercial o modificación. Esto permite incorporar DeepSeek R1 en productos empresariales, realizar fine-tuning adicional para dominios específicos, o incluso usar su salida de razonamiento para entrenar nuevos modelos.

La licencia abierta fomenta la colaboración y la innovación comunitaria, evidenciada por la multitud de proyectos que ya están construyéndose alrededor de R1.

Ejemplos de casos de uso prácticos

DeepSeek R1 abre un abanico de posibilidades para soluciones inteligentes centradas en el razonamiento. A continuación, se presentan algunos casos de uso prácticos orientados a desarrolladores, donde este modelo puede marcar la diferencia:

- Asistentes de programación y depuración de código: Gracias a su notable habilidad para comprender y generar código fuente, DeepSeek R1 puede integrarse como el motor detrás de asistentes de desarrollo. Por ejemplo, en entornos de IDE, podría sugerir fragmentos de código correctos dado un comentario o descripción, autocompletar funciones complejas, o incluso encontrar bugs lógicos en una porción de código existente explicando por qué cierta sección podría fallar. Su entrenamiento en razonamiento le permite explicar la lógica de sus sugerencias, algo muy valioso en entornos educativos o para revisiones de code review. Un caso de uso específico podría ser un bot de GitHub que, al abrirse un pull request, utiliza DeepSeek R1 para analizar el código modificado y comenta automáticamente posibles mejoras o errores, proporcionando justificativos detallados.

- Resolución automatizada de problemas matemáticos y científicos: Dado que DeepSeek R1 fue afinado para dominar dominios lógicos como matemáticas y análisis científico, se puede emplear en herramientas que resuelvan problemas técnicos paso a paso. Por ejemplo, una aplicación móvil educativa podría permitir al usuario fotografiar un problema de álgebra o cálculo, y DeepSeek R1 no solo entregaría la solución, sino que generaría una explicación detallada de cada paso para llegar a dicha solución. En investigación científica, un asistente impulsado por R1 podría ayudar a explorar hipótesis o responder preguntas complejas basadas en literatura, elaborando respuestas bien estructuradas con argumentos lógicos. Su capacidad de manejar contextos amplios también significa que podría leer un artículo extenso o un conjunto de documentos y luego responder preguntas puntuales razonando con la información combinada.

- Chatbots avanzados con razonamiento profundo: En contraste con los chatbots convencionales que a veces se limitan a respuestas genéricas, un chatbot potenciado por DeepSeek R1 podría involucrarse en diálogos complejos que requieran pensar varios pasos adelante. Por ejemplo, en el soporte técnico de software, el bot podría diagnosticar un problema interactuando con el usuario: preguntando por síntomas, analizando posibilidades y proponiendo soluciones de manera lógica. Incluso en entretenimiento o simulación, un bot con R1 podría participar en juegos de acertijos o role-playing donde necesita deducir pistas y mantenerse consistente en la trama. Su habilidad de “pensar en voz alta” (es decir, ofrecer una cadena de pensamiento) puede hacer al chatbot más transparente, explicando al usuario por qué da cierta recomendación u opción, incrementando la confianza en sus respuestas.

- Análisis de datos y generación de informes estructurados: Para desarrolladores que trabajen con análisis de datos o flujos de ETL, DeepSeek R1 puede servir como un componente de generación de reportes o documentación inteligente. Por ejemplo, tras procesar ciertos datos, se le puede pedir al modelo que genere un informe en lenguaje natural con las conclusiones, enumerando los hallazgos clave y explicando las tendencias. Si se integra con herramientas de business intelligence, R1 podría recibir las cifras y automáticamente producir un resumen escrito con insights, simulando el trabajo de un analista humano. La ventaja es que, al tener capacidad de razonamiento, no se limita a repetir datos sino que puede inferir implicaciones lógicas (como “un aumento en X puede deberse a Y, dado que…”) respaldando sus afirmaciones en los datos proporcionados.

En todos estos casos, un factor común es que DeepSeek R1 aporta razonamiento de nivel humano a la solución.

Los desarrolladores pueden enfocarse en la interfaz y la experiencia de usuario, delegando a R1 la tarea de procesar lógicamente la petición y generar un resultado útil.

Además, por ser open-source, pueden depurar y entender cómo el modelo llega a sus respuestas (inspeccionando las cadenas de pensamiento si se habilitan), lo cual es especialmente útil en entornos donde la auditabilidad y explicabilidad son necesarias.

Conclusión

DeepSeek R1 representa un avance significativo en la intersección de modelos de lenguaje y razonamiento automatizado.

Su arquitectura técnica combina escala masiva y eficiencia, su entrenamiento innovador basado en aprendizaje por refuerzo le ha dotado de habilidades de auto-mejora y auto-verificación, y sus capacidades destacadas lo posicionan como una herramienta extremadamente poderosa en el arsenal de cualquier desarrollador que necesite soluciones inteligentes.

Al estar disponible como proyecto abierto bajo licencia permisiva MIT, con opciones flexibles de despliegue (API en la nube o ejecución local con modelos destilados), DeepSeek R1 democratiza el acceso a un modelo de lenguaje de nivel vanguardista.

Para la comunidad de desarrolladores, esto se traduce en la oportunidad de construir aplicaciones más inteligentes: desde asistentes de código más comprensivos hasta sistemas de tutoría automatizada que realmente “piensan” las respuestas.

Con DeepSeek R1, el énfasis está en la calidad del razonamiento tanto como en la calidad del lenguaje, marcando un paso adelante hacia modelos de IA que no solo generen texto, sino que ofrezcan soluciones fundamentadas paso a paso.

Su llegada refuerza la tendencia de los modelos open-source de alto rendimiento, demostrando que la colaboración abierta puede producir tecnologías que compiten con las alternativas privativas de primer nivel en capacidad y versatilidad.

En definitiva, DeepSeek R1 es una plataforma robusta sobre la cual los desarrolladores pueden innovar, creando la próxima generación de aplicaciones inteligentes impulsadas por IA.