DeepSeek V3 es un modelo de lenguaje de última generación orientado a desarrolladores, ingenieros de software y arquitectos de IA.

Se trata de un Large Language Model (LLM) de código abierto basado en una arquitectura Mixture-of-Experts (MoE) que combina un tamaño masivo con una ejecución eficiente.

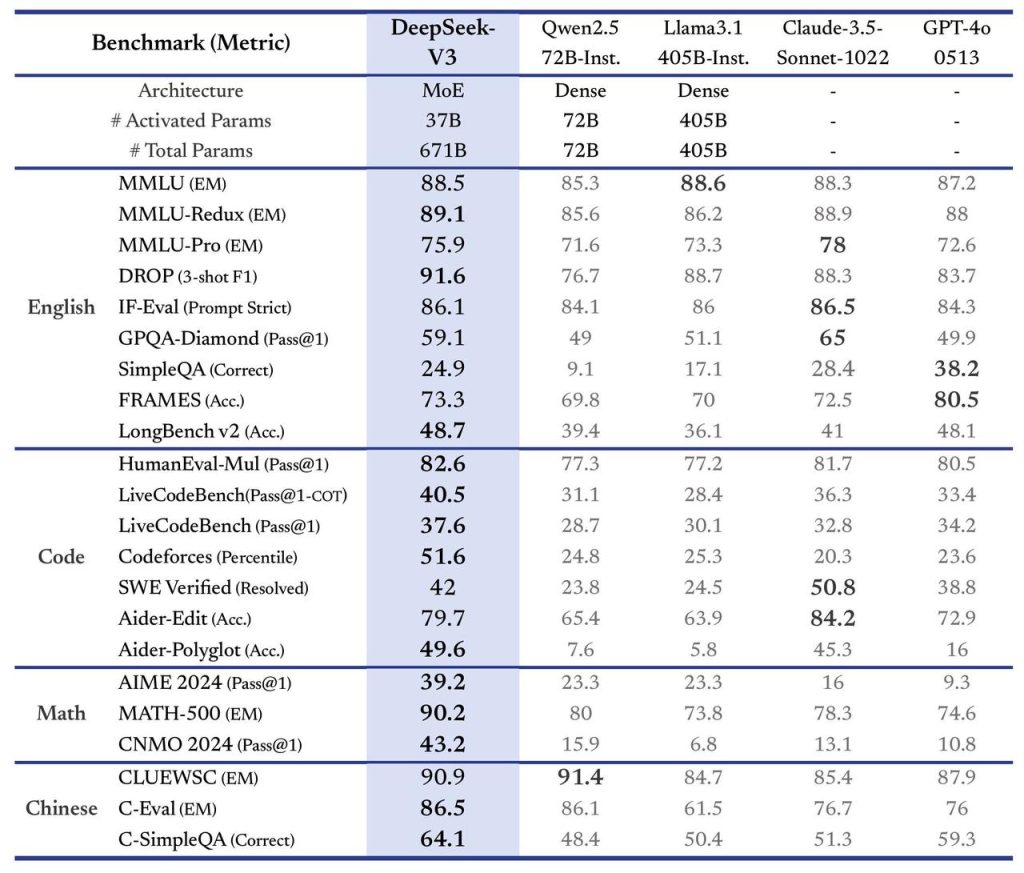

Con 671 mil millones de parámetros en total –de los cuales solo 37 mil millones se activan por token– DeepSeek V3 logra ofrecer la capacidad de un modelo enorme con la velocidad de uno más pequeño.

Fue entrenado con 14,8 billones de tokens de datos diversos y de alta calidad, lo que le permite destacar en tareas complejas como la generación y análisis de código, razonamiento matemático y comprensión multilingüe.

A continuación, exploramos en detalle su arquitectura técnica, sus capacidades avanzadas (razonamiento paso a paso, uso de herramientas, manejo de código) y cómo se integra este modelo en entornos de desarrollo y producción.

Arquitectura del Modelo DeepSeek V3

DeepSeek V3 adopta una arquitectura Mixture-of-Experts (Mezcla de Expertos) innovadora y optimizada para eficiencia.

En lugar de utilizar todos los parámetros para cada palabra procesada, el modelo activa dinámicamente solo un subconjunto de sus parámetros (los “expertos” relevantes) para cada token de entrada.

Gracias a esta técnica, el modelo mantiene un recuento activo de ~37B de parámetros por token frente al total de 671B, lo que equilibra gran capacidad de conocimiento con alta eficiencia en la inferencia.

En términos prácticos, esto significa que DeepSeek V3 ofrece las capacidades de un modelo masivo con un costo computacional similar al de modelos más pequeños, beneficiando tanto la velocidad de respuesta como el uso de recursos.

Entre las innovaciones técnicas clave de la arquitectura se incluye la Atención Latente Multicabeza (Multi-Head Latent Attention, MLA) y el núcleo DeepSeekMoE.

El mecanismo MLA permite “comprimir” la información de atención en vectores latentes más pequeños, reduciendo drásticamente los requisitos de memoria para secuencias largas sin sacrificar la capacidad de enfocarse en múltiples aspectos de la entrada.

Junto a MLA, DeepSeek V3 implementa una estrategia de balanceo de carga sin pérdida auxiliar, es decir, logra distribuir el trabajo entre sus expertos sin recurrir a términos de pérdida auxiliares que pudieran degradar el rendimiento.

Esta estrategia innovadora mantiene estable el entrenamiento y evita los típicos compromisos de desempeño de otros modelos MoE que dependen de penalizaciones artificiales.

Otra mejora fundamental es la introducción de un objetivo de Predicción Multi-Token (MTP) durante el entrenamiento.

En lugar de predecir un token a la vez, el modelo aprende a anticipar varios tokens en paralelo, lo que aumenta el rendimiento y habilita la decodificación especulativa para acelerar la generación de texto.

En la práctica, esta capacidad se traduce en inferencias más rápidas sin perder coherencia, optimizando la fluidez de las respuestas.

Adicionalmente, DeepSeek V3 fue entrenado con un esquema de precisión mixta FP8, combinando hardware y algoritmos personalizados para escalar el entrenamiento de MoE de forma eficiente.

El uso de FP8 (8-bit floating point) reduce memoria y tiempo de cómputo, permitiendo completar el pre-entrenamiento en ~2,8 millones de horas de GPU H800 con notable estabilidad (sin picos de pérdida irreversibles).

En resumen, la arquitectura de DeepSeek V3 está diseñada para maximizar el rendimiento y la eficiencia: ofrece un modelo de enorme capacidad con costos de inferencia y entrenamiento relativamente contenidos.

Ventana de Contexto Extensa (128K tokens)

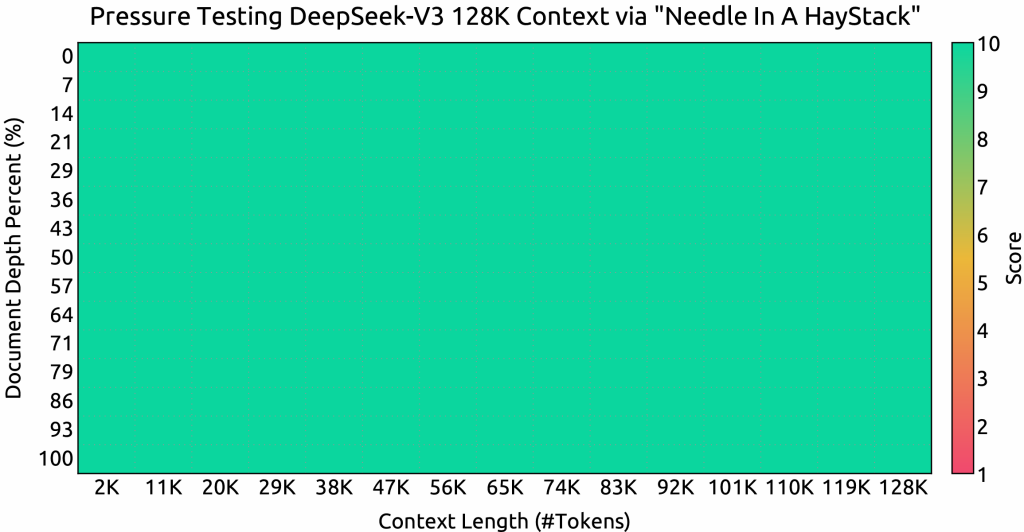

Una característica sobresaliente de DeepSeek V3 es su ventana de contexto ultra-extensa de 128.000 tokens.

En otras palabras, el modelo puede procesar entradas o conversaciones de hasta 128K tokens (equivalente a decenas de miles de palabras) en una sola consulta, sin fragmentar el contexto.

Esta ventana de contexto masiva le permite manejar entradas de gran volumen, como archivos de código completos, registros extensos, documentación técnica o múltiples documentos concatenados, manteniendo la coherencia y recordando detalles a lo largo del texto.

Gracias a mejoras en la atención y optimizaciones de memoria (como MLA mencionado), DeepSeek V3 aprovecha efectivamente este largo contexto sin degradación significativa del rendimiento hasta el máximo de 128K.

En escenarios prácticos, la amplia ventana de contexto significa que un desarrollador puede, por ejemplo, proporcionar a la IA todo el contenido de un repositorio de código o un informe extenso y obtener un análisis o resumen completo en una sola interacción.

Del mismo modo, para asistentes conversacionales, DeepSeek V3 puede mantener el hilo de diálogos muy prolongados o con gran cantidad de información previa, algo que supera con creces las limitaciones típicas de otros modelos.

Esto habilita casos de uso antes inviables, como análisis de logs voluminosos, depuración de código en contexto de múltiples archivos, o responder preguntas sobre bases de conocimiento enteras, todo ello en una sola sesión contextual.

En definitiva, la ventana de 128K tokens posiciona a DeepSeek V3 como una herramienta ideal para tareas que involucran contenido de larga extensión o contexto complejo de múltiples partes, sin requerir dividir manualmente la información.

Razonamiento Avanzado Paso a Paso (Chain-of-Thought)

Además de su potencia bruta, DeepSeek V3 destaca por sus capacidades de razonamiento avanzado. Mediante técnicas de entrenamiento especializadas, el modelo incorpora patrones de “cadena de pensamiento” (Chain-of-Thought, CoT), es decir, la habilidad de desarrollar razonamientos paso a paso antes de arribar a una respuesta final.

Este enfoque le permite descomponer preguntas o problemas complejos en pasos intermedios lógicos, verificar sus propios cálculos o deducciones, y producir respuestas más fundamentadas.

En la práctica, DeepSeek V3 ofrece razonamiento y comprensión avanzados, pudiendo abordar con éxito tareas complejas que requieran múltiples pasos de deducción, como resolución de problemas matemáticos, lógicas intrincadas o análisis detallados de código.

El modelo ha sido afinado para seguir instrucciones de verificación y reflexión internas (inspiradas en un modelo orientado a razonamiento de la serie R1 de la misma familia), integrando estas habilidades sin sacrificar su estilo de respuesta controlado.

Gracias a ello, DeepSeek V3 consigue respuestas más coherentes y con mejor flujo lógico, manteniendo un control sobre la extensión y formato de sus explicaciones. Para los desarrolladores, esto significa que al consultar al modelo sobre, por ejemplo, depuración de un algoritmo o explicación de un bloque de código, es capaz de explicar paso a paso su análisis, llegando a conclusiones más precisas.

Esta capacidad de razonamiento estructurado es particularmente útil en ámbitos como la resolución de problemas matemáticos complejos, donde DeepSeek V3 demuestra un desempeño sobresaliente, o en tareas de programación en las que se beneficia de planificar la solución antes de generar código.

En resumen, la habilidad de “pensar paso a paso” convierte a DeepSeek V3 en una herramienta confiable para tareas que requieren pensamiento crítico y justificación en sus respuestas.

Uso de Herramientas Externas y Funciones (Tool Use)

Un aspecto importante para integraciones avanzadas es que DeepSeek V3 soporta el uso de herramientas externas mediante llamadas de función (funcionalidad conocida como Function Calling en su API).

Esto quiere decir que el modelo puede, ante ciertas instrucciones, devolver una invocación a una función definida por el desarrollador en lugar de una respuesta directa, permitiendo ampliar sus capacidades con acciones externas. Por ejemplo, DeepSeek V3 puede sugerir realizar una búsqueda web o consultar una base de datos si la pregunta lo requiere, mediante una función herramienta apropiada.

De hecho, el modelo es capaz de realizar búsquedas web, ejecutar cálculos u otras acciones si se le proveen las funciones correspondientes, gracias a esta integración de herramientas.

En la práctica, el desarrollador puede definir funciones (por ejemplo: buscar_web(), consultar_clima(), ejecutar_sql()) y el modelo decidirá llamar a esas funciones con los parámetros adecuados cuando sea pertinente, en lugar de intentar responder solo con el conocimiento entrenado.

Esto habilita casos de uso como asistentes que consultan información actualizada en tiempo real, agentes que interactúan con servicios (p. ej., obtener el clima actual, cotizaciones financieras, o datos de una API interna), o sistemas que requieren acciones como enviar correos o actualizar registros.

DeepSeek V3 maneja el formato JSON de llamada de función de forma compatible con el esquema de OpenAI, por lo que los desarrolladores familiarizados con ChatGPT pueden aprovechar un flujo similar para herramientas en DeepSeek.

En resumen, mediante el uso de tools externos, este modelo puede trascender sus límites de entrenamiento e integrarse de forma inteligente en pipelines de software más amplios, combinando generación de lenguaje con acciones del mundo real.

Procesamiento y Generación de Código Fuente

Dirigido especialmente a programadores, DeepSeek V3 muestra capacidades sobresalientes en tareas de código.

Gracias a su ingente corpus de entrenamiento (que incluyó una porción significativa de código fuente multilenguaje y documentación), el modelo puede entender, generar y refactorizar código en varios lenguajes de programación. Ha obtenido puntajes de primer nivel en evaluaciones estándar de generación de código, demostrando aptitud para resolver problemas de programación, completar funciones y detectar errores lógicos.

De hecho, DeepSeek V3 destaca en generación y análisis de código, siendo capaz de producir soluciones funcionales a partir de descripciones en lenguaje natural y de revisar código existente en busca de mejoras o correcciones.

Por ejemplo, es posible suministrar al modelo un fragmento de código junto con una petición como “encuentra bugs y sugiere optimizaciones”, y DeepSeek V3 entregará una revisión detallada.

Sus respuestas pueden incluir explicaciones línea por línea, señalamiento de posibles excepciones no manejadas, recomendaciones de refactoring e incluso ejemplos de código alternativo.

Esta habilidad lo vuelve muy útil para construir asistentes de programación, ya sea como complementos de IDE que ofrezcan autocompletado inteligente, revisión automatizada de pull requests, o chatbots de ayuda para desarrolladores.

Un caso ilustrativo es un asistente de revisión de código integrado con DeepSeek V3: dada una porción de código, el modelo genera comentarios perspicaces sobre posibles errores y mejoras, todo a través de una interfaz sencilla.

La posibilidad de procesar hasta 128K tokens también implica que puede revisar proyectos enteros o múltiples archivos a la vez, ofreciendo retroalimentación consistente en contextos de código amplios.

En suma, DeepSeek V3 se posiciona como una potente herramienta para el desarrollo de software, capaz de entender instrucciones técnicas y producir código de alta calidad, facilitando tareas que van desde la generación de funciones triviales hasta la resolución de desafíos algorítmicos complejos.

Integración e Implementación en Entornos de Desarrollo y Producción

Uno de los objetivos de DeepSeek V3 es ser fácilmente integrable en proyectos reales, tanto durante el desarrollo inicial como en despliegues de producción a gran escala.

A diferencia de algunos modelos cerrados, DeepSeek V3 se ofrece abiertamente, lo que brinda flexibilidad para utilizarlo vía API alojada o mediante implementación local según las necesidades de cada proyecto.

A continuación, describimos las opciones y consideraciones para su uso en distintos entornos:

Integración vía API (servicio en la nube)

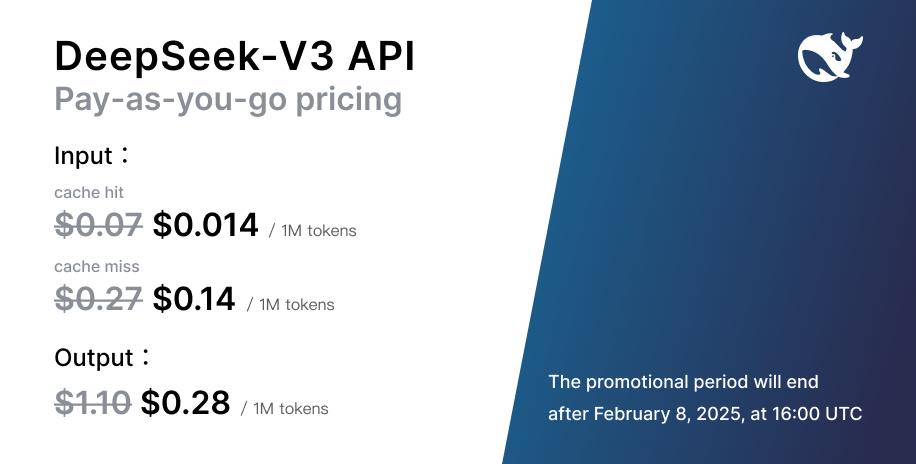

La forma más sencilla de comenzar a usar DeepSeek V3 es a través de su API en la nube, ofrecida por la plataforma oficial de DeepSeek.

Esta API es compatible con la API de OpenAI, lo que significa que los desarrolladores pueden interactuar con DeepSeek V3 utilizando formatos y endpoints muy similares a los de modelos como GPT-4 o ChatGPT.

En la práctica, basta con obtener una clave de API desde el sitio de DeepSeek (registro gratuito disponible) y luego realizar solicitudes HTTP POST al endpoint de chat o completado, especificando el modelo "deepseek-chat" y enviando mensajes en formato JSON. Las librerías existentes de OpenAI se pueden reutilizar cambiando el base_url a https://api.deepseek.com, facilitando enormemente la integración.

Por ejemplo, un desarrollador puede prototipar un chatbot conversacional o un asistente de código en cuestión de minutos consumiendo la API de DeepSeek V3 tal como lo haría con ChatGPT.

La latencia y velocidad de inferencia son competitivas: el modelo puede procesar ~60 tokens por segundo, permitiendo respuestas bastante rápidas incluso para consultas largas.

Además, el servicio en la nube ofrece escalabilidad automática y evita al equipo de desarrollo tener que gestionar infraestructura pesada durante la fase de prototipado.

Es importante señalar que tanto el modelo base como una versión instruccional afinada para chat (DeepSeek V3 Chat) están disponibles vía API, según se requiera respuestas más libres o alineadas a instrucciones de usuario.

En entornos de producción, la integración vía API resulta ideal para aplicaciones que necesitan actualizaciones del modelo sin mantenimiento (ya que el proveedor se encarga de versiones y optimizaciones) o para proyectos con requerimientos variables de escala.

Despliegue Local y Auto-Hospedaje del Modelo

Para organizaciones o proyectos que requieren control total sobre el modelo, DeepSeek V3 permite su descarga e implementación local, dado que sus pesos y código son completamente abiertos.

Esto posibilita integrar el modelo en entornos on-premise o nubes privadas, aplicar fine-tuning específico de dominio, o experimentar con personalizaciones en la inferencia. Sin embargo, debido al tamaño colosal de DeepSeek V3, el despliegue local conlleva ciertos requisitos de infraestructura importantes.

Se recomienda contar con GPU(s) de alta capacidad (NVIDIA A100/H100 o equivalentes) o incluso aceleradores alternativos como GPUs AMD de alto nivel o NPUs Huawei Ascend, ya que el framework de DeepSeek soporta explícitamente estas plataformas.

De hecho, el modelo ha sido probado con éxito en hardware diverso y ofrece soporte de inferencia en modos FP8 y BF16 tanto en GPUs NVIDIA como AMD, así como en NPUs dedicadas.

Para manejar el modelo completo en RAM de GPU, es necesario un entorno con cientos de GB de memoria disponible; por ello, típicamente se recurre a técnicas de paralelismo y cuantización para viabilizar la carga. Por ejemplo, con cuantización a 4 bits (INT4) el modelo ocupa alrededor de ~350 GB de VRAM, lo que puede distribuirse en múltiples tarjetas GPU en paralelo.

Asimismo, DeepSeek V3 se integra con frameworks de inferencia optimizados como SGLang, LMDeploy, TensorRT-LLM y vLLM, que ayudan a orquestar la carga en varios dispositivos y a aprovechar la estructura MoE eficientemente.

Gracias a estas herramientas, es posible ejecutar inferencias de DeepSeek V3 en tiempo razonable incluso en entornos locales potentes (por ejemplo, se reporta ~20 tokens/segundo en estaciones de trabajo de gama alta con GPUs múltiples).

En resumen, aunque el auto-hospedaje de DeepSeek V3 requiere inversión en hardware, ofrece la posibilidad de integrar el modelo directamente en la infraestructura del producto, mantener datos sensibles internamente y personalizar el comportamiento del LLM a un nivel más profundo.

Casos de Uso y Ejemplos Prácticos

DeepSeek V3, por sus características, se adapta a numerosos casos de uso en la industria del software y la inteligencia artificial.

A continuación, se enumeran algunos ejemplos prácticos de proyectos donde este modelo puede brindar un valor notable:

- Asistente Inteligente de Programación: Integrando DeepSeek V3 en entornos de desarrollo, es posible crear asistentes tipo pair-programmer. Por ejemplo, un complemento de IDE o bot de chat que genera funciones, detecta bugs y sugiere refactorizaciones en tiempo real a partir de descripciones en lenguaje natural. Gracias a su capacidad de razonamiento y manejo de código, el modelo puede analizar bloques completos de código y ofrecer feedback detallado en contexto.

- Análisis de Documentos Extensos: En el ámbito empresarial o legal, DeepSeek V3 puede resumir y analizar documentos de gran longitud (contratos, informes técnicos, logs de aplicaciones). Su ventana de 128K tokens le permite ingerir textos muy largos de una sola vez y extraer conclusiones, responder preguntas específicas o generar resúmenes ejecutivos, agilizando labores de investigación y reporte.

- Chatbots Avanzados Multilingües: Gracias a su entrenamiento multilingüe y alto desempeño en comprensión de idiomas, se puede emplear DeepSeek V3 para desarrollar asistentes virtuales que hablen varios idiomas (incluyendo español) con alto grado de comprensión. Estos chatbots podrían atender clientes en soporte técnico, responder consultas en e-commerce o servir de tutores inteligentes, manteniendo conversaciones coherentes y contextualizadas aun a lo largo de cientos de turnos de diálogo.

- Agentes con Acceso a Herramientas: Combinando la función de tool use, es viable crear agentes de IA que interactúen con servicios externos. Por ejemplo, un agente de negocios con DeepSeek V3 podría consultar APIs financieras para obtener cotizaciones actualizadas, realizar cálculos avanzados con una calculadora externa, o buscar información en la web para enriquecer sus respuestas. Esto extiende su utilidad a escenarios como asistentes de investigación que pueden buscar referencias bibliográficas, o bots domóticos que ejecutan acciones en el hogar inteligente según instrucciones en lenguaje natural.

- Generación de Contenido y Creatividad Asistida: Con su habilidad para producir texto coherente de forma controlada, DeepSeek V3 también puede ayudar en la creación de contenido: desde redactar documentación técnica a escribir artículos o posts informativos. Un arquitecto de soluciones IA podría integrar el modelo para generar automáticamente borradores de reportes a partir de datos crudos, o para traducir contenido técnico entre idiomas manteniendo el contexto, dado su fuerte desempeño en traducción y comprensión contextual.

En todos estos casos, el modelo se puede usar tanto durante la fase de desarrollo (experimentando con las capacidades de la IA para refinar la solución) como en producción (embebiendo el modelo o consumiendo su API para brindar funcionalidades inteligentes a los usuarios finales).

La licencia abierta de DeepSeek V3 y la disponibilidad de sus pesos facilitan la experimentación y la adaptación a casos de uso específicos, fomentando una adopción más amplia en la comunidad.

Con su combinación de arquitectura innovadora, rendimiento líder en tareas complejas y flexibilidad de implementación, DeepSeek V3 representa una herramienta de gran valor para llevar aplicaciones impulsadas por IA al siguiente nivel en entornos reales de desarrollo y producción.