DeepSeek Coder es un avanzado modelo de IA enfocado en programación, diseñado para facilitar la vida de los desarrolladores con generación automática de código, asistencia en depuración y documentación inteligente.

Se trata de un modelo de lenguaje para código (LLM especializado) entrenado con enormes cantidades de código fuente, capaz de entender y producir código en numerosos lenguajes de programación.

Al ser una herramienta de código abierto y libre, ofrece a los programadores un asistente de IA para desarrolladores sin las restricciones de modelos propietarios.

A continuación, exploraremos en detalle su arquitectura técnica y cómo puede integrarse en flujos de trabajo reales de desarrollo de software.

Arquitectura técnica de DeepSeek Coder

DeepSeek Coder destaca por una arquitectura optimizada para tareas de programación, combinando un gran tamaño de modelo con técnicas especializadas para maximizar la precisión sintáctica y semántica del código generado.

A grandes rasgos, consiste en una serie de modelos de lenguaje entrenados desde cero exclusivamente con datos de código y texto técnico, lo que le otorga un entendimiento profundo de la estructura y lógica de múltiples lenguajes de programación.

A continuación, resumimos sus características técnicas clave:

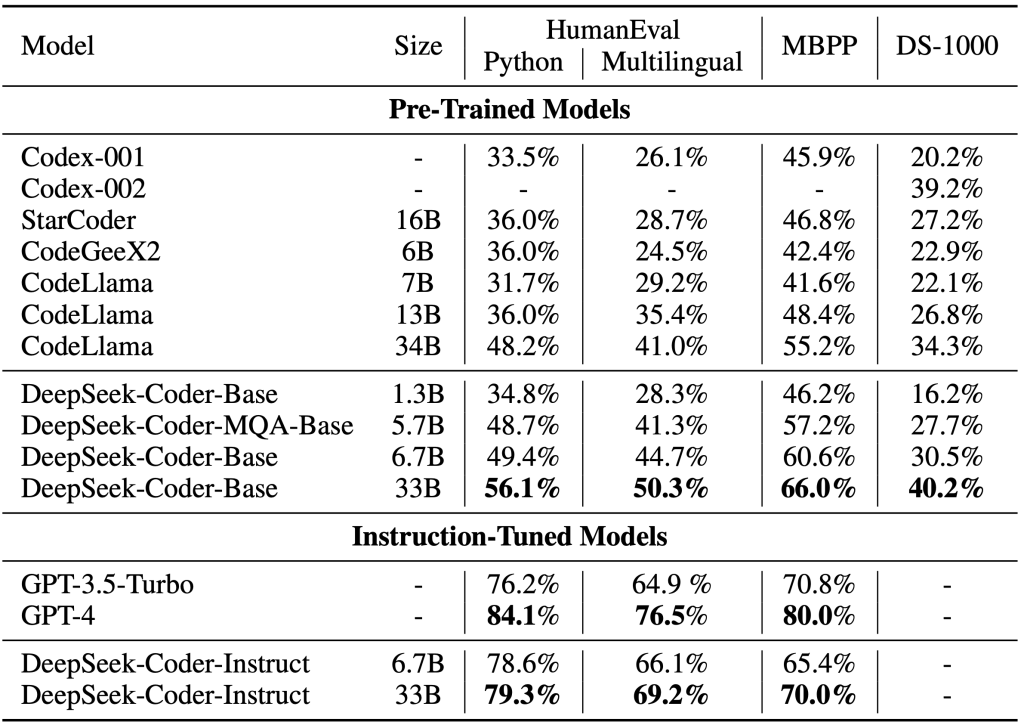

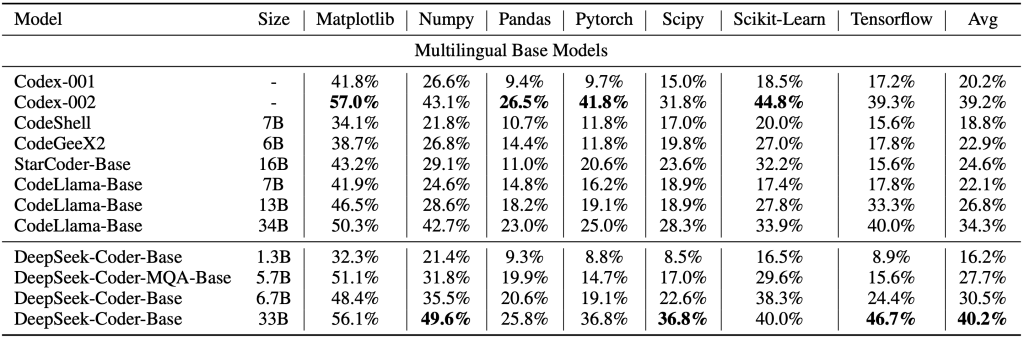

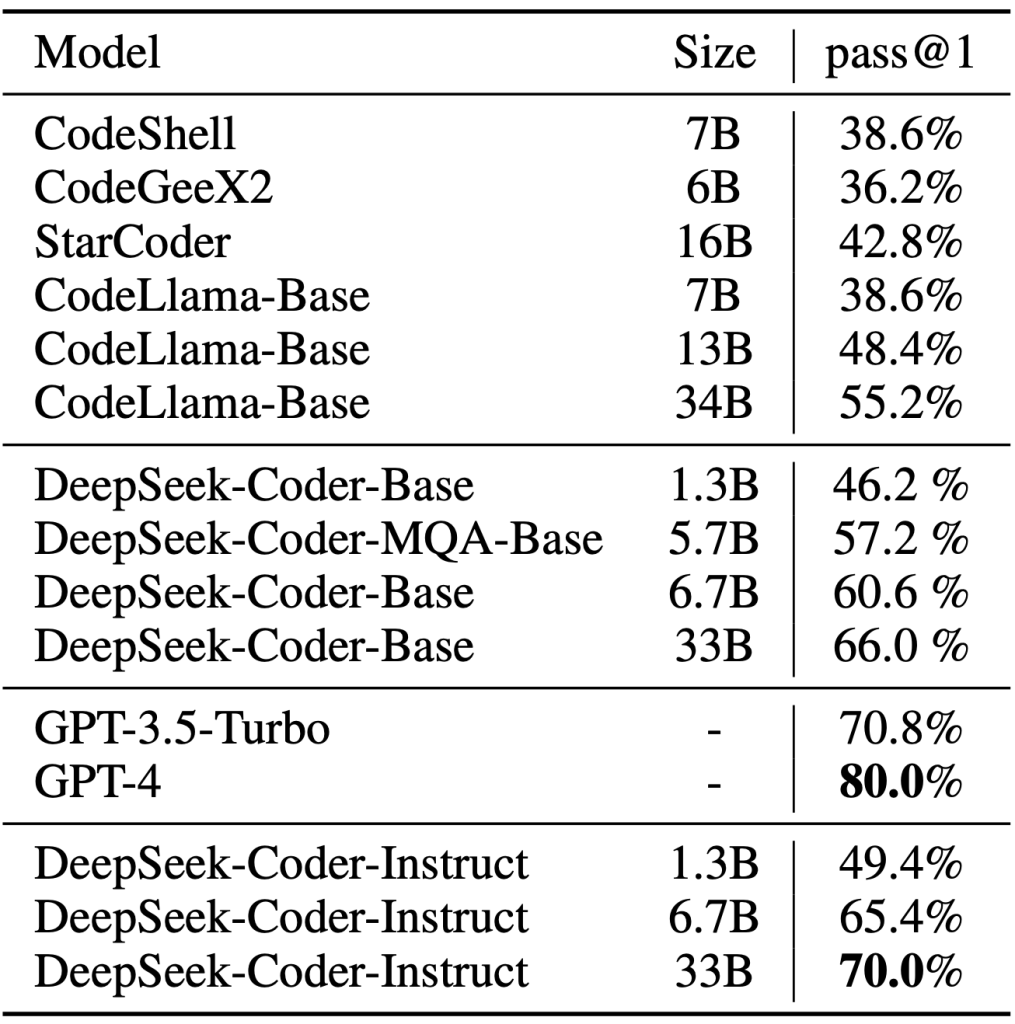

- Tamaños de modelo escalables: Está disponible en varias configuraciones de tamaño, desde modelos de ~1,3 mil millones hasta 33 mil millones de parámetros, para adaptarse a distintas necesidades de rendimiento y hardware. Esta variedad (1.3B, 5.7B, 6.7B y 33B) permite elegir un modelo más ligero para entornos con menos recursos, o uno de mayor tamaño para obtener máxima capacidad de generación y precisión.

- Entrenamiento masivo enfocado en código: Fue entrenado con un conjunto de datos enorme de aproximadamente 2 billones de tokens (fragmentos de texto), de los cuales el 87% proviene de código fuente real y un 13% de lenguaje natural relacionado (por ejemplo, documentación), principalmente en inglés y chino. Este énfasis en datos de código le permite “entender” los lenguajes de programación a un nivel muy profundo y generar y analizar código con alta competencia. El entrenamiento a escala tan grande, usando repositorios de código reales, proporciona conocimiento práctico que se refleja en la calidad de sus respuestas.

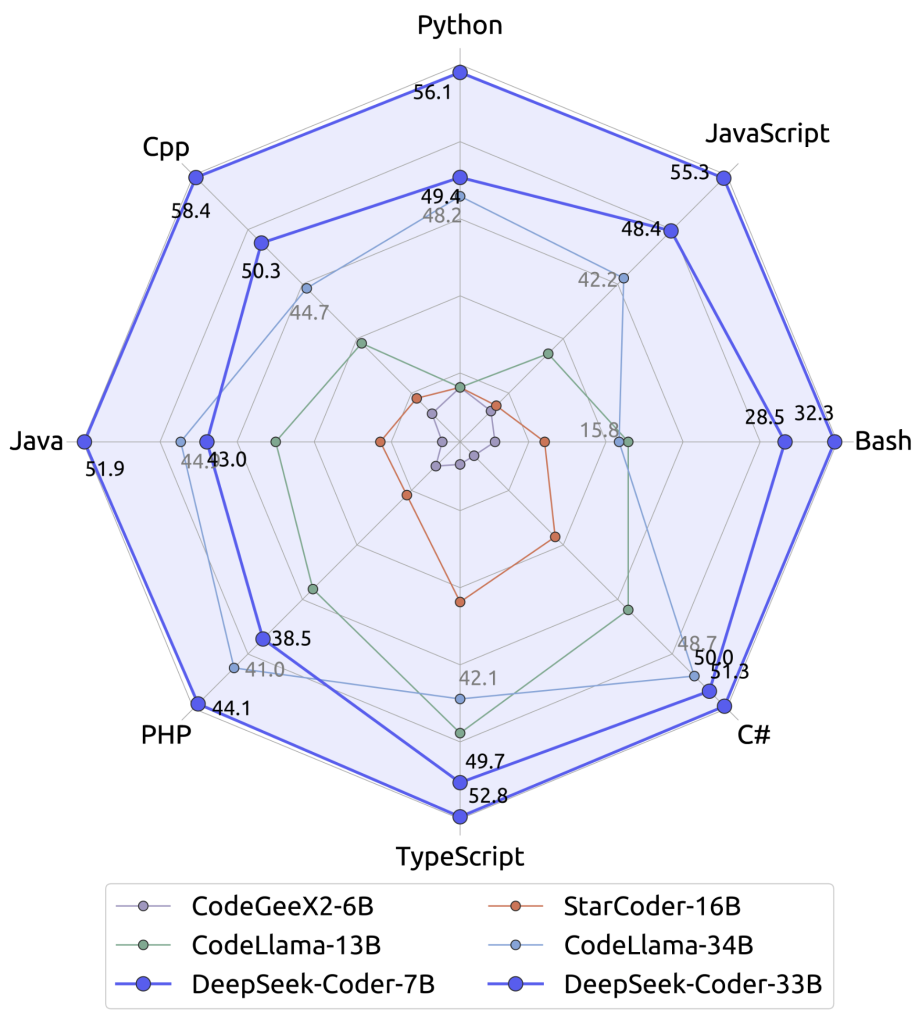

- Soporte multilenguaje de programación: DeepSeek Coder es capaz de trabajar con más de 80 lenguajes de programación de todo tipo. En su entrenamiento se incluyó una amplia variedad de lenguajes, desde los más populares (Python, JavaScript, Java, C++, Go, Ruby, etc.) hasta otros más especializados o antiguos (como Fortran, Lisp, Prolog, lenguajes de scripts, de consultas SQL, e incluso lenguajes de marcado). En total soporta decenas de lenguajes, lo que significa que un desarrollador puede obtener ayuda ya sea que esté escribiendo un script sencillo en Python, creando una página web en HTML/JavaScript o trabajando con código científico en MATLAB, por ejemplo. Esta cobertura multilenguaje hace de DeepSeek Coder un asistente versátil en entornos de desarrollo poliglotas.

- Capacidades lingüísticas y comprensión de instrucciones: Aunque el enfoque principal del modelo es la generación de código, también entiende lenguaje natural (gracias al 13% de datos no code). En concreto, soporta instrucciones en inglés y chino, reflejando la naturaleza bilingüe de su entrenamiento. Un desarrollador puede describir en texto una tarea o preguntar por una solución, y DeepSeek Coder interpretará la petición correctamente. Del mismo modo, puede producir explicaciones de código en lenguaje natural, por ejemplo describiendo en inglés (u otro idioma que domine) qué hace un fragmento de código. Esta capacidad de alternar entre código y lenguaje natural permite integrarlo fácilmente en flujos de trabajo donde las peticiones del usuario son descripciones textuales de problemas de programación.

- Ventana de contexto amplia (16K tokens) y tarea de infilling: La arquitectura de DeepSeek Coder está optimizada para completado de código a nivel de proyecto. Soporta una ventana de contexto de hasta 16.000 tokens (orden de decenas de páginas de código), muy superior a la mayoría de modelos genéricos. Esto significa que el modelo puede analizar y tener en cuenta archivos enteros o múltiples fragmentos de un proyecto a la vez, manteniendo la coherencia en sus respuestas. Gracias a técnicas de entrenamiento como fill-in-the-blank (rellenar huecos en el código), el modelo aprendió a insertar código en medio de archivos existentes de manera lógica. En la práctica, estas características le permiten no solo generar código desde cero, sino también completar funciones incompletas o sugerir código faltante dentro de un contexto grande, respetando las dependencias y el estilo circundante. Por ejemplo, puede completar los métodos faltantes de una clase teniendo en cuenta el resto del archivo, algo especialmente útil en bases de código extensas.

- Alta precisión sintáctica y semántica: Al haber sido entrenado con código fuente de alta calidad y aplicando un filtrado riguroso de datos, DeepSeek Coder tiende a generar código sintácticamente correcto y coherente con la intención deseada. Durante la preparación del corpus, se descartaron fragmentos de baja calidad, incluyendo código con errores de sintaxis o mal estructurado, lo que se traduce en que las salidas del modelo rara vez contienen errores básicos de compilación o sintaxis. Además, en evaluaciones estándar para medir la correctitud funcional del código (como el benchmark HumanEval, MBPP, MultiPL-E, etc.), ha alcanzado resultados de punta, compitiendo al nivel de los mejores modelos disponibles. En términos prácticos, esto implica que el código generado por DeepSeek Coder no solo compila, sino que suele resolver correctamente el problema planteado (precisión semántica), aproximándose a la solución que un desarrollador experto escribiría.

Usos prácticos de DeepSeek Coder en el desarrollo de software

Gracias a su arquitectura especializada, DeepSeek Coder actúa como un asistente de programación multiuso. Puede integrarse en distintas etapas del ciclo de desarrollo para automatizar tareas o proveer ayuda instantánea.

A continuación, se describen las principales aplicaciones prácticas y cómo los desarrolladores pueden aprovechar esta IA en su flujo de trabajo diario:

Generación automática de código desde descripciones

Una de las capacidades centrales de DeepSeek Coder es la generación de código a partir de instrucciones en lenguaje natural. El desarrollador puede describir verbalmente (en texto) la funcionalidad deseada, y el modelo producirá el código correspondiente de manera autónoma.

Por ejemplo, se le podría solicitar: «Escribe una función en Python que verifique si un número es primo» y DeepSeek Coder generará automáticamente la función completa en Python que realiza esa tarea.

Esta generación automática de código es posible gracias a su exposición a innumerables ejemplos de funciones y algoritmos durante el entrenamiento, lo que le permite inferir patrones comunes y aplicarlos a nuevas peticiones.

Además de crear código nuevo desde cero, el modelo también auto-completa fragmentos de código de forma inteligente.

Si el programador ha empezado a escribir una función o script y no lo ha terminado, DeepSeek Coder puede sugerir cómo continuarlo o completarlo. Dada su gran ventana de contexto, el sistema tiene en cuenta todo el entorno del código proporcionado para proponer la continuación más lógica y consistente.

Por ejemplo, si encuentra una firma de función y comentarios sobre lo que debe hacer, puede generar el bloque de implementación completo siguiendo esas indicaciones.

Este autocompletado funciona de manera similar a herramientas como GitHub Copilot en un IDE, con la diferencia de que DeepSeek Coder puede aprovechar un contexto mucho mayor (incluso miles de líneas) y se puede interactuar con él mediante lenguaje natural, permitiendo solicitudes más complejas o discusiones sobre el código generado.

Depuración y corrección de errores asistida por IA

Otra aplicación valiosa es la asistencia en la depuración de código. DeepSeek Coder puede actuar como un par de ojos extra analizando código problemático y sugiriendo correcciones.

Un desarrollador puede proporcionarle un fragmento de código que esté dando errores o un stack trace con un mensaje de error, y pedir ayuda para encontrar la causa del problema.

El modelo entonces inspeccionará el código y el error, identificará posibles causas (por ejemplo, variables no inicializadas, errores de tipo, condiciones incorrectas, etc.) y propondrá una solución o cambio en el código.

Por ejemplo, se le podría preguntar: «¿Por qué este código Java lanza NullPointerException en la línea X?» proporcionando el método en cuestión, y DeepSeek Coder podría responder algo como: “Parece que la lista usuarios no fue inicializada antes de usarse, lo que provoca el NullPointerException.

Deberías instanciar usuarios antes del bucle, o verificar que no sea null”. Incluso puede acompañar la explicación con el fragmento de código corregido.

Este tipo de depuración automática ahorra mucho tiempo, ya que la IA ha visto multitud de patrones de errores comunes durante su entrenamiento en código real y sabe reconocerlos.

Actúa casi como un tutor o revisor de código que señala dónde está el fallo y cómo solucionarlo, acelerando la corrección de bugs.

Explicación y documentación automática de código

DeepSeek Coder no solo genera y corrige código, sino que también entiende el código existente y puede explicarlo en lenguaje natural, facilitando la documentación y la transferencia de conocimiento.

Esta característica es muy útil al trabajar con bases de código heredadas, complejas o simplemente cuando necesitamos comprender rápidamente qué hace un fragmento escrito por otro desarrollador.

Podemos proporcionarle una porción de código y preguntarle algo como: «¿Puedes explicar qué hace esta función?».

El modelo analizará la lógica de la función y generará una explicación detallada en texto plano, describiendo paso a paso el comportamiento del código.

Por ejemplo, si se le da una función que implementa un algoritmo de ordenamiento, DeepSeek Coder podría responder con una descripción de alto nivel («esta función ordena la lista utilizando el algoritmo Quick Sort, eligiendo el primer elemento como pivote, separando la lista en sublistas menores o mayores que el pivote, y luego aplicando recursividad»), posiblemente incluyendo comentarios línea por línea sobre el código.

De esta manera, actúa como un documentador automático o un profesor de programación que traduce código a lenguaje humano.

Esto es particularmente útil para generar documentación técnica (por ejemplo, comentarios o docstrings) de forma rápida.

Un desarrollador puede pedirle a DeepSeek Coder que documente una función y el modelo generará comentarios descriptivos de lo que hace cada parte, ahorrando tiempo en la escritura manual de documentación.

En suma, esta capacidad de explicación de código ayuda tanto en la revisión como en la formación, permitiendo entender código complejo o mal documentado de forma más sencilla.

Traducción de código entre distintos lenguajes de programación

Dada su competencia en multitud de lenguajes, DeepSeek Coder puede usarse como herramienta de traducción de código de un lenguaje a otro.

Si un desarrollador necesita portar un fragmento de código de Python a Java, o de JavaScript a Go (por citar ejemplos), puede solicitar al modelo esa conversión.

Por ejemplo: «Convierte este fragmento de Python en un código equivalente en C++» y proporcionarle el código Python.

Gracias a su conocimiento amplio, la IA entenderá la intención del código fuente y generará la implementación equivalente en el otro lenguaje, teniendo en cuenta las diferencias de sintaxis y las convenciones propias de cada uno.

Incluso se le puede pedir que muestre cómo realizar una misma tarea en dos lenguajes distintos, para fines educativos.

En efecto, DeepSeek Coder permite comparar implementaciones: uno puede preguntar «¿Cómo se implementa una búsqueda binaria en JavaScript versus en C++?» y obtendrá las funciones en ambos lenguajes.

Esta habilidad agiliza enormemente la migración entre plataformas o el aprendizaje de nuevos lenguajes, ya que actúa como un intérprete poliglota de código.

Un caso de uso común sería entender rápidamente un ejemplo disponible en un lenguaje que dominamos menos: podríamos tomar un script en Rust y pedir una traducción aproximada a Python para verificar que comprendemos su funcionamiento.

Cabe destacar que, si bien la traducción automática puede requerir ajustes finos por parte de un humano (especialmente para aprovechar idiomatismos de cada lenguaje), DeepSeek Coder ofrece una base sólida y ahorra el esfuerzo inicial de reescribir todo manualmente.

Integración en entornos de desarrollo y flujos de trabajo

Una ventaja importante de DeepSeek Coder es que, al ser un modelo abierto, puede integrarse de forma flexible en diversos entornos de desarrollo.

Existen varias maneras de utilizarlo en la práctica según las preferencias y necesidades del desarrollador o equipo:

- Interfaz conversacional web: DeepSeek AI ofrece una interfaz tipo chat en la que se puede interactuar con DeepSeek Coder directamente desde el navegador. En este entorno, los desarrolladores pueden escribir preguntas o peticiones (como las de los ejemplos anteriores) y obtener las respuestas o el código generado al instante, de forma similar a como se usaría ChatGPT pero centrado en código. Esta opción es útil para consultas rápidas o para aprovechar el modelo sin necesidad de instalar nada localmente.

- Uso mediante API o biblioteca en local: Para una integración más profunda, DeepSeek Coder está disponible a través de bibliotecas de machine learning populares. Por ejemplo, los modelos (en sus distintos tamaños) se pueden descargar desde Hugging Face Hub e incorporar en scripts Python mediante la librería Transformers de Hugging Face u otras similares. Esto permite integrarlo en editores de código, IDEs o sistemas personalizados. Por ejemplo, es posible cargar el modelo en un entorno local e invocarlo para completar código a medida que escribes en tu editor, replicando la experiencia de un autocompletado inteligente pero sin depender de servicios en la nube. A continuación vemos un ejemplo de uso en Python, utilizando Transformers, donde se carga un modelo DeepSeek Coder de 6.7B parámetros y se le pide generar una función a partir de una instrucción:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

# Cargar el tokenizador y el modelo pre-entrenado desde Hugging Face

modelo_id = "deepseek-ai/deepseek-coder-6.7b-base"

tokenizer = AutoTokenizer.from_pretrained(modelo_id, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(

modelo_id, trust_remote_code=True, torch_dtype=torch.bfloat16

).cuda()

# Instrucción en lenguaje natural para generar código (en inglés para mayor precisión)

entrada = "Write a quick sort algorithm in Python"

inputs = tokenizer(entrada, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_length=128)

codigo_generado = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(codigo_generado)

Al ejecutar el código anterior, el modelo produce una implementación completa del algoritmo Quick Sort en Python de manera autónoma.

Por ejemplo, la salida podría ser la siguiente función generada:

def quick_sort(arr):

if len(arr) <= 1:

return arr

pivot = arr[0]

left = []

right = []

for i in range(1, len(arr)):

if arr[i] < pivot:

left.append(arr[i])

else:

right.append(arr[i])

return quick_sort(left) + [pivot] + quick_sort(right)

Como se observa, DeepSeek Coder interpreta la solicitud dada en lenguaje natural (inglés, en este caso) y produce código Python sintácticamente correcto y funcional para la tarea solicitada (ordenamiento de una lista).

Este tipo de integración vía librerías permite incorporar la IA en pipelines de desarrollo personalizados.

Por ejemplo, podríamos construir una herramienta de línea de comandos que dado un archivo de descripción de tareas genere módulos de código automáticamente, o integrarlo en un sistema de revisión de código que sugiera mejoras.

- Plugins y extensiones: Debido a su naturaleza abierta, la comunidad puede crear extensiones para editores (VS Code, Vim, etc.) que utilicen DeepSeek Coder como motor de sugerencias. Si bien oficialmente la comparación con herramientas de terceros no es nuestro foco, vale mencionar que su uso puede asemejarse al de asistentes como Copilot en cuanto a que puede proveer recomendaciones dentro del editor a medida que se escribe. La diferencia es que, con DeepSeek Coder, uno puede auto hospedarse la inteligencia artificial, evitando costos de suscripción y manteniendo los datos de código en la máquina del desarrollador (importante para código propietario o sensible). No requiere pago por uso ni tiene limitaciones estrictas de cuota, lo que brinda libertad para integrarlo según convenga. Algunos desarrolladores ya han experimentado con su incorporación en flujos de CI/CD, para generar documentación o incluso pruebas unitarias de forma automática a partir del código nuevo, aumentando la productividad del equipo.

En resumen, DeepSeek Coder puede ser aprovechado como una potente IA para desarrolladores en múltiples facetas: desde escribir y completar código, hasta traducir entre lenguajes, depurar errores y generar documentación.

Su arquitectura técnica – con un modelo de lenguaje entrenado masivamente en código – le otorga una comprensión profunda del desarrollo de software, y su condición de plataforma abierta permite adoptarlo e integrarlo libremente en distintas herramientas y entornos.

En un mundo donde la codificación con LLMs está revolucionando la forma de desarrollar, DeepSeek Coder se posiciona como una solución de vanguardia y accesible, pensada para que los programadores “dejen que el código se escriba solo” respaldados por la inteligencia artificial, mientras mantienen el control y la supervisión sobre el resultado final.

Con DeepSeek Coder, la generación automática de código de alta calidad ya es una realidad práctica al alcance de cualquier desarrollador que desee potenciar su productividad.