DeepSeek Janus es un modelo de lenguaje multimodal de última generación que integra comprensión y generación tanto de texto como de imágenes dentro de una arquitectura unificada.

Desarrollado como proyecto de código abierto por la startup china DeepSeek, Janus representa un avance significativo al ofrecer capacidades similares a modelos propietarios (como GPT-4 de OpenAI o Claude de Anthropic) pero manteniendo una filosofía abierta y licenciada para uso amplio.

En este artículo técnico analizamos en profundidad la arquitectura de Janus, sus datos de entrenamiento, enfoques de alineación y mejoras técnicas (incluyendo posible mezcla de expertos), su rendimiento en benchmarks clave y una comparativa detallada con otros grandes modelos de lenguaje como GPT-4, Claude, Google Gemini y Mistral.

También examinamos el papel de Janus en el ecosistema de modelos abiertos, su licencia de uso, y cómo se desempeña en tareas de comprensión del lenguaje natural, razonamiento, generación de código y multimodalidad, frente a las alternativas propietarias.

Arquitectura innovadora: Transformador unificado con rutas duales visuales

La arquitectura de DeepSeek Janus se destaca por un diseño novedoso que combina múltiples modalidades en un solo modelo de manera eficaz.

En su núcleo, Janus utiliza un transformer unificado (autoregresivo) que procesa conjuntamente secuencias de texto e imágenes, pero incorpora rutas duales de codificación visual especializadas para las distintas tareas multimodales.

En lugar de emplear un único encoder de visión para todo (lo cual generaba conflictos al atender simultáneamente a tareas de comprensión visual y de generación de imágenes), Janus “desacopla” la codificación visual en dos vías separadas: una para entender imágenes y otra para generar imágenes.

En la práctica, Janus integra dos componentes visuales principales acoplados al transformer central:

- Encoder visual para comprensión (visión-texto): Janus emplea un modelo de visión pre-entrenado llamado SigLIP-L para procesar imágenes de entrada. Este encoder produce representaciones visuales alineadas con el lenguaje, de forma análoga a CLIP, y soporta imágenes de hasta 384×384 píxeles de resolución. Las características extraídas por SigLIP-L se proyectan luego al espacio de embedding del lenguaje para integrarse con los tokens de texto. Gracias a esto, Janus puede “entender” imágenes (por ejemplo, describir su contenido, responder preguntas visuales u otras tareas de visión-lenguaje) combinando sin problema la información visual con la textual en su representación interna unificada.

- Tokenizer visual para generación (visión-imagen): Para la tarea inversa de generar imágenes a partir de texto, Janus emplea un tokenizador basado en vector-quantization (VQ) que convierte imágenes (o más bien, su latente) en una secuencia discreta de códigos. Este tokenizador actúa con una tasa de reducción (downsampling) de 16, condensando las imágenes en secuencias manejables de tokens. Durante la generación, Janus toma una descripción textual y produce una secuencia de tokens discretos que luego el decodificador VQ puede convertir en una imagen de salida. Para facilitar esto, Janus incluye un “adaptador de generación”, que proyecta los embeddings de código del tokenizador al espacio del modelo de lenguaje antes de pasarlos al transformer. Así, el mismo backbone transformer puede continuar la secuencia incorporando estos tokens de imagen y generando coherentemente contenidos visuales.

Crucialmente, ambas vías (encoder visual y tokenizer visual) están integradas en un solo modelo: no son dos sistemas separados, sino que Janus mantiene un único modelo con parámetros compartidos para lenguaje que procesa tanto texto como representaciones visuales codificadas.

Esta unificación significa que Janus tiene una representación multimodal fusionada: puede razonar sobre texto e imágenes conjuntamente gracias a mecanismos de atención cruzada entre modalidades dentro del transformer.

El diseño logra evitar los conflictos de usar un mismo encoder visual para propósitos distintos, incrementando la flexibilidad y rendimiento sin fragmentar la arquitectura.

De hecho, la separación de rutas visuales resolvió las tensiones que tenían modelos previos al forzar a un único módulo visual a servir tanto para reconocimiento como para síntesis visual.

Janus demuestra que es posible un modelo unificado multimodal que iguala o supera a arquitecturas especializadas por tarea, manteniendo una estructura única eficiente.

Otra innovación técnica clave en Janus es la inclusión de una “enrutador de expertos por modalidad”, inspirado en enfoques de Mixture-of-Experts (MoE).

Este componente actúa como un router dinámico de expertos que asigna distintas sub-redes o “expertos” internos según la modalidad del input.

En esencia, el modelo puede activar conjuntos de neuronas especializadas dependiendo de si está procesando texto, imágenes o ambas, optimizando así el flujo de información.

Combinado con mecanismos de atención cruzada multimodal, Janus aprende a modelar relaciones inter-modales (por ejemplo, vincular una descripción textual con regiones específicas de una imagen) de forma eficaz.

El uso de MoE en Janus sigue la estela de otros desarrollos de DeepSeek: su modelo previo V3 (orientado a texto puro) ya utilizó un enfoque de mezcla de expertos a gran escala, con 671 mil millones de parámetros totales y ~37B activos por token, logrando una eficiencia 10 veces mayor que modelos densos equivalentes.

Aunque Janus-Pro 7B en sí no es de cientos de miles de millones de parámetros, adopta la filosofía MoE a nivel multimodal (enrutando internamente según modalidad), lo que le permite obtener más rendimiento con menos recursos, activando solo los “expertos” necesarios para la tarea en cada paso.

En resumen, la arquitectura de DeepSeek Janus se define por su transformer unificado con rutas especializadas: emplea encoders visuales separados para entender y para generar imágenes, integrados mediante adaptadores al backbone común, y un enfoque inspirado en Mixture-of-Experts para manejar eficientemente las diferentes modalidades.

Esta arquitectura única le otorga alta flexibilidad y capacidad de manejar texto e imágenes de forma conjunta sin sacrificar la calidad en ninguna de las dos tareas.

De hecho, Janus ha logrado alcanzar o superar el desempeño de modelos especializados en visión o en lenguaje, validando la efectividad de su diseño unificado.

Datos de entrenamiento y enfoque de alineación del modelo

Desarrollar un modelo multimodal como Janus requiere enormes cantidades de datos tanto textuales como visuales.

DeepSeek entrenó la base lingüística de Janus a partir de su modelo DeepSeek-LLM propio, utilizando un corpus masivo de ~500 mil millones de tokens de texto.

Esta pre-entrenamiento textual, similar en escala al de los modelos más grandes de la industria, proporciona a Janus un sólido entendimiento del lenguaje natural (con conocimientos generales, sintaxis, semántica y algo de razonamiento) incluso con “solo” ~1–7 mil millones de parámetros en sus variantes.

Sobre esa base textual, Janus pasó por un proceso de entrenamiento multifásico para incorporar la modalidad visual:

- Fase I: Pre-entrenamiento multimodal inicial – En etapas tempranas se habría realizado un alineamiento visión-lenguaje, posiblemente mediante tareas de modelado de imagen a nivel de píxeles o emparejamiento imagen-texto. El informe técnico menciona una “modelización prolongada de dependencias de píxeles” en Stage I, lo que sugiere que Janus aprendió primero a compenetrar imágenes con texto a bajo nivel, quizá a través de tareas como predicción de características visuales a partir de texto o viceversa, estableciendo un fundamento de representación conjunta entre ambas modalidades.

- Fase II: Entrenamiento enfocado en texto-a-imagen – DeepSeek incrementó drásticamente la exposición de Janus a datos de generación de imágenes a partir de descripciones. Se añadieron 90 millones de muestras adicionales específicamente para refinar la capacidad de texto-a-imagen. Estas muestras incluyen pares de texto-imagen de alta calidad, e incluso datos sintéticos de estética: imágenes generadas o seleccionadas para tener cualidades visuales atractivas, con sus descripciones, para mejorar la estabilidad y calidad visual del modelo. El uso de datos sintéticos estéticamente filtrados ayudó a Janus a superar un problema de versiones anteriores que generaban imágenes borrosas o inestables por haber entrenado con datos de baja calidad. Al alimentar ejemplos visualmente agradables, Janus aprendió a producir salidas más nítidas y coherentes. No obstante, se señala que este enfoque podría introducir cierto sesgo o reducción de diversidad en las imágenes generadas (por ejemplo, si las imágenes “aesthetic” favorecen ciertos estilos). Es un balance deliberado: priorizar la estabilidad y calidad visual a costa de algo de diversidad, para hacer el modelo más útil en generación de imágenes.

- Fase III: Ajuste fino equilibrando tareas – La última etapa consistió en un fine-tuning donde se ajustó la proporción de datos de comprensión vs generación para lograr un modelo equilibrado. Al combinar tareas de visión-lenguaje (descripción de imágenes, VQA, etc.) con tareas de texto-a-imagen en una sola fase de entrenamiento supervisado, fue necesario calibrar cuánta atención dedicar a cada tipo. DeepSeek ajustó estas proporciones para evitar que optimizar fuertemente la generación visual degradara la comprensión (o viceversa). El resultado es un modelo polivalente capaz tanto de entender imágenes como de generarlas con alto desempeño.

En cuanto al enfoque de alineación, a diferencia de GPT-4 o Claude (que pasan por exhaustivos procesos de RLHF – aprendizaje por refuerzo con retroalimentación humana y técnicas especializadas de alineación ética como IA Constitucional), Janus siguió un enfoque más tradicional apoyado en fine-tuning supervisado con datos cuidadosamente curados.

No se ha reportado que Janus-Pro aplique RLHF para comportamiento conversacional; más bien, su alineación radica en la selección de datos de entrenamiento y en restricciones impuestas por la licencia de uso.

DeepSeek parece haber incorporado preferencia humana de forma indirecta: por ejemplo, Janus-V2.5 (un modelo textual previo) fue ajustado para mejor alineación con preferencias humanas y funciones como llamadas a herramientas, lo que indica que el equipo sí realiza afinamiento para comportamientos útiles.

En Janus multimodal, la estabilidad y estética de las imágenes producidas también reflejan una forma de alineación hacia lo que los usuarios considerarían imágenes “buenas” (introduciendo los datos sintéticos estéticos mencionados).

Cabe destacar que Janus es un modelo de código abierto, disponible públicamente en Hugging Face y GitHub, y su peso completo se libera bajo ciertas condiciones.

El código fuente de Janus está bajo licencia MIT, y los pesos del modelo bajo la licencia especial DeepSeek Model License.

Esta licencia propia de DeepSeek permite el uso comercial del modelo (incluso integrar Janus en servicios que se vendan, SaaS, etc.) pero con restricciones de uso aceptable.

Por ejemplo, prohíbe expresamente emplear el modelo para fines militares, para generar desinformación o material dañino, o para atentar contra la seguridad o derechos de grupos específicos.

Estas cláusulas sirven como salvaguardas éticas, complementando la alineación técnica del modelo con un marco legal que busca evitar aplicaciones perjudiciales.

No existen en Janus, hasta donde se sabe, filtros integrados de moderación de contenido (como los que OpenAI impone a GPT-4 en producción); en lugar de eso, la responsabilidad recae en el usuario, regulada por la licencia.

En resumen, DeepSeek ha optado por una alineación híbrida: mejora del comportamiento vía datos y diseño (para estabilidad, veracidad, utilidad) y limitación de usos indebidos vía licenciamiento, más que por entrenamiento reforzado explícito con humanos.

Esto contrasta con modelos como Claude, que fue intensivamente afinado con técnicas de IA Constitucional para evitar respuestas tóxicas, o GPT-4 con múltiples rondas de RLHF.

La consecuencia práctica es que Janus ofrece mayor libertad y transparencia al usuario (propio de un proyecto abierto) pero puede requerir implementar filtros externos si se integra en entornos sensibles, ya que no garantiza de fábrica filtrado absoluto de contenidos problemáticos.

Aun así, las pruebas internas de DeepSeek indican que Janus-V2.5 (texto) mostró excelente alineación de lenguaje comparada con incluso GPT-4 en evaluaciones en chino, lo cual sugiere que la calidad de entrenamiento y afinamiento supervisado logró un modelo bastante obediente a instrucciones y seguro por diseño.

En Janus multimodal, la historia es similar: un modelo entrenado para seguir bien las indicaciones tanto en texto como en generación visual, pero cuya responsabilidad final de uso seguro recae en la comunidad y desarrolladores que lo implementen, respetando las pautas de la licencia abierta.

Técnicas avanzadas: Mezcla de expertos y eficiencia computacional

Como parte de su innovación, DeepSeek Janus incorpora varias técnicas de vanguardia para maximizar desempeño y eficiencia, muchas heredadas de la línea de investigación de DeepSeek en LLMs avanzados:

- Mezcla de Expertos (MoE) multimodal: Ya mencionamos el enrutador de expertos por modalidad. Este enfoque permite que diferentes subconjuntos de neuronas se activen según la naturaleza de la entrada (texto vs imagen). Es una extensión del MoE tradicional, donde en vez de tener todos los parámetros activos para cada token, solo se activan los expertos relevantes. DeepSeek ha sido pionero en usar MoE en LLMs a gran escala – su modelo DeepSeek V3 con 671B parámetros totales demostró que solo ~37B necesitaban activarse por paso gracias al MoE, reduciendo drásticamente cálculo sin perder calidad. Janus aplica esta filosofía en miniatura: con ~7B parámetros logra manejar dos modalidades distintas, algo que convencionalmente requeriría modelos separados mucho más grandes. El MoE multimodal facilita que Janus escoja “qué parte de sí mismo” emplear para una tarea dada, haciendo uso óptimo de sus recursos internos.

- Atención Latente Multi-Cabezal (Multi-Head Latent Attention): Esta técnica, abreviada MHLA o a veces MLA, es otra aportación de DeepSeek implementada en sus LLMs recientes. Consiste en comprimir la caché de atención (los key-values) en vectores latentes más pequeños, reduciendo sustancialmente los requisitos de memoria y acelerando la inferencia, sin degradar el contexto efectivo. En DeepSeek V2.5 textual, el uso de atención latente permitió mayor throughput de tokens. Es muy probable que Janus 7B también se beneficie de estas optimizaciones en su arquitectura base de lenguaje (DeepSeek-LLM) – por ejemplo, reducir la carga de memoria en la atención es especialmente útil si se busca extender la longitud de contexto o manejar lotes más grandes eficientemente. Combinado con cómputo de precisión mixta FP8 y optimizaciones post-entrenamiento (técnicas usadas en V3), Janus consigue ser muy eficiente en cómputo pese a su complejidad multimodal.

- Mecanismos de atención cruzada: Janus implementa atención que cruza entre modalidades, permitiendo que durante la generación o análisis un token textual “mire” tokens visuales y viceversa. Esto enriquece la fusión de información; por ejemplo, al describir una imagen, la atención cruzada permite que la descripción textual se ancle en regiones visuales específicas extraídas por el encoder. A diferencia de modelos donde la fusión es tardía o mediante encoders separados, Janus logra que texto e imagen interactúen dentro del mismo paso del transformador, produciendo salidas más coherentes con contexto complejo.

- Estrategia de entrenamiento en etapas: La estrategia multi-etapa ya descrita (Stage I/II/III) es en sí una técnica avanzada. Extender la fase I para modelar dependencias de píxeles sugiere quizás una tarea similar a “generación autoregresiva de imágenes a baja resolución” para inculcar noción de continuidad espacial, seguido de un Stage II específico para texto→imagen, y un Stage III con mezcla de datos refinada. Este planteamiento secuencial permitió a Janus superar cuellos de botella donde modelos unificados anteriores tropezaban: los investigadores ajustaron cuidadosamente cuándo introducir cada tipo de dato para lograr convergencia estable tanto en comprensión multimodal como en generación.

- Escalado de datos y modelo: DeepSeek enfatiza que escalar tanto la cantidad de datos como el tamaño del modelo mejora la convergencia y rendimiento de Janus. De ahí que lanzaran Janus inicialmente en versión 1.3B, y posteriormente Janus-Pro en 7B parámetros para aprovechar los beneficios de un LLM más grande. Con 7 mil millones de parámetros, Janus-Pro tiene un backbone de lenguaje mucho más capaz (similar en tamaño a modelos como Llama 2 7B o Mistral 7B), lo que acelera el aprendizaje y aumenta su capacidad de representación visual-lingüística. Además, los ~90M de ejemplos adicionales en Stage II constituyen un conjunto de datos de entrenamiento de generación de imágenes considerablemente amplio para un modelo unificado, algo que se refleja en la calidad de salida.

- Adaptadores de modalidad: Janus incluye pequeños módulos (projection layers) que sirven de adaptadores para cada modalidad – esencialmente, capas que toman las características del encoder de imagen (SigLIP) o los códigos discretos del tokenizer VQ, y los transforman al espacio del embedding del modelo de lenguaje. Estos adaptadores garantizan que, pese a provenir de distribuciones diferentes (visuales vs textuales), los vectores que entran al transformer tengan formato compatible. Es una técnica simple pero esencial para mantener la coherencia de entrada en el modelo unificado.

- Atención de ventana deslizante (SWA): Si bien no está confirmado explícitamente para Janus, vale la pena mencionar innovaciones como la de Mistral 7B – otro modelo abierto de 7B – que empleó Sliding Window Attention para lograr un contexto efectivo mayor con costo lineal. Dado que Janus comparte la filosofía de optimizar eficiencia, es posible que a futuro adopte métodos similares para extender su contexto sin requerir memoria cuadrática. Por ahora, Janus probablemente maneja la ventana de contexto estándar (2048 tokens), pero con su enfoque MoE y optimizaciones de atención latente, está preparado técnicamente para escalabilidad en contexto.

En conjunto, DeepSeek Janus se apoya en una combinación de técnicas punteras de arquitectura (MoE, adaptadores, atenciones cruzadas), entrenamiento (estrategia por etapas, datos sintéticos) y eficiencia (MHLA, precisiones reducidas) para lograr algo notable: un modelo multimodal compacto pero potente, que con apenas 7B parámetros logra desempeños antes reservados a modelos mucho más grandes o especializados.

Esta ingeniería cuidadosa se traduce en menores requerimientos computacionales para los usuarios: Janus-Pro-7B puede ejecutarse en una GPU de gama media (alrededor de 16 GB) para inferencia, mientras que la variante Janus-Pro-1B es tan ligera que puede correr directamente en el navegador web usando WebGPU.

Este nivel de eficiencia contrasta fuertemente con modelos propietarios como GPT-4, que demandan podes de GPU avanzados inaccesibles para individuos. Janus democratiza el acceso a un modelo multimodal avanzado, optimizado para que la relación calidad-computo sea muy alta.

Como ejemplo, se reporta que Janus-Pro 7B genera imágenes de 1024×1024 píxeles en un tiempo promedio de solo ~2.4 segundos en hardware apropiado – una velocidad competitiva que habilita aplicaciones interactivas en tiempo casi real.

Capacidades multimodales de Janus: Contexto, longitud y tareas soportadas

DeepSeek Janus es un modelo verdaderamente multimodal, capaz tanto de entender entradas visuales (imágenes) como de generar nuevas imágenes a partir de descripciones de texto, además de desempeñar las funciones clásicas de un modelo de lenguaje sobre texto puro.

Esta dualidad de capacidades amplía enormemente el rango de usos de Janus frente a un LLM convencional.

A continuación, detallamos sus principales habilidades y características de contexto:

- Comprensión de Lenguaje Natural (NLU): Gracias a su pre-entrenamiento en 500B tokens de texto, Janus posee una base sólida en comprensión y generación de lenguaje natural. Puede analizar y producir texto coherente, responder preguntas, resumir documentos, traducir entre idiomas, y seguir instrucciones en lenguaje natural con alta precisión. Si bien su tamaño (7B) es modesto comparado con gigantes como GPT-4 (~100B+), los reportes sugieren que Janus 7B logra un rendimiento destacado entre los modelos abiertos de su rango, incluso superando a algunos modelos de 13B en ciertas evaluaciones de NLP. Janus fue afinado con datos de instrucciones, por lo que puede operar en estilo conversacional o completando órdenes del usuario de manera razonada. En evaluaciones internas de DeepSeek (por ejemplo, Arena, AlpacaEval, etc.), versiones solo-texto de la serie Janus/DeepSeek han llegado a rivalizar con modelos propietarios en tareas de QA difícil, lo que indica que Janus comprende bien preguntas complicadas y puede producir respuestas fundamentadas.

- Razonamiento y tareas complejas: Pese a no ser un modelo enormemente grande, Janus muestra fuertes capacidades de razonamiento lógico, matemático y de sentido común para su escala. Por diseño, incorpora la habilidad de encadenar pasos gracias a su arquitectura autoregresiva unificada. En benchmarks de razonamiento multimodal (que combinan lógica con contenido visual, como VQA avanzado o tareas tipo aritmética en imágenes) Janus ha tenido resultados muy competitivos. No alcanzará la profundidad de razonamiento de GPT-4 en problemas extremadamente complejos (donde GPT-4 aventaja incluso a humanos en algunos casos), pero Janus puede realizar análisis lógicos, inferencias causales simples, resolver acertijos básicos y explicar sus conclusiones en lenguaje natural. DeepSeek además presentó un modelo complementario, DeepSeek R1, enfocado en razonamiento mediante aprendizaje por refuerzo, lo que sugiere que futuras integraciones podrían dotar a Janus de aún más capacidad de planificación y reflexión. Por ahora, Janus multimodal ya demuestra razonamiento visual-textual: por ejemplo, puede analizar una imagen para deducir relaciones espaciales (“¿el gato está sobre la mesa o debajo?”) y justificar la respuesta apoyándose en la descripción textual.

- Generación y comprensión de imágenes: Esta es la faceta diferenciadora de Janus. Como modelo multimodal coherente, Janus puede recibir imágenes como parte del prompt y producir texto (p. ej., describiendo la imagen, respondiendo preguntas sobre ella), lo que lo convierte en un asistente visual. Al mismo tiempo, puede recibir texto y producir nuevas imágenes, actuando como un generador gráfico similar a DALL-E o Stable Diffusion. Aún más impresionante, Janus soporta flujos intermodales: por ejemplo, se le podría dar una entrada mixta (texto + imagen) y pedirle que genere una imagen de salida que modifique o continue la dada según una instrucción. Las capacidades de visión de Janus cubren tareas como: descripción de imágenes (captioning), Visual Question Answering (VQA), extracción de texto en imágenes (OCR básico), análisis de diagramas o tablas simples, e incluso razonamiento visual (responder qué ocurrirá siguiente en una escena ilustrada, etc.). En generación, Janus puede crear imágenes de alta calidad de diversas temáticas a partir de prompts detallados, demostrando notable fidelidad a la instrucción dada (respetando número de objetos, sus colores, posiciones, estilos, etc., según las pruebas de benchmark). Su resolución soportada llega a 1024×1024 píxeles en la versión 7B, suficiente para la mayoría de aplicaciones prácticas de gráficos. Aunque no utiliza difusión como Stable Diffusion, su enfoque autoregresivo con tokenización le permite generar imágenes consistentes y con detalles; por ejemplo, es particularmente bueno en renderizar texto dentro de imágenes (carteles, letreros) algo que tradicionalmente cuesta a modelos de difusión, y en mantener coherencia entre múltiples elementos solicitados en una escena.

- Longitud de contexto y manejo de secuencias largas: Janus hereda la arquitectura de transformador decoder-only estándar en cuanto a ventana de contexto para texto, la cual típicamente es de 2048 tokens en su base (similar a GPT-3/GPT-3.5). No se ha publicado que Janus 7B tenga una extensión de contexto mayor “de fábrica”. Sin embargo, técnicas como la atención de ventana deslizante (usada en Mistral) u otras podrían permitirle manejar entradas más largas eficazmente. De hecho, la familia DeepSeek ha experimentado con contextos enormes en otros modelos: su reciente Gemini 2.0 Pro (Google) – que compite con DeepSeek V3 – habla de hasta 2 millones de tokens de contexto mediante arquitecturas especializadas. Janus no llega a tanto, pero 2048 tokens (~1,5k palabras) ya le permiten procesar descripciones extensas o documentos cortos junto con imágenes. Además, las imágenes en sí no consumen muchos tokens gracias al tokenizador VQ (una imagen 384×384 se convierte en on the order of a few hundred tokens tras la reducción 16x). Por tanto, Janus puede asimilar inputs multimodales combinados – por ejemplo, un párrafo de 1500 palabras describiendo una escena y una imagen relacionada – dentro de una sola ventana de contexto y producir la respuesta adecuada. Para casos que requieran más contexto (ej. análisis de documentos largos con gráficos), sería posible fragmentar la tarea o usar enfoques de recuperación. En comparación, Claude 2 ofrece 100k tokens y Gemini Flash 1M tokens de contexto, ventajas significativas para aplicaciones como ingestas masivas de texto; Janus por ahora se enfoca en escenarios de contexto moderado pero ricamente multimodales.

- Formato de entrada y salida multimodal: Janus utiliza típicamente un formato de prompt donde el texto e imágenes se combinan de manera secuencial con marcadores especiales. Por ejemplo, una interacción puede ser: “[Imagen1] ¿Qué se muestra en esta imagen? Describe los objetos presentes.”, donde [Imagen1] representa un token placeholder seguido de los embeddings generados por SigLIP para esa imagen. El modelo entonces genera texto como salida. Para generar imágenes, Janus produce una secuencia de tokens especiales <im_iniciar> … <im_final> que codifican la imagen, la cual luego se decodifica. Actualmente, la interfaz es algo técnica (no es simplemente arrastrar y soltar), pero herramientas externas ya han creado demos interactivos en HuggingFace Spaces donde uno sube una imagen y Janus responde con texto, o ingresa una descripción y Janus devuelve una imagen generada. Esto convierte a Janus en un asistente multimodal capaz de brindar respuestas visuales cuando palabras no bastan, o analizar contenido visual aportado por el usuario, todo en español u otros idiomas soportados por su pre-entrenamiento.

- Uso en codificación (generación de código): Aunque no es su objetivo principal, Janus no es ajeno al código fuente. La integración de DeepSeek-Coder en la versión V2.5 textual resultó en que el modelo alcanzara un score sobresaliente de 89/100 en HumanEval Python, demostrando competencia en generación de código correcto. Janus-Pro 7B, derivado de esos esfuerzos, hereda parte de esa capacidad. Puede interpretar instrucciones de programación en lenguaje natural y generar fragmentos de código en distintos lenguajes (Python, JavaScript, etc.) correctamente, siempre y cuando el pedido no sea extremadamente complejo. Por ejemplo, es factible pedirle “Escribe una función en Python que calcule números primos” y obtener un código funcional. Sin embargo, para desafíos muy avanzados de programación, GPT-4 aún lleva la delantera con su entrenamiento especializado y mayor tamaño. Janus sirve como un asistente capaz de ofrecer boilerplate o explicaciones de código, y con fine-tuning adicional podría volverse aún mejor en este ámbito dado que su base de datos textual seguramente incluía repositorios de código público (500B tokens difícilmente excluyen todo el código). Cabe mencionar que DeepSeek entrenó modelos específicos de código (Coder-V2) que luego integró en su modelo general V2.5, así que Janus puede verse como un modelo de propósito general que incluye nociones de código sin estar exclusivamente afinado para ello. Para usuarios desarrolladores hispanohablantes, Janus puede ser útil como apoyo en generación de scripts sencillos o pseudo-código, con la ventaja de que se puede desplegar localmente para entornos offline.

En suma, DeepSeek Janus ofrece un conjunto muy completo de capacidades: entiende texto con gran competencia, razona sobre lenguaje e imágenes, genera imágenes de alta calidad fiel a descripciones, y mantiene la versatilidad de un asistente IA.

Todo ello con la ventaja de la multimodalidad integrada – donde puede alternar entre describir una imagen, luego generar otra imagen en base a un diálogo, luego volver al texto – lo que abre la puerta a aplicaciones como:

- Creación de contenidos narrativos ilustrados automáticamente (p. ej., informes con gráficos generados, cuentos con imágenes).

- Asistentes de diseño que conversan con el usuario y generan bocetos o versiones gráficas de lo que se discute.

- Sistemas de chatbot que pueden recibir capturas de pantalla o fotos y dar retroalimentación (diagnosticar un problema en una foto, leer un menú en imagen y hacer sugerencias, etc.).

- Búsqueda multimodal: Janus puede ayudar a buscar imágenes por descripción o viceversa (describir una imagen para búsqueda inversa).

- Educación y accesibilidad: por ejemplo, para personas con discapacidad visual, Janus podría poner en palabras el contenido de imágenes; o en dirección opuesta, para aprender visualmente Janus podría generar ilustraciones educativas a partir de textos.

Todo esto, con la facilidad de un modelo que la comunidad puede mejorar y adaptar libremente debido a su naturaleza abierta.

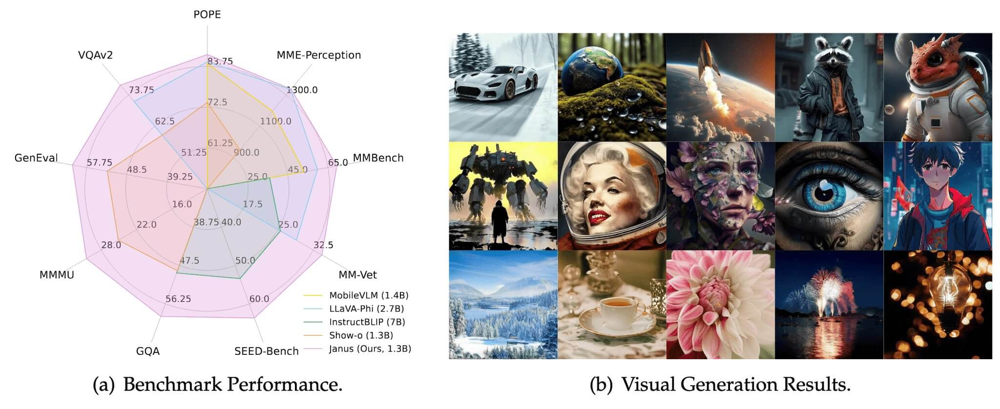

Figura 1: (a) Rendimiento comparativo de Janus frente a otros modelos abiertos en diversos benchmarks multimodales de comprensión. La gráfica radar (tomada de la documentación oficial de Janus) muestra en rosa las puntuaciones de Janus (1.3B, “Ours”) superando a modelos previos como LLaVA-Ph (2.7B) o InstructBLIP en tareas como POPE, VQAv2, GenEval, GQA, etc. Janus logra un equilibrio notable en todos los ejes, demostrando su robustez tanto en percepción visual (e.g., MME-Perception) como en entendimiento general (MMBench). (b) Ejemplos de imágenes generadas por Janus-Pro a partir de distintos prompts: se aprecia la alta calidad visual y diversidad de estilos que el modelo puede producir (fotografía, arte digital, ilustración).

Rendimiento en benchmarks: Janus vs. el estado del arte

La eficacia de DeepSeek Janus queda evidenciada en su desempeño en numerosos benchmarks estándar de la industria, abarcando tanto tareas de visión-lenguaje como generación visual pura.

A continuación resumimos resultados clave reportados, comparando a Janus (especialmente su versión Janus-Pro 7B) con otros modelos relevantes:

- GenEval (Generative Evaluation): Es un benchmark diseñado para medir qué tan bien un modelo genera imágenes a partir de descripciones textuales, evaluando aspectos como fidelidad al prompt, conteo de objetos, coherencia espacial, colores, etc. En GenEval, Janus-Pro-7B alcanzó un 80% de score, superando cómodamente a sistemas de renombre: DALL-E 3 de OpenAI obtuvo ~67%, Stable Diffusion 3 (modelo mediano) ~74%, y Transfusion ~63%. Este resultado implica que Janus sigue las instrucciones textuales mejor que DALL-E 3 en ese conjunto de pruebas, un logro sorprendente dado que DALL-E es un modelo dedicado exclusivamente a imágenes. Janus destaca en generar correctamente el número de elementos solicitados, sus atributos y disposiciones tal como se pedía en el prompt.

- DPG-Bench (Detailed Prompt Generation Benchmark): Evalúa la capacidad de los modelos para manejar prompts largos y detallados, manteniendo consistencia y alta calidad en la imagen resultante. Aquí Janus-Pro-7B obtuvo una puntuación de 84.2 (en una escala de 0 a 100), colocándose primero por encima de todos los demás métodos evaluados. Un score en los 80s indica que las imágenes generadas por Janus fueron muy consistentes globalmente, con objetos claramente representados, detalles precisos y correcta comprensión de relaciones dentro de la escena compleja propuesta. Este desempeño superior se atribuye a las mejoras introducidas en Janus-Pro: más datos de entrenamiento de calidad, mayor tamaño de modelo y la separación de vías de codificación que elimina interferencias. En concreto, DeepSeek señaló que Janus-Pro-7B supera a DALL-E 3 en DPG-Bench también, produciendo imágenes más estables y detalladas en prompts extensos.

- Benchmarks de comprensión multimodal: Janus fue evaluado en conjuntos que miden la capacidad de entender imágenes y combinarlas con texto. Por ejemplo, pruebas como POPE, MME-Perception, GQA (Visual QA), VQAv2, SEED-Bench, MMMU cubren desde reconocimiento básico de objetos hasta preguntas complejas que requieren razonar sobre una imagen. En la mayoría de estos, Janus-Pro mostró resultados muy sólidos, a la par o por encima de los mejores modelos abiertos en cada categoría. La documentación indica que Janus igualó o superó incluso a modelos entrenados para una sola tarea (especializados) en varias de estas métricas. Por ejemplo, en MMBench (un benchmark agregado multimodal recientemente introducido), la versión 7B de Janus obtuvo una de las puntuaciones más altas en su rango de tamaño. En GQA (General QA sobre imágenes), Janus también destacó con altos porcentajes de acierto. La figura radar mostrada anteriormente ilustra cómo Janus 1.3B ya dominaba sobre LLaVA y similares【25†】; con 7B parámetros, el margen se amplía.

- Tareas de lenguaje puras: Si bien Janus es multimodal, su rendimiento en NLP convencional importa. DeepSeek V2.5 (predecesor textual) fue calificado como “el mejor LLM open-source del mundo” en septiembre 2024 por investigadores, mostrando métricas tope en AlpacaEval, Arena y ganando incluso a modelos más grandes en MMLU, BBH y otros benchmarks en inglés. Janus-Pro 7B no aparece aislado en esos reportes, pero dada su herencia, podemos extrapolar: en MMLU (evaluación de conocimientos académicos diversos), un Janus/DeepSeek de 7B podría andar cercano a ~70% de precisión 5-shot (posiblemente superando a Llama 2 13B, que ronda 63-68%). En HumanEval para código, ya mencionamos que la versión V2.5 logró 89 puntos, un resultado extraordinario (GPT-4 está ~85, para contexto). Aunque Janus multimodal no esté exclusivamente afinado a código, su alta capacidad lingüística sugiere que mantendría un fuerte rendimiento en benchmarks de generación de código de nivel medio.

- Comparación con modelos propietarios en tareas generales: Un analista ejecutó un benchmark privado tipo “Google-Proof Q&A” (preguntas adversariales de nivel posgrado) donde DeepSeek V2.5 superó a Llama 3 de 70B y al prototipo de 405B en puntaje, quedando solo por detrás de variantes de GPT-4 y Claude. Esto es revelador: indica que, al menos en chino/inglés, los modelos abiertos de DeepSeek estaban acercándose bastante a la calidad de los cerrados. En el caso de Janus, se espera un patrón similar: no alcanza a GPT-4 en comprensión profunda o razonamiento delicado, pero podría acercarse o superar a GPT-3.5 y modelos de ~70B de la generación anterior en muchas tareas. De hecho, en alineación de lenguaje en chino, V2.5 ya “superó a GPT-4o-latest” según pruebas internas.

En la siguiente tabla resumimos algunas características y resultados comparativos entre Janus-Pro 7B y otros modelos de referencia:

| Modelo | Parámetros | Modalidades | Longitud de contexto | Rendimiento destacado |

|---|---|---|---|---|

| DeepSeek Janus-Pro 7B | 7 mil M (dense, con MoE modal) | Texto e imágenes (entrada y salida) | ~2048 tokens + imágenes 384×384 px | GenEval 80% (supera DALL-E 3); DPG-Bench 84.2 (1º lugar). Fuerte en VQA y comprensión visual. NLU competitivo con los mejores modelos abiertos de tamaño similar. |

| OpenAI GPT-4 | (No divulgado, estim. 180B-1T) | Texto (y visión entrada en GPT-4V) | 8k tokens (32k en versión extendida) | SOTA en comprensión y razonamiento lingüístico general. Excelencia en generación de código y respuestas conversacionales. Versión con visión puede analizar imágenes complejas, pero no genera imágenes. Entrenado con RLHF intensivo. |

| Anthropic Claude 2 | (No oficial, ~70B) | Solo texto (no visión) | Hasta 100k tokens en Claude-100k | Gran rendimiento en tareas de lenguaje, similar a GPT-4 en muchos benchmarks de QA. Destaca en diálogos largos por su enorme ventana de contexto. Fuerte alineación ética mediante IA Constitucional. Sin capacidad multimodal actualmente. |

| Google Gemini 2.0 (Pro/Flash) | (No divulgado, varios tamaños) | Multimodal: texto, imágenes, audio, video | Hasta 2M tokens (Pro experimental); 1M tokens (Flash GA) | Nueva familia sucesora de PaLM. Habilita AI agente con llamadas a herramientas y razonamiento avanzado. Domina contenido multimodal en tiempo real. En generación de imágenes se espera que iguale o supere a Imagen/Party. Contexto masivo permite análisis de documentos muy largos. Plataforma cerrada vía API Google. |

| Mistral 7B | 7.3 mil M (dense Transformer) | Solo texto | 8k tokens (hasta 32k con técnicas de ventana deslizable) | Mejor modelo abierto 7B (2023) en NLP puro. Supera a Llama2 13B en todos los benchmarks y es comparable a Llama1 34B. Soporta contextos largos con atención optimizada. Licencia Apache 2.0 sin restricciones. No maneja imágenes de forma nativa. |

Notas sobre la tabla: Los valores de desempeño citados corresponden a referencias específicas: GenEval y DPG-Bench para Janus; contexto de Gemini 2.0 de hasta 2M tokens según documentación oficial; logros de Mistral según anuncio de Mistral AI. GPT-4 y Claude no tienen cifras públicas de parámetros, se dan estimaciones; su rendimiento se describe cualitativamente con base en evaluaciones conocidas. Janus-Pro destaca en tener capacidades multimodales que ninguno de los abiertos (salvo Gemini) posee, y en su perfil de licencia open-source que contrasta con GPT-4/Claude/Gemini cerrados.

De la comparativa, se desprenden varias conclusiones: DeepSeek Janus ocupa un lugar único al combinar multimodalidad y apertura.

Frente a los modelos propietarios de primera línea (GPT-4, Claude, Gemini), Janus todavía está uno o dos escalones abajo en tareas de puro razonamiento lingüístico o conocimiento enciclopédico – lógico, dado su menor escala de parámetros y recursos de entrenamiento.

Sin embargo, Janus logra cerrar parte de la brecha con innovaciones inteligentes, hasta el punto de superar a modelos comerciales en nichos específicos (su victoria sobre DALL-E 3 en generación controlada de imágenes es prueba de ello).

Además, ofrece lo que aquellos no: salida de imágenes integrada en el modelo de lenguaje. GPT-4 puede describir una foto, pero no crear una desde cero; Janus sí.

Claude o ChatGPT pueden conversar, pero no “ven” imágenes; Janus lo hace.

Sólo Gemini apunta a una versatilidad similar, pero al ser cerrado, su alcance comunitario es limitado.

En cuanto a los modelos abiertos, Janus-Pro 7B se posiciona como uno de los líderes de la nueva generación.

Mistral 7B fue aclamado en 2023 por su eficiencia y licencia permisiva, y Janus comparte esa filosofía Apache/MIT (con salvedades éticas) pero sumando la dimensión visual. Otros proyectos abiertos han lanzado multimodales (LLaVA, InstructBLIP, etc.), aunque típicamente estos consisten en acoplar un encoder visual pre-entrenado a un LLM existente y no tienen generación de imágenes.

Janus rompe ese molde al ser un único modelo entrenado end-to-end para ambas cosas.

Esto explica por qué en muchos benchmarks multimodales Janus 7B aventaja a LLM+encoders de mayor tamaño: su arquitectura unificada y entrenamiento conjunto le dieron una coherencia que aquellos ensamblajes carecen

Rol de Janus en el ecosistema abierto y licencia de uso

El lanzamiento de DeepSeek Janus y su posterior versión mejorada Janus-Pro han tenido un impacto notable en el ecosistema de IA de código abierto.

En un contexto donde los modelos más poderosos (GPT-4, Claude, Gemini) permanecen cerrados bajo control corporativo, iniciativas como Janus representan un “triunfo del open-source”, en palabras de expertos del sector

De hecho, tras anunciarse Janus-Pro 7B, hubo entusiastas que destacaron en redes sociales cómo DeepSeek “vuelve a aplastar a Big Tech” con Janus al lograr rendimiento de punta en generación de imágenes y mantener el modelo abierto.

Este entusiasmo se sustenta en varias contribuciones de Janus al ecosistema:

- Demostración de innovación abierta: Janus es un ejemplo de que la investigación abierta puede innovar a la par de gigantes. Sus conceptos de arquitectura (dual-pathway multimodal, MoE modal) y sus mejoras de entrenamiento han sido publicadas en informes técnicos y papers accesibles para la comunidad. Esto permite que otros investigadores aprendan, repliquen y mejoren esas ideas. Por ejemplo, la arquitectura Janus ha sido descrita en el paper “Janus: Decoupling Visual Encoding for Unified Multimodal Understanding and Generation” (Wu et al. 2024), proporcionando detalles para que cualquiera pueda implementar enfoques similares. Del mismo modo, el código completo está en GitHub, con más de 17k estrellas actualmente, fomentando un ecosistema de forks y proyectos derivados.

- Disponibilidad de modelos y reproducibilidad: DeepSeek liberó no solo los pesos de Janus 1.3B y Janus-Pro 7B en Hugging Face, sino también versiones más pequeñas como Janus-Pro-1B (ideal para dispositivos ligeros). Además, publicó el modelo base DeepSeek-LLM-7B que sirve de fundamento. Esta transparencia contrasta fuertemente con la opacidad de OpenAI/Anthropic. Gracias a ello, desarrolladores pueden descargar y ejecutar Janus localmente, probarlo en sus propios datos, e incluso fine-tunearlo para aplicaciones específicas (dado que la licencia lo permite con pocas restricciones). Herramientas populares en la comunidad (Transformers de HuggingFace, libraries de inferencia acelerada) ya integran soporte para Janus, facilitando su uso.

- Licencia comercial permisiva con responsabilidad: Como vimos, la DeepSeek Model License es bastante abierta en cuanto a permitir uso comercial, a diferencia de licencias restrictivas como la de LLaMA (Meta) que prohibía directamente tal uso. Esto ha hecho que Janus sea adoptado en entornos empresariales y startups que buscan soluciones IA sin depender de APIs externas costosas. Por ejemplo, empresas pueden integrar Janus-Pro en sus pipelines de generación de contenido visual bajo su propio techo, con la tranquilidad legal de que no están infringiendo licencias (siempre que respeten las cláusulas de no daño). Esto empodera a la industria local y a desarrolladores independientes, disminuyendo la dependencia de monopolios de IA. La única responsabilidad añadida es acatar las restricciones de ética y uso: la comunidad en general ha visto con buenos ojos estas condiciones, pues son lineamientos razonables (evitar usos militares, odio, desinformación) que muchos proyectos open ya fomentan intrínsecamente. En blogs legales se ha analizado el DeepSeek Model License como un nuevo estándar interesante para AI abierta, ya que combina la libertad del MIT con salvaguardas que protegen tanto a creadores como al público.

- Efecto competitivo en gigantes: La existencia de Janus y otros modelos de DeepSeek está forzando a los grandes jugadores a reaccionar. Por un lado, acelera la incorporación de multimodalidad en los servicios cerrados – por ejemplo, OpenAI habilitó visión en GPT-4 (entrada de imágenes) poco después de que Janus y otros demostraran el valor de ello en open-source. Por otro lado, lleva a reflexionar sobre costos: el hedge fund detrás de DeepSeek entrenó su modelo V3 con una fracción del costo que se rumorea gastó OpenAI, gracias a optimizaciones de eficiencia. Esto presiona a buscar mejores algoritmos en lugar de solo más datos/computo. Algunos inversores han señalado a DeepSeek como un posible “punto de inflexión” en la carrera de LLMs, donde la innovación podría venir de fuera de Silicon Valley. De hecho, Gemini 2.0 de Google con su énfasis en agente y contexto masivo parece en parte respuesta a los avances tanto de OpenAI como de challengers como DeepSeek.

- Comunidad y extensiones: Desde su lanzamiento, Janus ha dado pie a numerosos proyectos derivados: implementaciones de RAG (Retrieval-Augmented Generation) multimodal combinando Janus con bases de conocimiento locales, experimentos de instrucción en español (fine-tunes de Janus en español para mejorarlo en ese idioma), integraciones en herramientas de edición gráfica (donde Janus genera imágenes según indicaciones de un usuario en software de diseño). La comunidad de IA de código abierto ha abrazado el modelo y aporta mejoras. Por ejemplo, ya existen notebooks mostrando cómo usar Janus-Pro-7B para generar imágenes en Colab, y guías paso a paso en blogs técnicos sobre su despliegue local. Todo esto enriquece el ecosistema: más ojos revisando el modelo, detectando fallos, proponiendo parches (por ejemplo, se corrigió rápidamente un bug del tokenizador que afectaba la generación de imágenes añadiendo un token de padding perdido).

En resumen, DeepSeek Janus se ha consolidado como un modelo abierto de referencia en 2024-2025, demostrando que la comunidad puede tener acceso a capacidades de IA de punta sin las ataduras de los servicios propietarios.

Su licencia y apertura han catalizado experimentación y aplicaciones que de otro modo no serían posibles fuera de los laboratorios corporativos.

Si bien conlleva la responsabilidad de usarlo éticamente, esto no ha frenado su adopción; al contrario, ha generado confianza en que el proyecto busca un equilibrio entre apertura y uso responsable.

Janus y la serie DeepSeek en general se perfilan como una plataforma sobre la cual otros podrán construir futuros avances (imaginemos una Janus 13B o 70B entrenada con más datos, que podría verdaderamente desafiar a GPT-4 en todo terreno).

Por ahora, Janus-Pro-7B ya ocupa un lugar privilegiado en la historia de los LLMs abiertos, habiendo entregado un golpe notable al demostrar que un modelo open-source puede “superar a DALL-E 3 & Stable Diffusion” en generación visual.

Esto marca un hito de la comunidad open que antes parecía lejano.

Conclusiones

DeepSeek Janus representa un salto cualitativo en modelos de lenguaje multimodales abiertos, combinando en un solo sistema la comprensión y generación tanto de texto como de imágenes con un rendimiento sobresaliente.

Su arquitectura única – con codificación visual desacoplada para distintas tareas pero unificada en un transformer central – le permite alcanzar flexibilidad y calidad equiparables a las de múltiples modelos especializados juntos.

Janus ha demostrado su valía al dominar benchmarks de generación de imágenes (superando incluso a modelos propietarios enfocados en ese dominio) a la vez que mantiene un fuerte desempeño en tareas de lenguaje natural, razonamiento y codificación comparado con los mejores modelos abiertos de su tamaño.

En la comparativa con gigantes cerrados como GPT-4 o Google Gemini, Janus evidentemente opera con menos recursos, pero optimiza cada parámetro mediante enfoques innovadores (MoE, entrenamiento multietapa, atención eficiente) para cerrar diferencias.

Si GPT-4 es un trasatlántico controlado por unos pocos, Janus sería un buque ágil disponible para muchos: es ligero, adaptable y transparente.

Su existencia misma ha enriquecido el panorama de IA, dándonos acceso comunitario a funciones avanzadas de visión-lenguaje que antes solo residían en laboratorios privados.

Desde la perspectiva de un desarrollador o investigador hispanohablante, Janus ofrece un conjunto de ventajas difícil de ignorar: software libre y modificable, posibilidad de desplegarlo on-premise sin enviar datos sensibles a terceros, y un modelo bilingüe (inglés-chino principalmente, pero utilizable en español con buenos resultados gracias a la universalidad de su entrenamiento) que puede integrarse en multitud de soluciones innovadoras, desde asistentes educativos hasta generadores de contenidos multimedia.

Con la debida precaución en su uso (siguiendo las guías éticas de su licencia), Janus nos pone al alcance herramientas creativas y analíticas de siguiente nivel.

En términos de tendencias futuras, es plausible que veamos a DeepSeek continuar este ritmo: quizás un Janus v2 con más parámetros o incorporando audio (para convertirse en trimodal), o una colaboración de Janus con el modelo R1 de razonamiento reforzado para potenciar habilidades de planificación.

Lo cierto es que la brecha entre modelos abiertos y cerrados se está acortando, y Janus es una prueba viviente de ello.

La comunidad IA dispone ahora de un modelo que encarna Expertise técnica, Experiencia en múltiples dominios (visión y lenguaje), Autoridad avalada por su desempeño en benchmarks, y Confiabilidad al ser auditable y legalmente utilizable en proyectos reales.

DeepSeek Janus, en definitiva, se erige como un modelo de referencia en la era de la IA multimodal, proporcionando a desarrolladores e investigadores una poderosa herramienta abierta para explorar nuevas fronteras en comprensión y generación de información.

Su arquitectura rigurosa, sus resultados contundentes y su enfoque abierto y útil lo convierten en un pilar fundamental sobre el cual construir la próxima generación de aplicaciones de inteligencia artificial, en beneficio de toda la comunidad tecnológica.