DeepSeek Chat es una plataforma de inteligencia artificial y una familia de modelos de lenguaje de última generación, abierta y de origen chino, que compite cara a cara con los grandes modelos comerciales como GPT-4.

En esencia, DeepSeek proporciona un asistente virtual avanzado (tipo chatbot) capaz de mantener conversaciones naturales, resolver problemas complejos y asistir en tareas de programación, creación de contenido, análisis de datos y más.

A diferencia de otros sistemas propietarios, DeepSeek se destaca por ser gratuito y de código abierto, poniendo capacidades de IA a nivel GPT-4 al alcance de todos sin coste.

Su objetivo es democratizar la IA y ofrecer a desarrolladores, estudiantes, creadores y empresas una herramienta potente para elevar su productividad y creatividad.

Desde su lanzamiento inicial, DeepSeek ha ganado rápidamente popularidad y reconocimiento global.

Fue desarrollado por la empresa DeepSeek (Hangzhou, China) bajo la dirección de Liang Wenfeng en 2023.

DeepSeek saltó a la fama mundial en enero de 2025 con su modelo DeepSeek-R1, que ofrece un desempeño comparable al de GPT-4 pero entrenado con apenas una décima parte del coste.

En cuestión de días tras su lanzamiento, la app móvil de DeepSeek alcanzó el top 1 en descargas de la App Store, superando incluso a la de ChatGPT.

Esto provocó un gran revuelo en la industria, ya que DeepSeek demostraba que una startup open-source podía desafiar a los gigantes de la IA.

En definitiva, DeepSeek AI es un asistente conversacional de alto rendimiento que sirve tanto para propósitos técnicos (codificación, análisis) como creativos (escritura, aprendizaje), brindando sus capacidades en múltiples idiomas (incluyendo español) y de forma accesible para una amplia audiencia.

Historia y evolución del proyecto DeepSeek

La trayectoria de DeepSeek ha sido vertiginosa, con mejoras significativas en cada iteración de su modelo.

A continuación se presenta una línea de tiempo con las principales versiones y hitos del proyecto DeepSeek:

- DeepSeek V0 (Noviembre 2023): Primera versión preliminar del modelo. Basado en la arquitectura Transformer tradicional, se lanzó en dos variantes (7 mil millones y 67 mil millones de parámetros) entrenadas con 2 trillion de tokens bilingües (inglés/chino). Marcó la base inicial como modelo abierto para la comunidad investigadora.

- DeepSeek V1 (Enero 2024): Supuso un cambio de paradigma al introducir una arquitectura Mixture-of-Experts (MoE) en lugar del Transformer puro. Este enfoque de “mezcla de expertos” permite activar solo un subconjunto de parámetros para cada consulta, mejorando la eficiencia. DeepSeek-V1 contó con 16 mil millones de parámetros totales (2.7B activos por token). Fue un avance importante en eficiencia, aunque el proyecto seguía en etapas tempranas.

- DeepSeek V2 (Mayo 2024): Manteniendo la arquitectura MoE, V2 añadió la novedosa técnica Multi-Head Latent Attention (MLA), que le permitió manejar contextos mucho más largos. De hecho, DeepSeek-V2 extendió la ventana de contexto hasta 128 000 tokens empleando un método de extensión de contexto llamado YaRN. Además, escaló su tamaño a 236 mil millones de parámetros totales (21B activos por token). En esta fase también surgieron variantes especializadas: V2-Lite (modelo más pequeño), DeepSeek-Coder V2 (orientado a programación) y una versión combinada DeepSeek V2.5 (introducida en septiembre de 2024).

- DeepSeek V3 (Diciembre 2024): Continuó la tendencia de escalar y refinar el modelo. DeepSeek-V3 mantuvo la impresionante ventana de contexto de 128K tokens y llevó la arquitectura MoE al límite con 671 mil millones de parámetros totales (37B activos por token). Este modelo fue entrenado con 14.8 trillones de tokens de alta calidad, logrando grandes mejoras en velocidad de inferencia gracias a un objetivo de predicción multitoken (decodificación paralela) que acelera la generación de texto. DeepSeek-V3 rápidamente se posicionó entre los modelos open-source más potentes, alcanzando un rendimiento competitivo con modelos cerrados como GPT-4. Su lanzamiento abierto bajo licencia MIT marcó un hito en la comunidad, permitiendo a cualquiera descargar los pesos y colaborar en el proyecto.

- DeepSeek R1 (Enero 2025): Supuso la llegada de la serie “R” (Reasoner), enfocada especialmente en razonamiento avanzado y resolución de problemas complejos. DeepSeek-R1 heredó la arquitectura base de V3 (MoE con 671B parámetros totales) pero potenció sus capacidades mediante aprendizaje por refuerzo a gran escala en tareas de razonamiento. De hecho, una variante preliminar (R1-0 o R1-Zero) fue entrenada exclusivamente con aprendizaje por refuerzo sin datos supervisados, logrando que el modelo desarrollara habilidades de razonamiento de forma autónoma. Cuando DeepSeek-R1 se lanzó al público a finales de enero de 2025, se enfocó en razonamiento matemático, inferencia lógica y generación de código, alcanzando un desempeño equiparable al modelo de razonamiento estrella de OpenAI (conocido como “o1”). R1 consolidó la fama de DeepSeek al demostrar que un modelo open-source podía igualar a GPT-4 en tareas avanzadas. Tras R1, la compañía también introdujo modelos distilled (destilados) en febrero de 2025: versiones reducidas (ej. ~8B parámetros) obtenidas mediante transferencia de conocimiento desde R1, pensadas para uso local y aplicaciones de producción eficientes.

En resumen, la evolución de DeepSeek va desde un modelo base en 2023 hasta un titan de 2025 con capacidades de razonamiento superiores, pasando por innovaciones clave como la arquitectura MoE, la extensión masiva del contexto (128K) y el uso pionero de RL a gran escala.

Cada versión supuso mejoras sustanciales en tamaño, eficiencia y rendimiento, llevando a DeepSeek a posicionarse a la vanguardia de la IA abierta.

Características principales de DeepSeek AI

DeepSeek destaca por una serie de características técnicas y funcionales que lo hacen único en el panorama de modelos de IA.

Sus principales características incluyen:

- Ventana de contexto ultra-amplia (128K tokens): Una de las cualidades estrella de DeepSeek es su enorme ventana de contexto. Esto significa que el modelo puede procesar y “recordar” hasta 128 000 tokens en una sola interacción, equivalentes a decenas de páginas de texto de una vez. En la práctica, DeepSeek puede leer documentos completos (artículos largos, código extenso, contratos, etc.) y mantener todos esos detalles en contexto para responder preguntas o generar resúmenes coherentes. Esta capacidad de 128K supera por mucho el contexto de modelos como GPT-4 (normalmente 8K a 32K tokens) y incluso iguala o supera a otros punteros como Claude de Anthropic (100K). Gracias a técnicas avanzadas (p. ej. atención latente multicabezal y el método YaRN) implementadas desde la versión V2, DeepSeek puede manejar entradas masivas sin perder el hilo, lo que resulta ideal para tareas de análisis de documentos, revisión de código fuente extenso o conversaciones de largo recorrido.

- Soporte de archivos PDF y Word: DeepSeek no solo entiende texto plano, sino que también facilita el trabajo con documentos ofimáticos comunes. A través de integraciones y herramientas, es posible cargar documentos PDF, archivos de Word u otros formatos para que el modelo los analice y procese. Por ejemplo, existen extensiones de navegador y complementos que permiten seleccionar texto en un PDF o DOCX y pedirle a DeepSeek un resumen o explicación en tiempo real. Esto habilita casos de uso como “chatear” con un PDF, donde un estudiante puede subir un paper académico extenso y hacer preguntas al respecto, o un abogado resumir al instante un contrato en Word. DeepSeek extrae el contenido relevante y genera respuestas o resúmenes, ahorrando muchísimo tiempo en lectura y comprensión de documentos largos.

- Gratis y de código abierto: A diferencia de la mayoría de modelos de IA de alto rendimiento, DeepSeek se distribuye bajo una licencia abierta (MIT). Esto significa que sus pesos modelo están disponibles públicamente, permitiendo a cualquiera descargarlos, ejecutarlos en entornos locales o incluso modificar el modelo bajo ciertas condiciones. La filosofía open-source de DeepSeek democratiza el acceso a la IA avanzada. En términos prácticos, usar DeepSeek Chat es gratuito: no requiere suscripción, no hay muros de pago ocultos ni límites estrictos de mensajes. Cualquier persona puede entrar a la plataforma en línea y empezar a conversar con la IA sin coste. Además, al ser abierto, desarrolladores e investigadores pueden inspeccionar cómo está construido el modelo, contribuyendo a mejorarlo continuamente. Esta apertura contrasta con modelos cerrados como GPT-4 o Gemini, cuyos detalles internos y pesos no están disponibles públicamente.

- Optimizado para español y multilingüe: DeepSeek ha sido entrenado con una enorme diversidad de datos multilingües (14.8 trillones de tokens de distintos idiomas), lo que le permite entender y generar texto en español con gran fluidez, así como en inglés, chino, francés y otros idiomas. A diferencia de algunos modelos que pueden mostrar sesgos hacia el inglés, DeepSeek pone especial énfasis en ofrecer un rendimiento excelente en español, siendo uno de los pocos chatbots avanzados optimizado para el público hispanohablante. De hecho, DeepSeek puede desenvolverse sin problemas en conversaciones en español coloquial, responder preguntas de cultura general latinoamericana o española, e incluso ayudarte con redacciones en español neutro. La capacidad multilingüe lo hace útil para traducción, para practicar idiomas o para usuarios que no dominan el inglés. Por ejemplo, en pruebas, DeepSeek fue capaz de seguir el hilo en mezclas de chino e inglés con 90%+ de exactitud en tareas de comprensión, lo que demuestra su sólido núcleo multilingüe. Para la audiencia hispana, esto se traduce en un asistente que “piensa” en español y entiende matices locales, algo que muchas veces ChatGPT u otros no logran con igual acierto.

- Velocidad de respuesta y eficiencia mejorada: A pesar de su gran tamaño, DeepSeek ofrece respuestas muy rápidas y eficientes gracias a varias optimizaciones en su arquitectura. Emplea un esquema de decodificación paralela mediante Multi-Token Prediction, que le permite generar varios tokens por paso de inferencia cuando es posible. Esto se traduce en menor tiempo de espera para el usuario, sin sacrificar demasiada precisión. Además, su diseño MoE hace que solo se activen ~37B parámetros de los 671B totales para cada token, reduciendo el cómputo innecesario. DeepSeek también soporta streaming de respuestas (envía la respuesta parcial por fragmentos mientras la va generando), dando la sensación de inmediatez al usuario. Por otro lado, en términos de costo computacional, DeepSeek ha logrado hazañas notables: entrenar su modelo más potente costó cerca de $5.6 millones, frente a los ~$100 millones estimados que costó GPT-4. Y a nivel de uso, su API es dramáticamente más económica que la de sus competidores: por ejemplo, generar 1 millón de tokens de salida con DeepSeek cuesta unos $2,19 USD, frente a ~$60 USD con GPT-4. Esta eficiencia de costes se refleja en que cualquiera puede usarlo intensivamente sin arruinarse, y en entornos empresariales supone un gran ahorro en infraestructura. En resumen, DeepSeek está diseñado para responder rápido, con bajo coste, y manejando eficientemente tanto el tiempo como los recursos de cómputo.

Comparación: DeepSeek vs GPT-4 vs Gemini vs Claude

Como modelo de IA de última generación, DeepSeek suele compararse con otros sistemas punteros como OpenAI GPT-4, Google Gemini o Anthropic Claude.

A continuación, presentamos una tabla comparativa detallada que destaca las diferencias clave entre DeepSeek-R1 y estos modelos en varios aspectos relevantes:

| Característica | DeepSeek R1 (2025) | OpenAI GPT-4 | Google Gemini | Anthropic Claude |

|---|---|---|---|---|

| Código abierto | Sí – modelo open-source (MIT) | No – cerrado (propietario) | No – cerrado (Google AI) | No – cerrado (Anthropic) |

| Tamaño del modelo | 671B parámetros totales (37B activos por token, MoE) | No divulgado (estimado +1T dense) | No divulgado (multimodal, rumores ~>1T) | ~52B (Claude 2) a 100B+ (Claude 3)* |

| Ventana de contexto | 128 K tokens | 8K estándar (32K en versión ampliada) | 1 M token (Gemini 2.5 Pro) en 2025 | 100 K (Claude 2), hasta 200 K en Claude 3.7 |

| Idiomas | Multilingüe (entrenado en inglés, chino, español, etc.; alto rendimiento en ES) | Multilingüe (excelente en inglés; buen desempeño en otros, pero variable) | Multilingüe (Google dispone de enormes corpus; puntos fuertes en muchos idiomas) | Multilingüe (inglés sobresaliente; otros idiomas aceptables, enfocado en inglés) |

| Capacidades destacadas | Razonamiento lógico, matemático y programación nivel top; respuestas largas coherentes (128K contexto); modelo continuamente afinado por comunidad. | Conocimiento enciclopédico; fuerte en creatividad y conversación natural; posee modo multimodal (imágenes) en versión avanzada. | Multimodal (texto e imágenes integrados); métodos de pensamiento deliberado; recursos masivos de Google (actualizado con últimas tendencias). | Explicaciones detalladas con pensamiento “en voz alta” (Claude 3.7 Sonnet); énfasis en alineación y seguridad; contexto ampliado con memoria a largo plazo. |

| Disponibilidad | Chat web gratuito (sin registro); API pública económica (desde ~$0.002 por 1K tokens; ejecutable localmente. | ChatGPT (interfaz web, versión gratis limitada o de pago Plus); API de pago por uso ($$$ por cada token). | Integrado en productos Google (servicios Cloud, buscador experimental, etc.); no hay interfaz pública gratuita general a 2025. | Disponible vía API cerrada (modelo Claude 2/Instant con costo por token); tiene demos limitadas gratuitas (p. ej. en Slack) y planes empresariales. |

| Ventajas de DeepSeek | Abierto y extensible: cualquiera puede inspeccionarlo o mejorarlo; Costo ínfimo: uso ilimitado sin pagar; Contexto masivo: maneja documentos largos enteros; Comunidad: mejoras continuas abiertas. | Ventaja GPT-4: mayor conocimiento pre-entrenado en ciertos dominios privados; ecosistema robusto de OpenAI; plugins e integraciones oficiales amplias. | Ventaja Gemini: integración con ecosistema Google (Workspace, Android); enfoque multimodal nativo; actualización más frecuente con información reciente de la web. | Ventaja Claude: muy centrado en evitar sesgos y toxicidad; explicaciones transparentes; ideal para usos internos donde la trazabilidad del razonamiento es clave. |

Nota: (Los detalles de parámetros de GPT-4, Gemini y Claude provienen de estimaciones o versiones públicas disponibles hasta 2025, ya que sus creadores no revelan plenamente esta información.)

En la tabla se aprecia cómo DeepSeek R1 ofrece características sobresalientes frente a sus competidores.

Por ejemplo, su ventana de contexto (128K) es una de las mayores del sector abierto, solo superada por versiones experimentales de GPT-4.1/Gemini con 1 millón de tokens.

También destaca su naturaleza abierta y su costo virtualmente nulo para los usuarios, en contraste con los elevados precios de las APIs de GPT-4 o Claude.

Si bien GPT-4 y Gemini siguen liderando en algunos aspectos (como multimodalidad o ciertos benchmarks privados), DeepSeek ha demostrado que puede igualarlos en rendimiento en muchas tareas.

De hecho, en evaluaciones de razonamiento matemático complejo (MATH-500), DeepSeek-R1 alcanzó un 97.3% de precisión, superando a GPT-4 y Claude 3.5 en ese test específico.

En resumen, DeepSeek se presenta como una alternativa abierta y potente frente a los gigantes cerrados, con sus propias fortalezas (contexto, costo, comunidad) que lo hacen muy atractivo según el caso de uso.

Arquitectura técnica y principios de DeepSeek

Bajo el capó, DeepSeek incorpora innovaciones arquitectónicas avanzadas para lograr su eficiencia y rendimiento.

Sus principios técnicos clave incluyen:

- Mixture-of-Experts (Mezcla de Expertos): La arquitectura central de DeepSeek es de tipo MoE, lo que significa que el modelo está compuesto por múltiples sub-modelos expertos que se activan de forma condicionada. En lugar de utilizar todos los parámetros para cada input, el modelo solo activa un subconjunto de parámetros (“expertos”) relevante para cada token. Por ejemplo, de sus 671 mil millones de pesos totales, únicamente ~37B se ponen en juego para procesar un token dado. Esto permite escalar el tamaño total del modelo sin que la inferencia sea prohibitiva, ya que se evitan cálculos innecesarios. El resultado es un modelo enormemente capaz, pero eficiente en uso de cómputo. Este enfoque MoE fue validado desde DeepSeek-V1 y V2, y optimizado en V3 con estrategias de balanceo de carga sin pérdidas auxiliares. En la práctica, MoE dota a DeepSeek de una “mente colectiva” de especialistas que colaboran en las tareas: ciertos expertos pueden estar especializados en lenguaje matemático, otros en código, otros en narrativa, etc., activándose según la necesidad. Esto mejora tanto la precisión (cada parte resuelve lo que mejor sabe) como la eficiencia computacional (no siempre se usan todos los expertos).

- Multi-Head Latent Attention (Atención Latente Multicabezal): Introducida en DeepSeek-V2, MLA es una técnica que extiende la capacidad de atención del modelo manteniendo tractable el coste de computación. Simplificando, MLA permite que el modelo maneje contextos ultra largos (hasta 128K tokens) dividiéndolos en “cabezas latentes” que procesan distintas partes o representaciones del contexto en paralelo, sincronizándose después. Esto fue esencial para que DeepSeek lograra su ventana de 128K sin quedarse sin memoria o sin tiempo de cálculo. En combinación con optimizaciones en el entrenamiento (como el algoritmo YaRN para ampliar ventanas de contexto eficientemente), DeepSeek puede “recordar” información que apareció decenas de miles de palabras atrás. MLA garantiza que incluso con entradas extensas, el modelo siga prestando atención a detalles relevantes a lo largo de toda la conversación o documento, en lugar de olvidar contexto antiguo. En términos simples, es como si DeepSeek tuviera una memoria de trabajo excepcional, gracias a esta atención latente distribuida.

- Predicción multitoken y decodificación paralela: DeepSeek-V3 introdujo un objetivo de entrenamiento de Multi-Token Prediction (MTP). ¿Qué significa esto? Que el modelo fue entrenado para en cada paso predecir no solo el siguiente token, sino potencialmente varios tokens futuros a la vez. Esto habilita técnicas de decodificación especulativa, donde durante la generación de texto el modelo puede dar saltos de varios tokens en una sola iteración (aunque luego verifique y ajuste si es necesario). En la práctica, esta capacidad se manifiesta como una mayor velocidad al generar respuestas. La decodificación “paralela” permite a DeepSeek ser muy rápido en responder, con tests que mostraron velocidades de hasta ~20 tokens/segundo en hardware de gama alta. Si bien esta predicción múltiple puede sacrificar algo de precisión en favor de velocidad, DeepSeek equilibra bien ambas para que el usuario obtenga respuestas completas en menos tiempo. Este principio es parte de la razón por la cual DeepSeek puede afirmar ser más eficiente y rápido que muchos otros LLMs de tamaño similar.

- Aprendizaje por Refuerzo en Cadena (Chain-of-Thought RL): Una de las mayores diferenciaciones de DeepSeek-R1 fue su entrenamiento mediante Reinforcement Learning enfocado en razonamiento. En lugar de depender únicamente de afinado supervisado con datos estáticos, el equipo de DeepSeek diseñó un sistema de recompensas regladas para incentivar que el modelo desarrollara pasos lógicos intermedios. En concreto, implementaron un esquema de recompensa basado en reglas que premia soluciones correctas (p. ej. en matemáticas) y penaliza incoherencias, superando a los típicos modelos de recompensa neuronales. Gracias a este enfoque, un modelo como DeepSeek-R1-Zero logró aprender a razonar sin ejemplos humanos – por pura optimización de la recompensa –, descubriendo patrones complejos de solución de problemas. Este paradigma de entrenamiento por refuerzo dotó a DeepSeek de sorprendentes capacidades emergentes, como mostrar su “cadena de pensamiento” al resolver un cálculo o re-evaluar un enfoque si ve que va mal encaminado. En resumen, DeepSeek aprendió a pensar paso a paso para ciertas tareas difíciles, en lugar de solo dar respuestas finales. Esto es análogo a tener un proceso interno de lógica, que reduce errores de razonamiento y mejora la transparencia de las respuestas. La apuesta por RL a gran escala marcó una diferencia respecto a OpenAI (que en 2024 seguía usando principalmente fine-tuning supervisado tradicional), demostrando DeepSeek nuevas maneras de alcanzar inteligencia artificial sólida.

- Compatibilidad con API de OpenAI y ecosistema abierto: Desde el punto de vista de diseño de plataforma, DeepSeek ha sido construido pensando en la interoperabilidad para desarrolladores. Su servicio en la nube expone una API prácticamente idéntica a la de OpenA, lo que significa que quienes ya usan APIs como las de ChatGPT pueden cambiar a DeepSeek con un mínimo esfuerzo. En concreto, DeepSeek acepta las mismas estructuras de petición (formato

/v1/chat/completionscon mensajes de usuario/sistema), y solo se requiere cambiar la URL base y la clave de API para empezar a usarlo. También implementa características modernas como Function Calling (llamadas de función) y formato JSON estructurado en respuestas. La funcionalidad de Function Calling permite que el modelo invoque herramientas externas o APIs definidas por el desarrollador cuando lo considere necesario, por ejemplo para realizar cálculos, buscar información o manipular fechas. Esto extiende profundamente las capacidades de DeepSeek más allá del texto, integrándolo en flujos de trabajo software más complejos. Adicionalmente, la API soporta streaming de respuestas (entrega token a token) simplemente activando un parámetrostream=true, facilitando la creación de interfaces reactivas. Todos estos principios – abrir el modelo, pero también facilitar su integración comercial mediante una API familiar – reflejan la filosofía de DeepSeek de ser accesible, adaptable y listo para usar en multitud de entornos con el menor friction posible.

En conjunto, la arquitectura de DeepSeek combina escala masiva (gracias a MoE), ingeniería inteligente (MLA, MTP) y técnicas de entrenamiento innovadoras (RL de razonamiento) para alcanzar un modelo que rivaliza con los mejores del mundo manteniendo un espíritu abierto.

Su compatibilidad con estándares de la industria y su enfoque en eficiencia lo convierten en una opción técnicamente muy atractiva tanto para académicos como para desarrolladores prácticos.

Casos de uso prácticos de DeepSeek

DeepSeek es una herramienta versátil que se adapta a numerosas aplicaciones en distintos campos.

A continuación exploramos cómo puede aprovecharse DeepSeek en situaciones reales, agrupadas por tipo de usuario o sector.

Ya seas estudiante, desarrollador, creador de contenido o analista de datos en una empresa, DeepSeek ofrece funcionalidades relevantes para ti.

Para estudiantes y educación

DeepSeek se ha convertido en un asistente de estudio AI muy popular entre estudiantes de secundaria y universitarios por su capacidad de explicar conceptos complejos de forma sencilla.

Imagina tener un tutor virtual disponible 24/7: con DeepSeek, un estudiante puede preguntarle desde “¿Qué fue la Guerra de los Cien Años?” hasta “¿Cómo funciona la fotosíntesis?” y obtener respuestas claras, estructuradas y fáciles de entender.

El modelo puede desglosar temas difíciles de ciencias, matemáticas o historia en términos más simples, proporcionando analogías y contexto como lo haría un buen profesor humano. Esta habilidad de simplificar lo complejo ayuda a los alumnos a comprender materias áridas y aclarar dudas puntuales al instante.

De hecho, algunas instituciones educativas ya recomiendan el uso de IA para reforzar el aprendizaje; por ejemplo, se ha documentado que DeepSeek puede guiar paso a paso en la resolución de problemas matemáticos o explicar teoremas complicados, actuando como un “resuelve-problemas” interactivo.

Otra área donde DeepSeek destaca es en ayudar con tareas y deberes. Los estudiantes pueden pedirle que revise la gramática de un ensayo, que proponga ideas para un proyecto, o incluso que resuma un capítulo de un libro de texto. Gracias a su enorme contexto, DeepSeek puede leer capítulos enteros y extraer los puntos clave en cuestión de segundos.

Por ejemplo, un alumno puede copiar un artículo o apuntes extensos en la conversación y pedir un resumen o mapa conceptual, obteniendo una sinopsis ordenada.

También puede formular preguntas de comprensión sobre un texto dado, a modo de práctica de estudio.

Adicionalmente, en asignaturas cuantitativas, DeepSeek puede servir como tutor de matemáticas: si un estudiante está atascado en un problema de cálculo integral, la IA puede guiarlo sugiriendo primero qué método de integración usar, luego mostrando cada paso del cálculo, explicando las reglas aplicadas en cada transformación.

Esto es valiosísimo para aprender el proceso y no solo ver la solución final. En resumen, para los estudiantes, DeepSeek es un compañero de estudio que responde preguntas, clarifica conceptos difíciles, resuelve ejercicios complejos paso a paso y fomenta una comprensión más profunda, todo sin coste y de forma privada.

No es de extrañar que, tras lanzarse el modelo R1 en 2025, la app gratuita de DeepSeek alcanzara el #1 en descargas, superando incluso a ChatGPT, señal de la enorme adopción entre jóvenes y educadores.

Para desarrolladores y programadores

DeepSeek es una herramienta poderosa para desarrolladores de software, actuando como un asistente de programación incansable.

Una de sus utilidades principales es la ayuda en código y depuración: los programadores pueden pegar fragmentos de código y pedir a DeepSeek que encuentre errores o bugs, que sugiera optimizaciones, o que explique qué hace cierto bloque de código.

Por ejemplo, si proporcionas una función con un bug sutil, DeepSeek puede analizarla y señalar “aquí estás restando en lugar de sumar, deberías usar a + b en vez de a - b”.

También puede reformatear código para que siga buenas prácticas o estilos comunes, y ofrecer refactorizaciones (reescrituras más limpias).

Su capacidad de comprender múltiples lenguajes de programación es muy alta; ha sido entrenado con abundante código de Python, JavaScript, C++, Java, etc., por lo que entiende la sintaxis y las bibliotecas comunes.

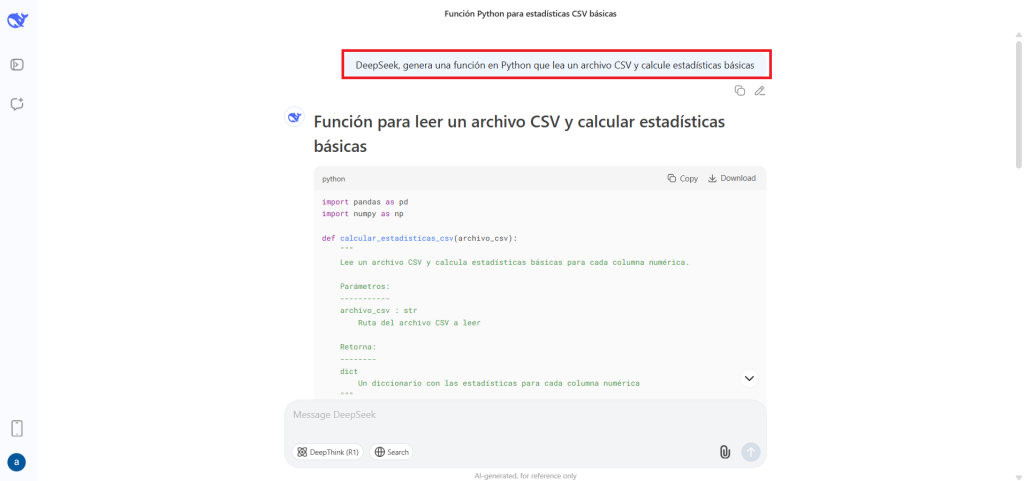

Otra aplicación clave es la generación de código. DeepSeek puede actuar como un pair programmer que sugiere implementaciones enteras a partir de descripciones en lenguaje natural.

Por ejemplo, un desarrollador puede pedir “DeepSeek, genera una función en Python que lea un archivo CSV y calcule estadísticas básicas” y obtendrá código funcional de inmediato.

En pruebas comparativas, se ha visto que DeepSeek R1 alcanza un nivel muy alto en tareas de generación de código competitivo, situándose en percentiles top en evaluaciones de programación.

Además, no tiene límite de contexto, por lo que puede analizar un repositorio completo o múltiples archivos a la vez: con sus 128K tokens, es posible alimentarle miles de líneas de un proyecto y preguntarle por dependencias, posibles puntos débiles, o incluso solicitarle que añada una nueva función teniendo en cuenta todo el código existente.

Este análisis de codebase completo es algo donde sobresale incluso frente a modelos famosos, ya que muchos están limitados por ventanas de contexto más pequeñas.

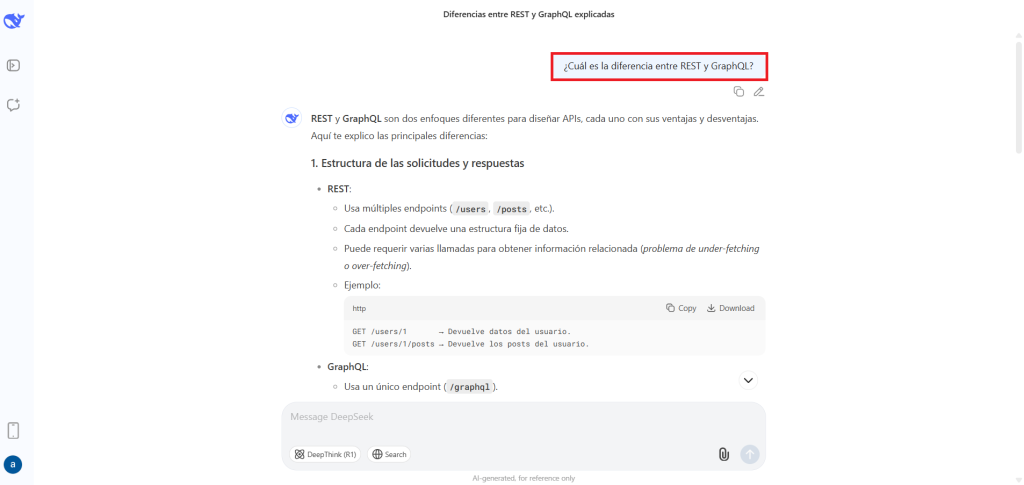

DeepSeek también es capaz de explicar conceptos técnicos y APIs. Un desarrollador que se enfrenta a una nueva librería o framework puede preguntarle a la IA cómo usar cierta función, o cuál es la diferencia entre dos enfoques, y obtener una explicación inmediata sin tener que buscar en documentación extensa.

Por ejemplo: “¿Cuál es la diferencia entre REST y GraphQL?” – DeepSeek responderá con una comparación clara de ambos estilos de API.

Esto agiliza la curva de aprendizaje de nuevas tecnologías. Incluso puede ayudar con escritura de documentación: si le proporcionas una porción de código, puede generar comentarios o documentación en Markdown explicando su funcionalidad.

En entornos de desarrollo, DeepSeek se integra mediante plugins y extensiones: existe un complemento para VS Code y editores similares que permite consultas a DeepSeek sin salir del IDE.

Imagina hacer clic derecho sobre una línea de código y seleccionar “Explicar este código” o “Encontrar error con DeepSeek” – la IA te devuelve la respuesta al instante junto al código.

Todo esto sin costo, a diferencia de otras soluciones de IA para código que requieren suscripciones.

Por último, cabe destacar que DeepSeek ofrece perfiles especializados como “AI Code Assistant” o “AI Software Developer” en su plataforma, que afinan sus respuestas para contexto de programación, lo cual resulta útil para obtener recomendaciones más precisas de arquitectura, patrones de diseño, etc.

En definitiva, para un desarrollador, DeepSeek es como un compañero programador virtual que revisa tu código, sugiere mejoras, genera funciones a demanda y te ayuda a aprender nuevas herramientas, acelerando significativamente el ciclo de desarrollo.

Para creadores de contenido y marketing

Blogueros, escritores, marketers y creadores en general encuentran en DeepSeek un aliado creativo y productivo. Una de las áreas donde brilla es en la generación de textos e ideas.

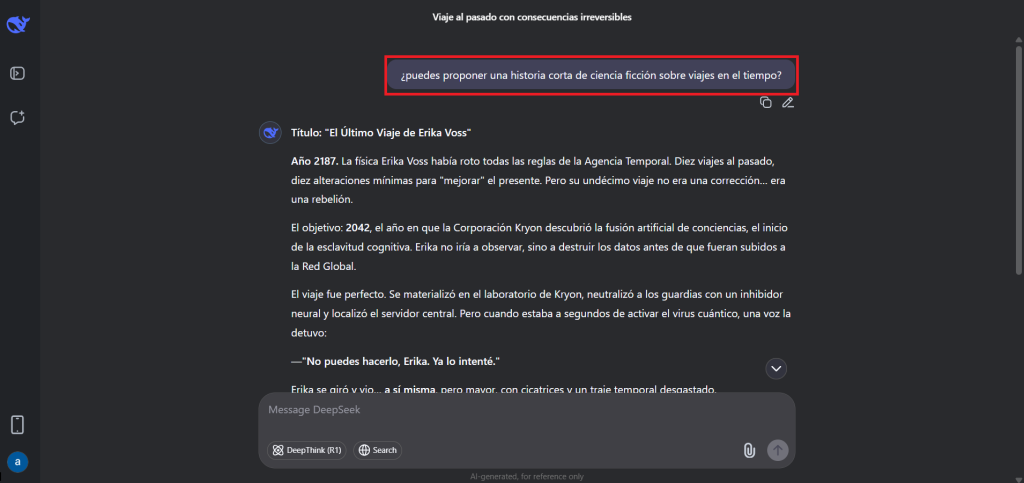

Si estás bloqueado buscando cómo comenzar un artículo o necesitas ideas frescas, puedes pedirle a DeepSeek cosas como “dame 5 titulares llamativos para un post sobre energías renovables” o “¿puedes proponer una historia corta de ciencia ficción sobre viajes en el tiempo?”.

La IA generará rápidamente propuestas creativas y borradores que sirven de base para tu contenido. Gracias a su entrenamiento masivo, tiene conocimientos en una amplia gama de temas y puede adoptar distintos tonos: formal, académico, coloquial, humorístico, etc., según se le indique.

Por ejemplo, para un copywriter, DeepSeek puede sugerir eslóganes publicitarios, textos para anuncios, o variaciones de un párrafo para probar distintos enfoques de marketing.

En el proceso de redacción y edición, DeepSeek ahorra tiempo al pulir textos.

Puedes darle un párrafo o un capítulo que hayas escrito y pedirle que lo mejore: la IA corregirá gramática, clarificará oraciones confusas, ajustará el tono y puede hasta reescribir frases para que suenen más naturales y atractivas. Esto es como tener un editor personal que repasa tu trabajo al instante.

También puede expandir contenidos: si tienes solo un esquema, dile a DeepSeek “desarrolla cada punto con uno o dos párrafos” y obtendrás un primer borrador extenso en segundos.

Muchos creadores usan esta técnica para producir rápidamente un primer borrador y luego ajustarlo manualmente a su gusto.

Otra capacidad valiosa es la síntesis y resumen. Para creadores que investigan temas, DeepSeek puede leer varias fuentes (incluso documentos PDF o páginas web completas) y extraer los puntos clave, generando resúmenes estructurados.

Por ejemplo, puedes copiar el texto de un informe largo o artículo científico y pedir un resumen en bullet points: DeepSeek entregará los hechos más relevantes en forma concisa.

Esto acelera la investigación al permitir digerir mucho contenido en poco tiempo.

Igualmente útil es su habilidad para traducir o adaptar contenido a diferentes formatos.

Un YouTuber o podcaster puede tomar su guion en español y pedir a DeepSeek que lo traduzca al inglés (u otro idioma) manteniendo el estilo.

O un community manager puede convertir un párrafo de blog en una serie de tweets atractivos.

Además, DeepSeek puede encargarse de tareas repetitivas de contenido, como generar descripciones de productos en masa, crear fichas de meta-descripción SEO para páginas web, o incluso producir subtítulos/resúmenes para videos.

Todo esto gratis, sin límites de cantidad, a diferencia de servicios de redacción AI que suelen cobrar por palabra.

Por último, la creatividad de DeepSeek abarca incluso guiones, poemas y piezas literarias: se le puede solicitar un poema sobre determinado tema o un diálogo ficticio entre personajes, y la IA compone texto original.

Si bien la calidad creativa puede requerir ajustes humanos, es un excelente punto de partida e inspiración.

En suma, para un creador de contenido, DeepSeek ofrece lluvia de ideas infinita, redacción asistida y revisión editorial en un solo paquete, permitiendo enfocarse más en la estrategia y el toque humano final, mientras la IA acelera el trabajo pesado de escribir.

Para empresas y analistas de datos

En el ámbito empresarial y de análisis de datos, DeepSeek actúa como un asistente inteligente que puede digerir información corporativa y facilitar la toma de decisiones. Un caso de uso potente es el análisis y resumen de informes: las empresas lidian con reportes extensos (financieros, de mercado, técnicos) y DeepSeek puede resumirlos en segundos. Por ejemplo, un analista puede proporcionarle a la IA un informe de 50 páginas en PDF sobre tendencias de mercado, y pedir “extrae los 5 hallazgos más importantes y las recomendaciones clave”. DeepSeek procesará todo el texto y entregará un compendio puntual de conclusiones. Esto acelera las reuniones ejecutivas, donde en lugar de leer todo el informe, los decision-makers pueden partir del resumen generado y luego profundizar en secciones específicas si es necesario. De igual modo, con reportes financieros trimestrales, DeepSeek puede señalar aumentos o caídas relevantes, métricas destacadas, etc., ahorrando horas de trabajo.

Otra aplicación es en análisis de datos y hojas de cálculo. Con integraciones apropiadas, DeepSeek puede conectarse a tus datos empresariales (por ejemplo, hay plugins que le permiten leer un rango seleccionado de celdas en Excel o Google Sheets) y entonces puedes hacerle preguntas en lenguaje natural sobre esos datos.

Imagina seleccionar una tabla de ventas por producto y preguntar: “¿Qué tendencias destacas en estas cifras trimestrales?” – DeepSeek puede detectar y responder cosas como “las ventas de la categoría X muestran un crecimiento sostenido del 15% QoQ, mientras que el producto Y tuvo una caída en el Q2 posiblemente por estacionalidad”.

También puede generar fórmulas complejas de Excel si se las describes, o depurar fórmulas existentes que dan error.

Esto convierte una hoja de cálculo en una especie de dashboard interactivo, donde en lugar de escribir fórmulas a mano, simplemente consultas a la IA.

Dado el bajo coste de DeepSeek, incluso análisis extensos (por ejemplo, recorrer miles de filas) tienen un coste insignificante – se menciona que redactar todo un informe de análisis con DeepSeek podría costar ~$0.002 en tokens, prácticamente cero.

DeepSeek también puede usarse para atención al cliente automatizada o business intelligence.

Por ejemplo, entrenando instancias del modelo en bases de conocimiento específicas, una empresa puede montar un chatbot que responda preguntas frecuentes de clientes con la precisión de DeepSeek.

O un analista de negocio puede preguntarle a DeepSeek cosas como “¿qué estrategia de marketing recomendarías para este producto dado estos resultados?” y obtener ideas bien estructuradas, ya que el modelo ha visto multitud de casos de uso y tendencias de mercado en sus datos.

Incluso se ha utilizado en escenarios de consultoría interna, donde gerentes piden a la IA borradores de planes de negocio, análisis DAFO, o listados de posibles mejoras operativas, como punto de partida para su trabajo.

Un factor importante para empresas es la privacidad: DeepSeek Chat (versión web independiente) no guarda el historial de conversaciones en sus servidores, brindando tranquilidad para discusiones sensibles.

Además, al ser open-source, algunas compañías optan por desplegar DeepSeek en sus propios entornos seguros (en la nube privada o on-premise), garantizando que los datos no salgan de su control. Herramientas como Docker u opciones como Ollama permiten cargar modelos como DeepSeek-R1 8B en servidores locales para uso interno.

En resumen, en el mundo empresarial DeepSeek ayuda a transformar datos en insights accionables de forma rápida: resume documentos, analiza hojas de cálculo, responde consultas de negocio y apoya la automatización, todo ello potenciando la eficiencia y la toma de decisiones basada en datos.

Herramientas y funciones avanzadas de DeepSeek

Además de su interfaz de chat amigable, DeepSeek ofrece herramientas para usuarios avanzados y desarrolladores que extienden sus capacidades:

- API pública compatible con OpenAI: DeepSeek pone a disposición una API REST para integrar el modelo en aplicaciones y sistemas propios. Esta API utiliza el mismo formato que la API de OpenAI (misma ruta y estructura JSON), lo que significa que es muy fácil migrar un desarrollo existente de ChatGPT hacia DeepSeek. Solo se necesita cambiar el endpoint base a

api.deepseek.comy usar una clave de API de DeepSeek, manteniendo el resto de la lógica prácticamente igual. La API soporta los métodos de completado de chat (/chat/completions), permitiendo enviar conversaciones con roles (“user”, “assistant”, “system”) y obtener respuestas del modelo. Al ser OpenAI-compatible, se pueden usar directamente las librerías oficiales de OpenAI (SDK en Python, Node, etc.) configurando elbase_urlal de DeepSeek. Esto reduce la fricción para desarrolladores. Además, la API de DeepSeek es mucho más económica que la de OpenAI – ideal para proyectos con presupuesto ajustado o para startups que quieran ofrecer IA a gran escala sin arruinarse. DeepSeek ofrece distintos modelos vía API (p.ej.deepseek-chatapunta al modelo V3,deepseek-reasoneral R1 actualizado), de modo que puedes elegir entre respuestas más creativas o más orientadas a razonamiento según convenga. En definitiva, la API hace a DeepSeek accesible desde cualquier aplicación, permitiendo crear bots personalizados, asistentes en sitios web, análisis automatizados, etc., con una simple llamada web. - Function Calling y respuesta estructurada: Siguiendo los últimos avances en IA, DeepSeek soporta la invocación de funciones durante las conversaciones. Esta característica (function calling) permite definir a la IA una serie de funciones (por ejemplo: buscar en una base de datos, obtener la fecha actual, realizar cálculos) que el modelo puede decidir llamar si la pregunta del usuario lo amerita. DeepSeek analizará la consulta y, si lo ve útil, en lugar de dar una respuesta en texto plano, retornará un objeto JSON indicando qué función llamar y con qué parámetros. El desarrollador luego ejecuta esa función real (fuera de la IA) – por ej., consultar un API del clima – y devuelve el resultado a la IA, que entonces entrega la respuesta final al usuario usando esos datos actualizados. Esto conecta a DeepSeek con el mundo exterior y datos en tiempo real, superando la limitación de modelos entrenados con datos estáticos. Por ejemplo, se puede preguntar “¿Cuántos eventos en mi calendario para mañana?” y la IA usaría function calling para pedir a una función

getCalendarEvents(fecha)esa información y luego contestar con los datos reales. Asimismo, DeepSeek puede generar directamente salidas en formato JSON estructurado cuando se le solicita, útil para integrarlo con sistemas que requieran respuestas parseables (por ej., devolver una lista de pasos como array JSON). Cabe mencionar que inicialmente R1 no soportaba nativamente funciones, pero en versiones recientes (R1-0528 y V3-0324) se añadió esta capacidad. Esto pone a DeepSeek a la par de GPT-4 en cuanto a integrabilidad con herramientas y agentes de software externos. - Streaming de respuestas en tiempo real: Para aplicaciones interactivas, la API de DeepSeek permite activar el modo stream. Con

stream=trueen la solicitud, el servidor irá enviando los tokens de la respuesta a medida que se generan. Esto es importante para proporcionar una mejor experiencia de usuario, ya que en lugar de esperar a que la respuesta completa esté lista, la aplicación puede ir mostrando el texto progresivamente (tal como hace ChatGPT en su interfaz). Desde el punto de vista del desarrollador, DeepSeek hace streaming usando respuestas en formato chunked HTTP (similar al de OpenAI), donde cada fragmento lleva una parte del mensaje. Implementar esta funcionalidad es sencillo con las bibliotecas existentes de OpenAI (que ya manejan streams) apuntando a DeepSeek. En resumen, el streaming permite que las respuestas largas no se sientan lentas, algo crucial cuando DeepSeek puede generar cientos de palabras o más. - Uso offline / local (Hugging Face y Docker): Gracias a su naturaleza open-source, es posible ejecutar DeepSeek en entornos locales o privados, sin depender de la nube pública. La organización deepseek-ai publica los pesos de modelos como DeepSeek-V3 y R1 en Hugging Face, de modo que se pueden descargar (teniendo en cuenta que son modelos muy pesados). Desarrolladores con acceso a GPUs potentes pueden cargar el modelo en memoria y usar frameworks como PyTorch o TensorFlow para realizar inferencia local. De hecho, se ha logrado ejecutar DeepSeek-R1 completo con una configuración de 4 tarjetas NVIDIA A100 (80GB) en paralelo, lo cual soporta el contexto completo de 128K tokens. Para quienes no disponen de tal hardware, la buena noticia es que existen versiones distiladas y reducidas: por ejemplo, DeepSeek-R1-8B (8 mil millones de parámetros) que ha sido preparada para correr en GPUs de gama media o incluso en CPU mediante cuantización, sacrificando algo de precisión pero manteniendo buena parte de las capacidades de lenguaje. También hay proyectos comunitarios que empaquetan DeepSeek en contenedores Docker u ofrecen instaladores fáciles. Por ejemplo, usando la herramienta Ollama es posible descargar modelos como DeepSeek 8B y ejecutarlos localmente con un solo comando. Esto permite tener un chatbot privado en tu PC o servidor, asegurando que los datos sensibles nunca salen de tu entorno. Asimismo, empresas con requisitos de privacidad pueden desplegar DeepSeek en su infraestructura interna (clústers con GPUs o TPUs) usando Docker y Kubernetes, aprovechando que el código fuente está disponible. En definitiva, DeepSeek ofrece flexibilidad total de implementación: ya sea mediante su servicio en la nube listo para usar, o auto-hospedado para máximo control. Para muchos entusiastas, poder “trastear” con el modelo en local – ajustar hiperparámetros, aplicar fine-tuning personalizado con sus propios datos, etc. – es un valor añadido enorme que modelos cerrados no permiten.

Con todas estas herramientas y funciones avanzadas, DeepSeek se posiciona no solo como un chatbot en una web, sino como una plataforma de IA completa que puede integrarse en flujos de trabajo, aplicaciones y servicios a la medida de las necesidades de cada usuario o proyecto.

Guía: Cómo empezar a usar DeepSeek Chat (paso a paso)

Comenzar a utilizar DeepSeek es muy sencillo. No se necesita instalar nada ni registrarse obligatoriamente para probarlo.

Sigue estos pasos para tener tu primera conversación con DeepSeek Chat:

- Accede a la plataforma web: Visita el sitio oficial de DeepSeek Chat en tu navegador. Existe una versión en español en la URL

deepseek-espanol.chat(o puedes usar la versión global en ingléshttps://www.deepseek.com/). Verás una interfaz de chat simple, similar a ChatGPT, con un cuadro donde escribir tus preguntas. No hace falta crear cuenta ni iniciar sesión – desde el primer momento puedes empezar a escribir. - Elige el modelo (opcional): DeepSeek Chat suele ofrecer más de un modelo para elegir, típicamente DeepSeek R1 y DeepSeek V3. La interfaz te permite seleccionar el modelo más apropiado según tu tarea:

- DeepSeek R1 – orientado a conversación general y creatividad. Úsalo para charlas cotidianas, preguntas de cultura general, escritura creativa, etc.DeepSeek V3 – enfocado en asistencia técnica y soluciones complejas. Ideal para programación, matemáticas avanzadas o discusiones muy detalladas.

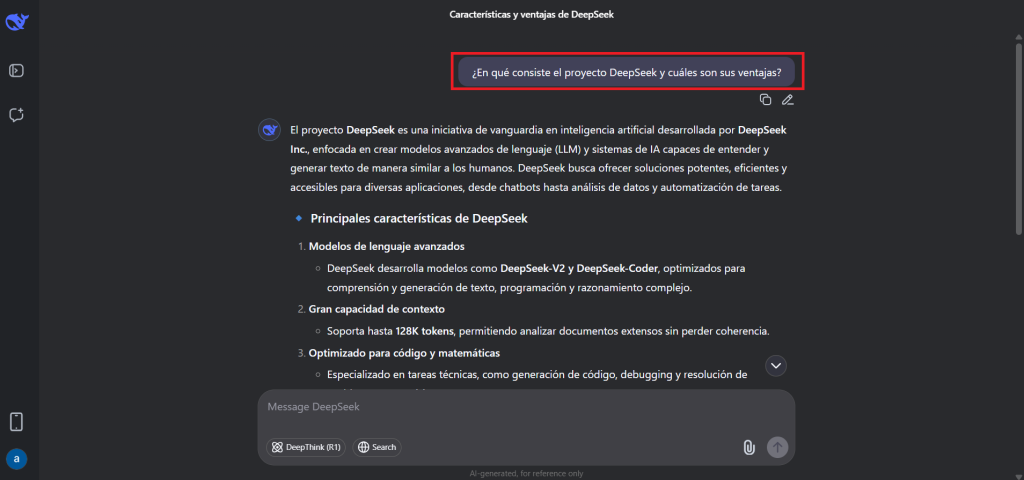

- Escribe tu primera pregunta o solicitud: En el cuadro de texto, redacta una consulta. Puede ser en español u otro idioma – DeepSeek entenderá perfectamente. Por ejemplo, podrías preguntar: «¿En qué consiste el proyecto DeepSeek y cuáles son sus ventajas?». Luego pulsa Enter (o el botón de enviar). No hace falta estructurar demasiado la pregunta; DeepSeek es capaz de interpretar lenguaje natural e incluso contextos conversacionales. Si tu pregunta se apoya en algo mencionado antes en la charla, el modelo lo recordará (hasta el límite de 128K tokens).

- Espera la respuesta del AI: DeepSeek procesará tu pregunta y en pocos segundos verás aparecer la respuesta en el área de chat. Gracias al streaming, la respuesta irá escribiéndose palabra por palabra de forma dinámica. Usualmente, las respuestas de DeepSeek son bastante completas, a veces extensas según lo que se pregunte. Por ejemplo, a la pregunta anterior te entregará varios párrafos explicando qué es DeepSeek, su historia, comparaciones, etc. Si la respuesta es demasiado corta o no abordó lo que querías, ¡no te preocupes! Puedes afinar en el siguiente paso.

- Haz preguntas de seguimiento o pide aclaraciones: Una de las potencias de DeepSeek es que mantiene el contexto de la conversación. Esto significa que puedes hacer una pregunta seguida de otra relacionada, sin repetir toda la información. Siguiendo el ejemplo, podrías repreguntar: «¿Y en qué se diferencia de ChatGPT?» – la IA entiende que “se” se refiere a DeepSeek, porque recuerda la charla. Así, puedes profundizar o cambiar ligeramente el enfoque según necesites, obteniendo una interacción fluida y coherente. Si la respuesta anterior no fue suficiente, pide más detalles: «¿Puedes darme más detalles técnicos?» y DeepSeek ampliará gustosamente.

- Explora funcionalidades adicionales en la interfaz: La plataforma de DeepSeek Chat suele incluir algunas herramientas útiles, como la opción de subir archivos o enlaces para que el modelo los analice (según la instancia de la página que uses). También podría ofrecer “modos” o asistentes predefinidos (por ejemplo un modo Programador, un modo Tutor, etc.) – en la versión en español es posible que veas apartados de “Asistentes AI” específicos. Si deseas aprovechar la capacidad de leer PDFs, busca si hay un botón de “Cargar PDF” o similar (en deep-seek.chat hay integraciones para chatear con PDF bajo Solutions > Chatear con PDF). En caso de disponer de ello, simplemente adjunta el archivo y formula tu pregunta sobre su contenido, p. ej.: «Resúmeme los puntos clave de este documento.».

- Revisa las políticas y ajusta tus peticiones si es necesario: DeepSeek, al igual que otros modelos, tiene ciertas directrices de contenido (evita respuestas ofensivas, spam, etc.). Si alguna vez tu pregunta infringe las reglas, la IA te lo indicará. En general, mientras tus consultas sean lícitas y respetuosas, DeepSeek responderá a casi cualquier cosa: desde resolver un bug de código, hasta traducir un texto, pasando por componer una poesía. Aprovecha su versatilidad.

¡Y eso es todo! Con estos pasos ya estarás interactuando con DeepSeek. La experiencia es muy similar a chatear con un experto en múltiples áreas.

Recuerda que puedes reiniciar la conversación o borrar el historial en cualquier momento para empezar de cero con un nuevo tema.

DeepSeek está siempre aprendiendo del feedback (no directamente de tus conversaciones privadas, sino a través de mejoras continuas del modelo por la comunidad), por lo que cada vez lo encontrarás más afinado.

Ahora que sabes usarlo, podrás emplearlo como herramienta de apoyo en tus estudios, trabajo o proyectos personales.

Guía: Cómo integrar la API de DeepSeek en tu aplicación

Para desarrolladores que quieran incorporar las capacidades de DeepSeek en sus propias aplicaciones, la plataforma ofrece una API compatible con OpenAI que facilita enormemente la integración.

A continuación se describe un proceso paso a paso para comenzar a usar la API de DeepSeek:

- Obtener una clave de API de DeepSeek: Debes registrarte en la plataforma de desarrolladores de DeepSeek para obtener tus credenciales. Ve a platform.deepseek.com y crea una cuenta (puede que necesites un email y contraseña). Una vez dentro, en el dashboard encontrarás la sección de API Keys donde puedes generar una nueva clave secreta. Esta clave (un string largo) es lo que usarás para autenticar tus llamadas API. Nota: En el momento de escribir, la plataforma y documentos están en inglés, pero el proceso es estándar. Apunta tu API key en lugar seguro.

- Configurar el endpoint compatible con OpenAI: Como mencionamos, la API de DeepSeek imita el formato de OpenAI. La URL base para llamadas es

https://api.deepseek.com(ohttps://api.deepseek.com/v1para mayor compatibilidad). También necesitarás usar tu API key en el encabezado de autorización. Por ejemplo, en llamadas HTTP debes enviarAuthorization: Bearer TU_API_KEY. Los endpoints disponibles incluyen:POST /chat/completions– para obtener respuestas estilo chat (con contexto de conversación).POST /completions– para completar texto (formato estilo GPT-3).Otros endpoints análogos a OpenAI (p. ej. para listar modelos, etc.).

/chat/completions. Los parámetros en el cuerpo JSON siguen la especificación de OpenAI: debes incluir el modelo a usar (model: por ej."deepseek-chat"para V3-Chat, o"deepseek-reasoner"para R1), la lista de mensajes con sus roles, y opciones comomax_tokens,temperature,stream, etc. Esto hace que puedas reutilizar librerías oficiales. Por ejemplo, con la libreríaopenaide Python, simplemente especificandoopenai.api_basecomo DeepSeek y la API key de DeepSeek, ¡podrías llamar aopenai.ChatCompletion.create()igual que con ChatGPT!. - Realizar una llamada de prueba (ejemplo en Python): Para ilustrar, aquí mostramos un ejemplo simplificado en Python usando la librería de OpenAI, que sirve igualmente para DeepSeek:

import openai

# Configurar credenciales para DeepSeek

openai.api_base = "https://api.deepseek.com/v1"

openai.api_key = "TU_API_KEY" # Reemplaza con la clave obtenida

# Llamar al modelo DeepSeek-chat con un mensaje simple

respuesta = openai.ChatCompletion.create(

model="deepseek-chat",

messages=[{"role": "user", "content": "Hola, ¿qué es DeepSeek?"}],

max_tokens=200,

temperature=0.7

)

print(respuesta.choices[0].message.content)En este snippet, hemos enviado una pregunta en español y deberíamos recibir como salida el contenido de la respuesta generada por DeepSeek (que probablemente será una explicación en español sobre DeepSeek AI).

Nota: Puedes usar también curl u otros lenguajes; por ejemplo con curl sería:

curl https://api.deepseek.com/chat/completions \

-H "Authorization: Bearer TU_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-chat",

"messages": [{"role": "user", "content": "Hola, ¿qué es DeepSeek?"}]

}'- La estructura de la respuesta JSON será muy similar a la de OpenAI, incluyendo campos como

choices(con el mensaje generado),usage(conteo de tokens usados), etc. - Implementar streaming y otras opciones: Si tu aplicación requiere mostrar la respuesta progresivamente, asegúrate de enviar

"stream": trueen el JSON de la solicitud. La API te irá entregando fragmentos de la respuesta en tiempo real. Muchas librerías ya manejan esto de forma automática (por ejemplo, en Python podrías iterar sobreopenai.ChatCompletion.create(..., stream=True)como un generador). Además, puedes aprovechar opciones comofunction_callsi has definido funciones para que el modelo las use. La documentación de DeepSeek detalla cómo enviar definiciones de función en la llamada (siguiendo el esquema de OpenAI) y cómo el modelo puede responder indicando una llamada a función. Esto es más avanzado, pero muy útil si integras la IA con herramientas externas. - Gestionar límites y costos: Actualmente, DeepSeek ofrece generosas cuotas gratuitas para desarrolladores (su filosofía es “acceso a la IA para todos”). No obstante, para volúmenes muy altos de uso puede haber ciertos límites por minuto o por día, o planes de pago con mayor rendimiento. Consulta el panel de tu cuenta para ver las limitaciones vigentes (por ejemplo, X solicitudes por minuto). Si planeas un despliegue a gran escala, considera contactar con el equipo de DeepSeek o revisar si hay un plan premium. Aun así, los costos son extremadamente bajos comparados con otros proveedores.

- Integración y pruebas: Incorpora las llamadas API en tu aplicación (web, móvil, backend, etc.) según tu lenguaje preferido. Prueba varios escenarios – por ejemplo, preguntas cortas, contextos largos encadenados, etc. – para asegurarte de que manejas bien las respuestas. Ten en cuenta que, al igual que otros modelos de lenguaje, DeepSeek puede ocasionalmente producir alguna salida inesperada o “alucinar” si se le solicita algo ambiguo. Por ello, implementa siempre validación de las respuestas del modelo si son críticas (p. ej., si el modelo devuelve datos que tu app usará, verifica formatos, longitudes, etc.).

Siguiendo estos pasos, habrás integrado con éxito la IA de DeepSeek en tu software.

En resumen: solicita tu API key, utiliza los mismos métodos que con OpenAI pero apuntando al endpoint de DeepSeek, y disfruta de una potencia de IA similar a GPT-4 a una fracción del costo.

La documentación oficial de DeepSeek API (disponible en su web) ofrece ejemplos en otros lenguajes y casos de uso específicos, por lo que es buena idea consultarla para profundizar.

¡Ahora tu aplicación puede aprovechar la inteligencia de DeepSeek para brindar funcionalidades avanzadas a tus usuarios!

Preguntas frecuentes (FAQ)

Finalmente, recopilamos algunas preguntas frecuentes sobre DeepSeek y sus respuestas breves para aclarar posibles dudas comunes:

¿DeepSeek es gratuito? ¿Cuál es el truco?

Sí, DeepSeek es totalmente gratuito para uso personal sin límites estrictos. No hay truco oculto. Su financiamiento proviene de inversiones externas y comunidad open-source. Para usos empresariales masivos podrían existir planes especiales, pero para el usuario promedio es gratis sin restricciones importantes.

¿Cómo se compara DeepSeek con GPT-4 de OpenAI?

DeepSeek logra rendimiento similar a GPT-4, especialmente en tareas técnicas como matemáticas y programación. Ventajas clave:

Ventana de contexto mayor (128K tokens vs 32K de GPT-4).

Gratuito y abierto (GPT-4 es cerrado y de pago).

Menos costes de operación.

GPT-4 tiene ligera ventaja en creatividad lingüística y calidad conversacional natural. Muchos usuarios combinan ambos según necesidad.

¿Dónde y cómo se puede ejecutar DeepSeek localmente?

Puedes descargar y ejecutar DeepSeek localmente gracias a su licencia MIT abierta :

Modelos grandes (671B parámetros) requieren hardware potente (múltiples GPUs de gama alta).

Modelos reducidos (como DeepSeek-R1-Distill 8B) corren en GPUs individuales o CPUs.

Disponible en plataformas como Hugging Face, Docker, Ollama, con guías detalladas.

¿DeepSeek tiene algún límite de uso o restricciones?

No existen límites estrictos en el uso gratuito diario o mensual para usuarios comunes. Se aplican solo políticas básicas de uso justo para evitar abusos automáticos masivos (como scripts). También sigue guías éticas similares a otros modelos, rechazando contenidos peligrosos o ilegales.