DeepSeek es un sistema de inteligencia artificial basado en modelos de lenguaje a gran escala (LLM) enfocado originalmente en ayudar en el desarrollo de software, el procesamiento de lenguaje natural y la automatización empresarial. A diferencia de soluciones propietarias, DeepSeek destaca por su naturaleza de código abierto, lo que permite que cualquier persona pueda inspeccionar su funcionamiento e incluso ejecutarlo localmente en su propio equipo.

Nota: Esta plataforma en la que estás probando DeepSeek es independiente y no oficial, es decir, no está afiliada a la empresa creadora de DeepSeek. El propósito de este artículo es ofrecer una visión general práctica sobre cómo integrar DeepSeek en el flujo de trabajo de un desarrollador y con distintas herramientas comunes, manteniendo un tono neutral y educativo (no es asesoramiento profesional).

¿Cómo puede DeepSeek encajar en el flujo de trabajo de un desarrollador?

En el día a día de un programador, DeepSeek puede servir como un asistente versátil en varias etapas del desarrollo. Algunas formas en que puede encajar en el flujo de trabajo son:

Exploración de ideas: Como asistente de IA, DeepSeek puede ayudar a brainstorming técnico. Por ejemplo, un desarrollador puede preguntarle por diferentes enfoques para implementar una funcionalidad o pedirle sugerencias para resolver un problema algorítmico. Esta exploración guiada de ideas resulta útil en fases tempranas de diseño sin asegurar necesariamente que la primera solución propuesta sea óptima.

Explicación de código: DeepSeek es capaz de analizar fragmentos de código y proporcionar explicaciones o resúmenes de lo que hacen. Esto puede ser valioso para entender código legado o educativo. Simplemente seleccionando un bloque de código y pidiendo una explicación, el modelo ofrece un desglose detallado de su funcionamiento. De forma similar, se le puede solicitar que comente secciones complejas o que traduzca código ofuscado a un pseudocódigo entendible.

Prototipado rápido: Gracias a sus capacidades de generación de texto y código, DeepSeek puede asistir en la creación de prototipos sencillos. Un desarrollador puede emplearlo para generar fragmentos de código de ejemplo, plantillas de funciones o incluso pequeñas pruebas de concepto a partir de descripciones en lenguaje natural. Esto agiliza la fase de prototipado, ya que el modelo puede esbozar código que luego el humano refinará. (Es importante mencionar que no debemos hacer afirmaciones absolutas sobre la velocidad o precisión de DeepSeek en comparación con otras herramientas; su utilidad radica en complementar la creatividad y el trabajo del desarrollador, no en prometer una superioridad técnica.)

Tipos de herramientas donde DeepSeek puede utilizarse

DeepSeek se integra bien con diversos entornos y herramientas de desarrollo. A continuación, se describen los tipos de herramientas más comunes donde su uso resulta relevante:

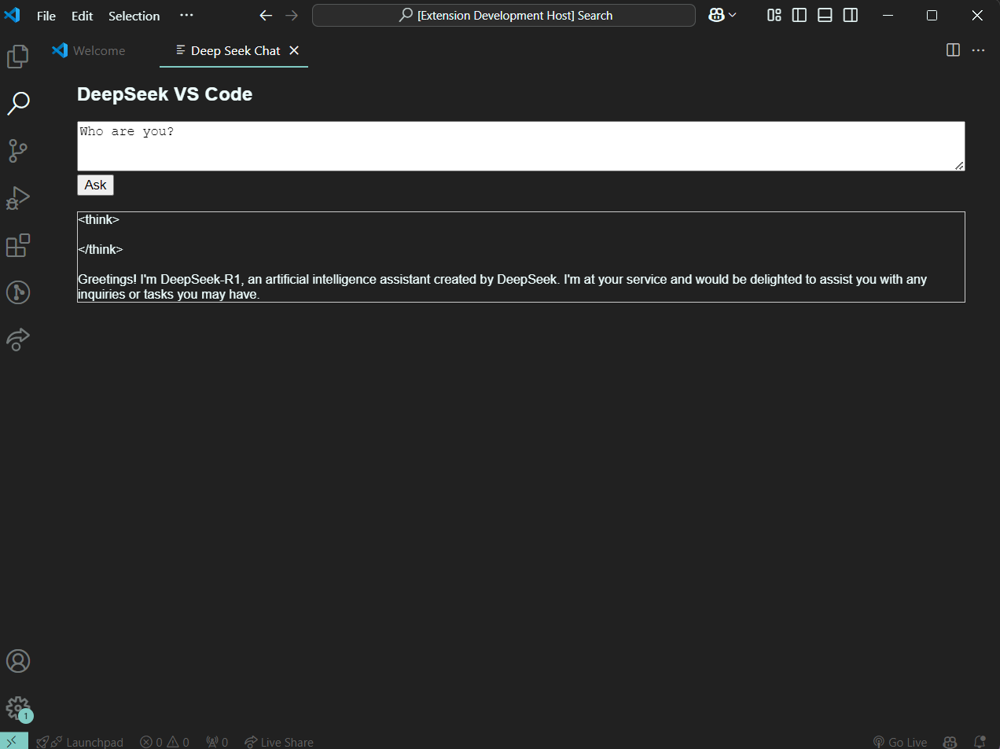

IDEs y editores de código (p. ej., Visual Studio Code): Una de las integraciones más populares es en el editor de código. Existen extensiones para VS Code que permiten interactuar con DeepSeek directamente desde la interfaz del editor, ofreciendo sugerencias de código en tiempo real e incluso un panel de chat integrado. Por ejemplo, se puede descargar un modelo de DeepSeek local y, mediante una extensión, obtener autocompletado de código o respuestas contextuales mientras se programa, todo ello sin depender de la nube. En la imagen, se aprecia un ejemplo de la extensión de DeepSeek funcionando dentro de VS Code como un chat lateral de asistencia.

Workflows de documentación: DeepSeek puede incorporarse en flujos de documentación de software. Por un lado, un desarrollador podría usarlo para generar borradores de documentación técnica a partir de comentarios o especificaciones (por ejemplo, crear la base de un README o explicar el uso de una API pública). Por otro lado, integraciones sencillas vía API permiten que herramientas de documentación automática consulten a DeepSeek para describir funciones o corregir redacción. Esto resulta útil para mantener documentación actualizada y comprensible, aunque siempre se debe revisar manualmente el resultado antes de publicarlo.

Asistencia en revisión de código: En entornos colaborativos como los repositorios Git, DeepSeek puede ayudar a analizar pull requests o parches de código. Un posible uso es un script o acción de CI que envíe el diff de un PR a la API de DeepSeek y obtenga sugerencias de mejora o detección de posibles errores. Del mismo modo, un desarrollador individual puede copiar trozos de un commit y preguntarle a DeepSeek si ve posibles problemas. Esta asistencia en la revisión puede detectar casos que pasen desapercibidos, aunque no reemplaza una revisión humana exhaustiva. (Se debe evitar mencionar nombres de empresas específicas en este contexto; baste decir que la integración con plataformas de control de versiones es viable mediante la API de DeepSeek.)

Aprendizaje y experimentación: DeepSeek también encuentra uso en escenarios de aprendizaje. Un programador puede hacer preguntas conceptuales («¿Qué significa este error de compilación en Java?») o pedir explicaciones de algoritmos durante su estudio, obteniendo respuestas inmediatas en español u otros idiomas soportados. Gracias a su versatilidad, sirve como compañero de experimentación: es posible jugar con el modelo para probar ideas de código, refactorizaciones sugeridas o incluso resolver retos de programación en un entorno controlado.

Esta faceta lo hace útil para investigadores o entusiastas que exploran las capacidades de la IA en programación. Eso sí, conviene recordar que las respuestas de DeepSeek pueden contener imprecisiones, por lo que se usan mejor como guía y no como verdad absoluta.

Integración técnica y acceso mediante APIs

Desde el punto de vista técnico, integrar DeepSeek en nuestras herramientas de desarrollo puede lograrse de varias formas. A grandes rasgos, existen dos enfoques principales: utilizar instancias locales (self-hosted) o bien consumir la API oficial en la nube. A continuación, exploramos ambos escenarios con precaución en las afirmaciones (usando expresiones como «puede» o «en ciertos entornos») y proporcionando ejemplos reales.

Uso local con Docker y Ollama: Una forma práctica de ejecutar DeepSeek localmente es mediante contenedores Docker u otras plataformas ligeras como Ollama. DeepSeek ofrece imágenes de Docker que facilitan la descarga e implementación del modelo en local. Por ejemplo, el modelo DeepSeek-R1 distill (8B parámetros) se puede obtener con Docker usando el Model Runner de Docker de la siguiente manera:

# Descarga el modelo DeepSeek-R1 Distill desde Docker Hub

docker model pull ai/deepseek-r1-distill-llama

# Ejecuta el modelo localmente

docker model run ai/deepseek-r1-distill-llama

Tras ejecutar estos comandos, se levanta un servicio local con el modelo de DeepSeek, al que podríamos conectarnos para hacer consultas. De manera similar, con Ollama (una plataforma para LLMs locales), un desarrollador puede instalar el modelo y servirlo en su máquina. Por ejemplo, tras instalar Ollama, bastaría con descargar el modelo con ollama pull deepseek-r1 y luego ejecutar ollama run deepseek-r1 para iniciar una instancia local del modelo DeepSeek. Herramientas como VS Code (con extensiones tipo CodeGPT, Continue.dev u otras) detectan este servicio local y permiten enviarle peticiones para asistencia en código directamente desde el editor.

Integrar DeepSeek localmente ofrece la ventaja de mantener todo in-house: al ejecutarse en tu propio PC o servidor, los datos de tu código permancen en tu máquina en lugar de enviarse a un servicio externo. Esto puede mejorar la privacidad en ciertos entornos sensibles, aunque es importante configurar todo correctamente para evitar cualquier telemetría no deseada. Además, al no depender de Internet, la asistencia de IA estaría disponible incluso offline una vez descargado el modelo.

Cabe destacar que montar un modelo avanzado de DeepSeek localmente puede requerir hardware potente (por ejemplo, suficiente memoria RAM/VRAM y CPU); muchos usuarios han notado un uso intensivo de recursos, haciendo que por ejemplo los ventiladores de su portátil se activen al máximo durante el funcionamiento. Por ello, este enfoque resulta ideal en entornos controlados (equipos de sobremesa, servidores o estaciones de trabajo con buena capacidad) y menos aconsejable en máquinas muy modestas.

Acceso mediante la API en la nube: DeepSeek también proporciona una API oficial que se puede integrar en aplicaciones y flujos de trabajo de desarrollo. Para utilizarla, primero es necesario obtener una clave de API registrándose en la plataforma de desarrolladores de DeepSeek. La API sigue un formato compatible con OpenAI, lo cual significa que muchas bibliotecas o SDK diseñados para ChatGPT u otros modelos se pueden reconfigurar fácilmente para apuntar a DeepSeek. Por ejemplo, la URL base para invocaciones es https://api.deepseek.com y los endpoints aceptan estructuras de mensajes tipo chat completions. A continuación se muestra una llamada de muestra al endpoint de chat usando cURL, donde <TU_API_KEY> representa la clave privada obtenida del portal de DeepSeek:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <TU_API_KEY>" \

-d '{

"model": "deepseek-chat",

"messages": [

{"role": "system", "content": "Eres un asistente útil."},

{"role": "user", "content": "¡Hola!"}

],

"stream": false

}'

En este ejemplo, se envía un mensaje sencillo al modelo deepseek-chat (que corresponde a la versión estándar de conversación de DeepSeek). La API responderá con un JSON que incluye la respuesta generada por el modelo. Del lado del desarrollador, podríamos invocar esta API desde casi cualquier lenguaje de programación (mediante peticiones HTTP).

De hecho, debido a la compatibilidad mencionada, es posible usar directamente los SDK de OpenAI simplemente cambiando el endpoint y la clave; por ejemplo, en Python utilizando la biblioteca openai se puede especificar base_url="https://api.deepseek.com" para apuntar al servicio de DeepSeek.

Al integrar vía API, podemos incorporar las capacidades de DeepSeek en múltiples escenarios: una aplicación web que ofrezca un chatbot para soporte en programación, una acción de GitHub que analice issues y genere respuestas, o incluso herramientas de línea de comandos que asistan al programador. Es importante usar lenguaje prudente al describir este tipo de integración: DeepSeek puede utilizarse en entornos locales y en la nube, pero la experiencia variará.

En ciertos entornos corporativos podría preferirse la instancia local por motivos de confidencialidad; en otros casos, usar la API en la nube de DeepSeek resultará más práctico para evitar la carga computacional local. No debemos hacer afirmaciones absolutas sobre privacidad o rendimiento: si bien ejecutar DeepSeek en local implica que nuestros datos no salen a terceros, también conlleva un costo computacional; por el contrario, usar la API oficial delega el cómputo en los servidores de DeepSeek pero implica confiar los datos a un servicio externo. Cada equipo debe evaluar estas compensaciones según su realidad.

(Recomendación: independientemente de la vía de integración, asegúrate de revisar los términos de uso de la API y respetar los límites de tasa de peticiones. A enero de 2026, DeepSeek ofrece un nivel gratuito sin suscripción para uso básico en su plataforma web, pero las políticas de la API podrían cambiar y conviene consultar la documentación actualizada.)

Limitaciones y consideraciones técnicas

Al incorporar DeepSeek en proyectos de desarrollo, es crucial tener en cuenta sus limitaciones y algunas consideraciones técnicas importantes:

Límites del contexto y versión del modelo: Cada modelo de DeepSeek tiene una ventana de contexto máxima, es decir, la cantidad de texto que puede procesar de una vez. Afortunadamente, los modelos recientes de DeepSeek manejan contextos amplios (en torno a 128 mil tokens en las versiones V3/R1), lo cual es significativamente mayor que muchos LLMs anteriores. Esto permite, por ejemplo, pasarle archivos de código bastante grandes o mantener conversaciones largas. No obstante, sigue habiendo un límite: si se excede esa cantidad de texto, el modelo no podrá considerarlo completo en su respuesta.

Además, DeepSeek cuenta con diferentes modelos (V3, R1, etc.) con fortalezas distintas. La versión DeepSeek V3 está orientada a usos generales y eficiencia, mientras que DeepSeek R1 se optimiza más para razonamiento lógico y tareas precisas, a costa de requerir más recursos computacionales. Como desarrollador, deberás seleccionar la variante adecuada según el caso de uso (por ejemplo, R1 podría rendir mejor explicando un algoritmo complejo, pero V3 podría ser suficiente para generar documentación sencilla).

Recursos computacionales y rendimiento: Ejecutar modelos de lenguaje grandes supone una carga considerable de hardware. DeepSeek no es la excepción. Si optas por correrlo localmente, verifica que cuentas con suficiente VRAM, RAM y CPU para el modelo elegido. Por ejemplo, la variante distil de 8B parámetros de DeepSeek-R1 puede requerir del orden de 5 GB de VRAM, mientras que una variante de 70B puede necesitar cerca de 40 GB – algo únicamente disponible en GPUs de alta gama o servidores especializados. En entornos con hardware limitado, el rendimiento puede degradarse o directamente no ser posible la ejecución. Incluso usando la API (donde el cómputo es del lado del servidor de DeepSeek), hay que anticipar posibles latencias en respuestas muy largas o durante horas pico de uso del servicio. También se ha reportado que modelos locales pueden hacer un uso intensivo del procesador/GPU, lo que podría ralentizar otras tareas en tu máquina mientras están activos. En resumen, considera el impacto en rendimiento y quizá realiza pruebas con modelos más pequeños (o cuantizados) si tu entorno no es muy potente.

Necesidad de validación y revisión del resultado: Aunque DeepSeek puede generar código, explicaciones y recomendaciones útiles, no se debe confiar ciegamente en la salida generada. La IA a veces puede producir respuestas plausibles pero incorrectas – un fenómeno conocido como alucinación. Por ello, cualquier código sugerido por DeepSeek debe ser probado y revisado manualmente antes de incorporarse a un proyecto serio. Igualmente, si se usa para explicar un fragmento de código, conviene que un desarrollador confirme que la explicación es exacta.

Considera a DeepSeek como un colaborador que propone ideas, pero no como un juez infalible. Esta necesidad de validación aplica tanto a uso en código (donde podría introducir bugs sutiles) como en documentación (podría omitir detalles importantes o exagerar ciertas afirmaciones). En entornos profesionales, mantener en la cadena de uso revisiones humanas y pruebas automáticas es indispensable, incluso cuando DeepSeek agilice la generación inicial de contenido.

No es un sustituto de herramientas especializadas: DeepSeek es una herramienta polivalente y potente, pero no reemplaza a las herramientas de desarrollo tradicionales especializadas en ciertas tareas. Por ejemplo, para refactorizaciones complejas de un gran códigobase, seguirá siendo más fiable emplear un conjunto de pruebas unitarias, linters y análisis estático que únicamente confiar en las sugerencias de la IA. De igual modo, un debugger interactivo o profiler proporcionará información de rendimiento que un modelo de lenguaje simplemente desconoce.

La mejor forma de ver a DeepSeek es como un complemento: puede aumentar la productividad al escribir código o al entender problemas, pero no debería omitir los procesos de ingeniería de software establecidos. Ten en cuenta también que DeepSeek (al igual como otras IA) tiene un conocimiento basado en su entrenamiento (actualizado aproximadamente hasta 2025 en la versión V3.2) y puede no conocer las librerías o tecnologías más recientes posteriores a esa fecha, por lo que en esos casos otras fuentes de información (documentación oficial, comunidad) pueden ser necesarias.

Consideraciones de privacidad y seguridad: Si bien ya mencionamos que ejecutar DeepSeek localmente evita enviar datos a terceros, cabe reiterar que si utilizas la API en la nube, estarás transmitiendo fragmentos de tu código o texto a los servidores de DeepSeek. Asegúrate de no enviar claves secretas, datos sensibles o código propietario sin la debida autorización o precaución. Revisa la política de privacidad de DeepSeek y, en contextos empresariales, posiblemente opta por instancias locales o autoalojadas para garantizar que ninguna porción de tu código salga de tu entorno. Además, desde un punto de vista técnico, nunca ejecutes directamente código proporcionado por DeepSeek sin revisarlo, especialmente si proviene de consultas abiertas: podría haber implicaciones de seguridad (por ejemplo, sugestiones de código inseguro) que solo un desarrollador humano puede juzgar en contexto.

¿Cuándo puede ser una opción adecuada para desarrolladores?

Dado lo anterior, ¿en qué situaciones vale la pena utilizar DeepSeek como parte del arsenal de herramientas de un desarrollador? Y, por el contrario, ¿cuándo podría convenir más usar otras soluciones? A continuación, listamos algunos casos para orientar esta decisión, usando lenguaje mesurado en lugar de afirmaciones absolutas:

DeepSeek resulta particularmente útil en casos como:

Proyectos experimentales, personales o de bajo riesgo: Si estás trabajando en un proyecto propio, aprendiendo un nuevo lenguaje o simplemente probando ideas, DeepSeek puede ser un aliado excelente. Al ser una plataforma abierta y (actualmente) gratuita en su modalidad estándar, permite acceder a capacidades de IA avanzadas sin incurrir en costo. Un desarrollador independiente puede beneficiarse de su ayuda para generar código boilerplate, obtener explicaciones de algoritmos o traducir fragmentos entre lenguajes, todo de forma rápida y sin salir de su entorno local. En este tipo de escenarios, la naturaleza exploratoria de DeepSeek encaja bien, ya que cualquier error generado por la IA se puede detectar y corregir sin mayores consecuencias.

Entornos con altos requerimientos de privacidad: En situaciones donde el código o los datos no pueden compartirse con servicios en la nube (por ejemplo, desarrollo de software propietario muy sensible, instituciones gubernamentales, entornos air-gapped sin Internet), una instancia local de DeepSeek ofrece una alternativa para seguir teniendo asistencia de IA. Aquí DeepSeek brilla porque, al ser de código abierto, puede desplegarse en servidores aislados y configurarse según políticas internas. Si una empresa no quiere enviar su código a herramientas SaaS de terceros, podría considerar DeepSeek (con todas las advertencias mencionadas de validación) como una opción para dotar a sus desarrolladores de ayuda inteligente sin violar reglas de confidencialidad. Siempre se debe comunicar claramente que DeepSeek en estos casos es una solución no oficial y experimental, para que los equipos de seguridad lo evalúen apropiadamente.

Desarrolladores con mentalidad DIY y control sobre sus herramientas: Aquellos programadores a quienes les gusta tener control total sobre su entorno de desarrollo pueden preferir DeepSeek por encima de alternativas cerradas. La posibilidad de ajustar parámetros, elegir entre modelos (p. ej. usar DeepSeek-R1 para tareas de lógica compleja o DeepSeek-V3 para generalistas) e incluso modificar el modelo o contribuir a su mejora, resulta atractiva para la comunidad open source. Asimismo, integrar DeepSeek vía API en herramientas caseras, scripts personalizados o flujos CI es más factible gracias a su compatibilidad y documentación abierta. En resumen, si valoras la flexibilidad por encima de la comodidad plug-and-play, DeepSeek puede ser la opción adecuada.

Por el contrario, otras herramientas podrían ser más adecuadas si:

Requieres el máximo nivel de precisión y soporte: En proyectos críticos (piensa en software médico, aeroespacial, financiero de alto riesgo) quizás no sea prudente depender de un modelo generativo cuya exactitud no está garantizada al 100%. Para tales casos, las soluciones comerciales establecidas (con soporte oficial, acuerdos de nivel de servicio, etc.) o herramientas tradicionales de desarrollo pueden inspirar más confianza. DeepSeek, al ser relativamente nuevo, no tiene el mismo historial que otras herramientas especializadas; un equipo puede optar por utilizarlo de manera limitada o no usarlo en absoluto cuando la tolerancia a errores es prácticamente nula.

Ya cuentas con una herramienta de IA robusta en tu flujo de trabajo: Por ejemplo, algunas empresas o desarrolladores individuales invierten en suscripciones a servicios como GitHub Copilot u otras IA especializadas entrenadas en código. Si esas herramientas ya se integran perfectamente con tu IDE, te ofrecen las funcionalidades deseadas y cumplen con tus requisitos de privacidad (p. ej., algunas ofrecen modos de no enviar ciertos datos), puede que DeepSeek no añada un valor significativo en ese entorno. En otras palabras, si no tienes una carencia que DeepSeek venga a solucionar, introducirlo podría complicar innecesariamente tu flujo. La recomendación en este caso sería evaluar con mente abierta qué te aporta DeepSeek que no tengas ya; si la respuesta es “poco o nada nuevo”, quizá mantener tus herramientas actuales sea lo más sensato por ahora.

Limitaciones de infraestructura o tiempo: Imagina que trabajas en un equipo con plazos muy ajustados y sin tiempo para experimentar, o en una máquina de recursos muy limitados (ej.: un portátil básico) donde instalar un modelo local de varios gigabytes es poco viable. En estos contextos, la vía rápida suele ser usar servicios en la nube ya optimizados por los proveedores, incluso si implican costo. DeepSeek, al requerir esa configuración inicial (descarga de modelo, posible ajuste de extensiones, etc.), podría no encajar cuando se busca inmediatez absoluta. Asimismo, si tu entorno de desarrollo es muy heterogéneo (por ejemplo, decenas de desarrolladores en distintos SO) y no quieres añadir complejidad de soporte técnico, apoyarte en una solución centralizada (sea otra AI o una herramienta convencional) podría ser más práctico que pedir a todos que integren DeepSeek por su cuenta.

En suma, la adopción de DeepSeek debe evaluarse caso por caso. No es cuestión de que sea mejor o peor que otras opciones, sino de entender qué ofrece y en qué circunstancias aprovechas esas ventajas. Muchos desarrolladores encuentran en DeepSeek un excelente aliado para ciertas tareas, mientras que para otras siguen confiando en las herramientas de siempre. Lo importante es tener claras las expectativas y usar la herramienta apropiada para cada problema.

Probar DeepSeek desde esta plataforma

Finalmente, si tras leer esta guía te pica la curiosidad y quieres experimentar con DeepSeek por ti mismo, te animamos a probar el modelo directamente desde esta plataforma. Puedes dirigirte a la página de inicio de DeepSeek en español donde encontrarás la interfaz de chat para interactuar con DeepSeek en tu idioma de forma gratuita y sin registro. Desde ahí podrás hacer preguntas, pedir ayudas de programación o simplemente explorar las capacidades conversacionales de la IA. Ten presente que esta plataforma es una iniciativa no oficial creada con fines educativos y de acceso abierto; por tanto, úsala de forma exploratoria para familiarizarte con DeepSeek.

Recuerda las buenas prácticas al probarlo: formula preguntas claras, divide peticiones complejas en partes, y sobre todo disfruta descubriendo lo que DeepSeek puede (y no puede) hacer. Si te interesa integrar DeepSeek en tus propios proyectos, consulta la documentación de la API para obtener detalles técnicos, ejemplos adicionales y referencias sobre las últimas versiones del modelo. Y no olvides que, aunque la inteligencia artificial puede ahorrarte tiempo y ofrecerte nuevas perspectivas, tu criterio profesional y revisión seguirán siendo la pieza clave para un desarrollo de software exitoso. ¡Feliz programación!