DeepSeek V3.1 es un modelo de lenguaje de IA de última generación y código abierto, diseñado para desarrolladores que buscan potencia y flexibilidad.

Lanzado en agosto de 2025, este modelo destaca por su enfoque híbrido de razonamiento y su enorme escala.

Con 671 mil millones de parámetros totales (con ~37 mil millones activos por token) y una ventana de contexto extendida de 128.000 tokens, DeepSeek V3.1 puede manejar tareas complejas con gran volumen de datos de entrada.

Además, introduce un mecanismo innovador de “dos modos de inferencia” – uno orientado al razonamiento paso a paso y otro a respuestas directas – todo dentro del mismo modelo.

A continuación exploraremos sus novedades técnicas, detalles de arquitectura, casos de uso relevantes y cómo integrarlo en tus proyectos.

Novedades Clave en DeepSeek V3.1

DeepSeek V3.1 incorpora mejoras significativas con respecto a versiones anteriores, enfocadas en aumentar sus capacidades y usabilidad para desarrolladores.

Sus principales novedades incluyen:

- Modo de razonamiento híbrido (Think & Non-Think): El modelo puede alternar entre un modo “pensante” con cadena de razonamiento paso a paso y un modo directo de respuesta inmediata. Esto se logra mediante plantillas de prompt especiales o banderas de API, permitiendo que un solo modelo cubra casos de uso generales y tareas de razonamiento complejo sin cambios manuales. En la práctica, DeepSeek V3.1 determina automáticamente si necesita iniciar un proceso de pensamiento detallado según la consulta.

- Ventana de contexto extendida (128K tokens): Soporta entradas de hasta 128.000 tokens (alrededor de 100.000 palabras), lo que habilita el procesamiento eficiente de documentos extensos, conversaciones multi-turno largas y grandes bases de código. Esta expansión masiva de contexto (frente a los típicos 4K o 8K de contextos estándar) permite nuevos casos de uso, como análisis de documentos completos o mantenimiento de historial de chat extenso, sin perder información.

- Mejoras en uso de herramientas y agentes: DeepSeek V3.1 fue optimizado mediante post-entrenamiento para desempeñarse mejor en tareas de agente autónomo. Ahora maneja llamadas a herramientas externas de forma estructurada (por ejemplo, ejecutar búsquedas web, consultar APIs, ejecutar código) y resuelve tareas multistep con mayor eficacia. Esto la convierte en una plataforma ideal para construir sistemas de IA autónomos, integrando fácilmente agentes de código y agentes de búsqueda en flujos de trabajo de desarrollo.

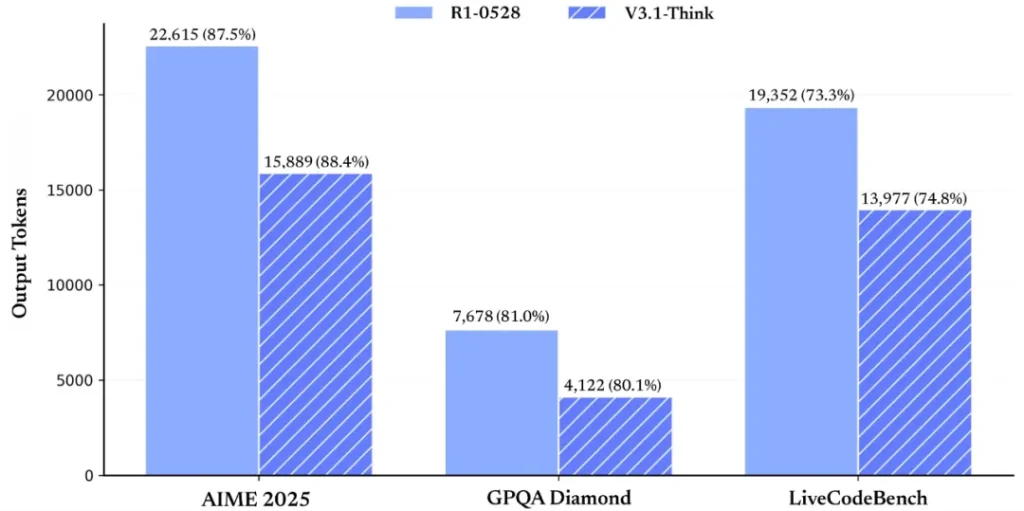

- Eficiencia y rapidez de razonamiento: Aun proporcionando explicaciones detalladas cuando está en modo pensante, DeepSeek V3.1 logra respuestas más concisas y rápidas gracias a mejoras en la eficiencia de su cadena de pensamiento. En benchmarks exigentes de matemáticas y programación, su modo de “pensamiento” alcanzó una precisión comparable (o superior) a la de modelos previos de razonamiento, usando hasta 30–50% menos tokens de salida. En resumen, razona mejor sin divagar, brindando soluciones óptimas con menos verborrea.

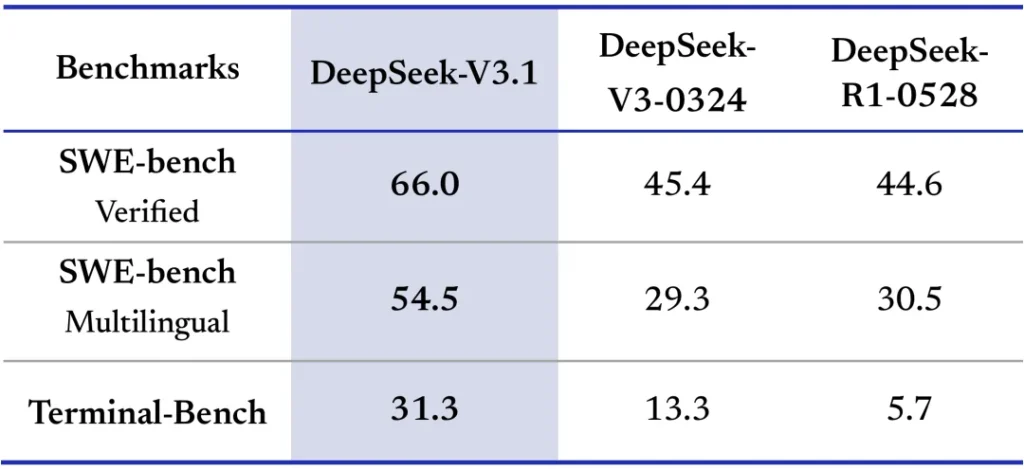

- Generación de código avanzada: Este modelo destaca en tareas de programación. Ha demostrado notables mejoras en benchmarks de ingeniería de software, superando a sus predecesores en generación de código correcto y depuración. Esto lo hace muy atractivo para automatizar generación de código, asistencia en debugging y desarrollo de software, ofreciendo resultados de alta calidad de forma eficiente.

- Soporte multilingüe y precisión mejorada: DeepSeek V3.1 domina más de 100 idiomas con nivel casi nativo, incluyendo mejoras sustanciales en idiomas de bajos recursos. Los desarrolladores pueden aprovecharlo para aplicaciones globales, ya que el modelo maneja con solvencia consultas en español, inglés, chino y muchos otros. Además, se ha trabajado en reducir las alucinaciones y mejorar la exactitud factual de las respuestas, proporcionando resultados más confiables en comparación con iteraciones anteriores (aunque siempre conviene validar las salidas para decisiones críticas).

- Modelo abierto y personalizable: DeepSeek V3.1 se distribuye bajo licencia MIT, liberando tanto los pesos del modelo como informes técnicos. Esto significa que la comunidad de desarrolladores puede inspeccionar el modelo, implementarlo localmente, afinarlo o integrarlo comercialmente sin restricciones. La apertura del ecosistema fomenta la transparencia y la colaboración académica, a la vez que ofrece flexibilidad para adaptarlo a casos de uso especializados.

Arquitectura del Modelo y Variantes (Base, Chat, MoE)

Arquitectura Mixture-of-Experts (MoE) a gran escala

Una de las características técnicas más impresionantes de DeepSeek V3.1 es su arquitectura Mixture-of-Experts (MoE).

En lugar de un modelo denso tradicional, emplea múltiples “expertos” especializados dentro de sus capas de red.

Esto le permite tener un tamaño colosal de 671B (671 mil millones) de parámetros totales, pero activando solo unos 37B de parámetros por token procesado.

En la práctica, el modelo aprende a activar dinámicamente distintos subconjuntos de sus neuronas (“expertos”) según la tarea, en vez de utilizar todo el modelo para cada petición.

Este enfoque hace posible escalar la capacidad sin incurrir totalmente en los costes de inferencia de un modelo 100% denso de ese tamaño.

Gracias a la arquitectura MoE, DeepSeek V3.1 logra un equilibrio entre potencia y eficiencia.

Por un lado, tiene un amplio conocimiento y diversas habilidades encapsuladas en sus expertos; por otro, el cálculo en cada inferencia se limita a los parámetros más relevantes, reduciendo el consumo computacional.

Para aprovechar esta arquitectura a gran escala, el modelo fue entrenado y ajustado usando técnicas avanzadas de reducción de precisión, como un formato FP8 de “microscaling” en pesos y activaciones, que permite manejar la enorme cantidad de parámetros de manera más eficiente en hardware moderno.

Además, para soportar la ventana de contexto de 128K, los investigadores de DeepSeek extendieron el entrenamiento en múltiples fases: primero llevando el contexto a 32K y luego a 128K, acumulando cientos de miles de millones de tokens de datos adicionales durante estas fases.

Esta estrategia de long context fine-tuning amplió la capacidad del modelo para recordar e integrar información muy lejana en la secuencia de entrada, algo crucial para mantener coherencia en textos largos o código extenso.

Variante Base vs. modelo Chat (instruccional)

DeepSeek V3.1 se presenta principalmente en dos variantes de modelo para desarrolladores:

- DeepSeek V3.1-Base: Es la versión base pre-entrenada del modelo, entrenada con objetivos genéricos de predicción de siguiente token a gran escala (similar a otras LLM base). Actúa como modelo fundacional sobre el cual se construyen las demás variantes. La versión base posee todo el conocimiento y capacidad del modelo (671B parámetros MoE), pero no está afinada para interacción conversacional ni tiene incorporadas explícitamente las instrucciones de alineación con usuario. Desarrolladores podrían utilizar V3.1-Base para fine-tunings personalizados o investigaciones, partiendo de un modelo amplio sin sesgos de alineación.

- DeepSeek V3.1 (Chat): Cuando hablamos simplemente de “DeepSeek V3.1”, normalmente nos referimos a la variante afinada para chat/instrucciones. Este modelo se obtuvo aplicando instrucción tuning y técnicas de refuerzo con feedback humano (RLHF) sobre la base, para hacerla más útil, segura y coherente en conversaciones. La versión Chat es la recomendada para la mayoría de usos prácticos: entiende prompts en lenguaje natural, sigue instrucciones del usuario, mantiene el contexto de una conversación y aprovecha las capacidades de razonamiento integrado. Importante: esta variante soporta los modos de pensamiento descritos anteriormente, permitiendo tanto respuestas directas como explicaciones paso a paso según se requiera.

Ambas variantes comparten la misma arquitectura central y ventana de contexto; la diferencia radica en su afinación y comportamiento.

Por ejemplo, el modelo Chat viene con plantillas de formato de prompt especiales (definidas en su configuración de tokenizer) que manejan internamente los tokens <think> para activar/desactivar el razonamiento.

Para el desarrollador, esto se traduce en usar la variante correcta según el caso: la mayoría empleará deepseek-chat-v3.1 vía API para obtener respuestas conversacionales y con razonamiento bajo demanda, mientras que deepseek-v3.1-base queda disponible para entrenamiento adicional o uso personalizado.

Nota: Unos meses después del lanzamiento de V3.1, los creadores presentaron DeepSeek V3.1-Terminus, una actualización menor enfocada en mejorar la consistencia del lenguaje de salida (evitando mezclas de idiomas o caracteres extraños) y optimizar aún más los agentes de código y búsqueda. Terminus mantiene la misma arquitectura y parámetros, sirviendo como checkpoint refinado para entornos que requieran mayor estabilidad. No obstante, la información de este artículo se centra en DeepSeek V3.1 tal como fue lanzado originalmente, que sigue siendo la base principal para desarrolladores.

Casos de Uso Relevantes de DeepSeek V3.1

Gracias a sus capacidades técnicas, DeepSeek V3.1 abre un abanico de aplicaciones avanzadas en el desarrollo de software y productos de IA.

A continuación, destacamos algunos casos de uso clave donde este modelo sobresale:

Asistente de programación y generación de código: DeepSeek V3.1 brilla en tareas de ingeniería de software. Por su entrenamiento y tamaño, entiende instrucciones de codificación complejas y produce código de alta calidad en múltiples lenguajes. Sus mejoras en benchmarks de coding (como LiveCodeBench, Codeforces, etc.) indican que puede generar funciones, sugerir refactorizaciones y hasta detectar errores o vulnerabilidades en código existente. Los desarrolladores pueden integrarlo como un asistente de codificación en IDEs, para code completion, generación de tests unitarios, documentación automática, etc. Con 128K de contexto, incluso es viable proporcionarle un repositorio extenso o varios archivos para que analice dependencias y ofrezca soluciones a nivel de proyecto.

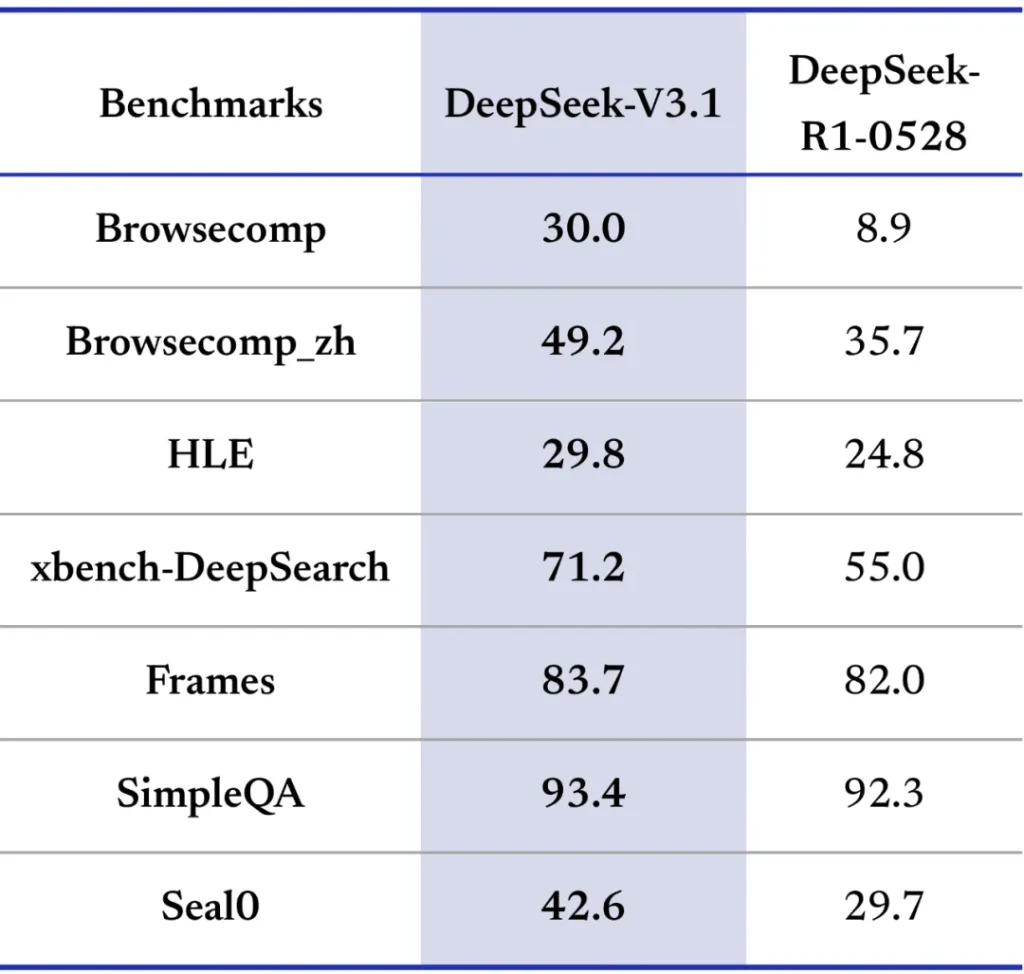

Agentes de búsqueda y herramientas externas: La habilidad de DeepSeek V3.1 para usar herramientas lo hace ideal para construir agentes autónomos tipo GPT-Engineer o AutoGPT. Por ejemplo, puede actuar como un agente de investigación que consulta APIs, realiza búsquedas web, extrae datos y luego razona con esa información para resolver una tarea. Sus puntajes en benchmarks de agente (como BrowseComp o Search QA) mejoraron drásticamente respecto a modelos previos, evidenciando su utilidad como motor de búsqueda inteligente o asistente en análisis de datos. Un caso de uso concreto es un chatbot que, ante una pregunta, use el modo “pensante” para buscar en documentación interna o en la web, recopilando fuentes, y luego presente al usuario una respuesta fundamentada con referencias. El soporte de llamadas estructuradas a herramientas (formato <tool_call>) facilita esta integración programática, dando a los programadores control sobre cómo y cuándo el modelo debe invocar capacidades externas.

Asistentes conversacionales avanzados (ámbito empresarial): Por su perfil híbrido, DeepSeek V3.1 puede funcionar tanto como un chatbot conversacional rápido en consultas sencillas (modo directo) como un asesor experto que explica detalladamente temas complejos (modo pensante). Esto es especialmente valioso en entornos empresariales y educativos. Empresas pueden desplegar asistentes virtuales que soporten múltiples idiomas con fluidez, brindando soporte técnico o atención al cliente 24/7 aprovechando su entendimiento de contexto extenso. Su dominio de más de 100 idiomas garantiza respuestas matizadas y culturalmente apropiadas, permitiendo aplicaciones globales sin tener que recurrir a modelos diferentes por idioma. Además, en sectores como el legal o médico, donde es crucial exponer el razonamiento detrás de una recomendación, DeepSeek V3.1 puede proveer explicaciones paso a paso de sus conclusiones, aportando transparencia (“visibility into its decision-making process”). Esto ayuda a cumplir requisitos de IA responsable al justificar respuestas.

En todos estos escenarios, el carácter de código abierto de DeepSeek V3.1 ofrece una ventaja adicional: los desarrolladores pueden desplegarlo en entornos on-premise o en la nube privada, manteniendo control total sobre datos sensibles y cumpliendo políticas de privacidad.

Asimismo, la comunidad puede ajustar el modelo (mediante fine-tuning adicional) a dominios específicos – por ejemplo, entrenarlo con jerga médica, financiera o técnica – para que actúe con experticia aún mayor en ese ámbito.

Integración de DeepSeek V3.1 en Proyectos de Desarrollo

Integrar DeepSeek V3.1 a tus proyectos es factible gracias a las opciones flexibles que ofrece tanto la compañía DeepSeek como la comunidad open-source.

A continuación, se presentan las vías principales para utilizar este modelo y algunos ejemplos prácticos para desarrolladores:

1. Consumo mediante API en la nube: La forma más sencilla de aprovechar DeepSeek V3.1 es a través de su API oficial (o servicios compatibles). DeepSeek ofrece una API de chat completions compatible con el estilo de OpenAI, lo que significa que el formato de las solicitudes y respuestas es similar al de modelos como GPT-4. Solo necesitas obtener una clave de API registrándote en el portal de desarrolladores de DeepSeek (que proporciona créditos gratuitos iniciales). Luego podrás realizar llamadas HTTPS POST al endpoint de chat, especificando el modelo "deepseek-chat-v3.1" y pasando tu conversación en el campo messages. Por ejemplo, puedes enviar un historial con roles "system", "user" y "assistant" al estilo ChatGPT, y el modelo responderá acorde.

Una característica importante es la opción de activar o desactivar el “modo pensar” vía API. Esto se logra incluyendo un parámetro booleano especial – por ejemplo "reasoning_enabled": true – en la carga JSON de la solicitud. Cuando reasoning_enabled es true, el modelo entra en modo de razonamiento y puede generar internamente una cadena de pensamiento antes de dar la respuesta final; si es false, responderá directamente de forma más concisa. (Nota: el nombre exacto del parámetro puede variar según el proveedor; en la API nativa de DeepSeek es reasoning_enabled, mientras que en plataformas como OpenRouter podría usarse otra clave, pero la función es la misma.) Abajo vemos un ejemplo de código en Python utilizando la API de DeepSeek:

import requests

import json

API_KEY = "TU_CLAVE_API_DEEPSEEK"

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-chat-v3.1",

"messages": [

{"role": "system", "content": "Eres un asistente de ingeniería útil y conciso."},

{"role": "user", "content": "Dame una lista de verificación (checklist) de 5 pasos para desplegar de forma segura una aplicación Django."}

],

"max_tokens": 400,

"temperature": 0.0,

"reasoning_enabled": true # activar modo "Think"

}

response = requests.post(url, headers=headers, json=payload)

data = response.json()

print(data["choices"][0]["message"]["content"])

En este ejemplo, se hace una petición a la API de DeepSeek usando un formato muy similar al de OpenAI. Se define el modelo deepseek-chat-v3.1, se envía un prompt de usuario pidiendo una checklist de despliegue seguro en Django, y se habilita el razonamiento (reasoning_enabled: true) para que el asistente explique cada paso si es necesario. La respuesta (data["choices"][0]["message"]["content"]) contendrá el mensaje del asistente con la lista solicitada. Este enfoque vía API es adecuado cuando deseas integrar DeepSeek en aplicaciones web, servicios backend o chatbots, sin preocuparte por alojar el modelo localmente.

2. Plataformas y proveedores compatibles: DeepSeek V3.1 también está disponible a través de plataformas de IA gestionada. Por ejemplo, Amazon Bedrock (AWS) incluyó este modelo como parte de sus servicios, permitiendo a clientes de AWS invocarlo fácilmente con infraestructura serverless de alta escalabilidad. En Bedrock, puedes seleccionar DeepSeek-V3.1 desde la consola, incluso alternar el “Model reasoning mode” con un simple toggle para encender/apagar el modo de pensamiento antes de generar la respuesta. Servicios como Bedrock proporcionan ventajas como autenticación integrada, monitoréo, guardrails de seguridad y optimizaciones de rendimiento, siendo ideales para entornos empresariales que requieran robustez y cumplimiento. Otra opción es usar OpenRouter, un gateway que unifica acceso a múltiples modelos open-source: a través de OpenRouter puedes llamar a deepseek-chat-v3.1 de forma similar a la API nativa, con la conveniencia de gestionar varias fuentes y claves en un solo lugar.

3. Auto-hosting con los pesos abiertos: Para casos en los que necesites control total o modificar el modelo, puedes descargar los pesos de DeepSeek V3.1 (tanto la variante Base como la Chat) desde Hugging Face. Ten en cuenta que ejecutar localmente un modelo MoE de 671B parámetros no es trivial: requerirás hardware altamente especializado (GPUs A100/H100 en cantidad, o vCPUs en la nube con soporte de aceleración adecuada) y software optimizado para MoE y contextos largos (frameworks como vLLM, FasterTransformer con soporte 128K, etc.). DeepSeek proporciona en su GitHub guías para correr el modelo en entornos locales, aprovechando la misma arquitectura que DeepSeek V3. Aunque pocos desarrolladores individuales podrán desplegar la variante completa debido a los recursos necesarios, la disponibilidad del modelo permite que surjan versiones distiladas o cuantizadas mantenidas por la comunidad. De hecho, existen cuantizaciones en 8-bit y 4-bit, e incluso proyectos de investigación que reducen el número de expertos activos, buscando acercar el uso de V3.1 a hardware más asequible.

En resumen, para la mayoría de desarrolladores la API en la nube será el camino más rápido para integrar DeepSeek V3.1 en sus aplicaciones, mientras que las plataformas gestionadas ofrecen solidez para soluciones empresariales, y la auto-implementación queda como opción para quienes necesiten personalización extrema o deseen contribuir al desarrollo del modelo.

Independientemente de la vía elegida, la interfaz estilo OpenAI Chat y la documentación disponible hacen que la curva de aprendizaje sea relativamente suave.

Conclusiones

DeepSeek V3.1 representa un hito técnico en el panorama de modelos de lenguaje abiertos. Combina capacidades de razonamiento profundo y generación de texto fluida en un solo sistema, brindando a los desarrolladores una herramienta versátil que se adapta tanto a consultas directas como a problemas que requieren análisis detallado.

Sus mejoras en contexto, arquitectura y uso de herramientas lo posicionan como una opción de punta para construir la próxima generación de aplicaciones de IA: desde asistentes de programación inteligentes, pasando por agentes autónomos de búsqueda de información, hasta chatbots multilingües con comprensión de largas conversaciones.

En términos de SEO técnico, DeepSeek V3.1 atiende precisamente la intención de búsqueda de desarrolladores avanzados: aquellos interesados en «nuevos modelos de lenguaje de código abierto», «integración de LLM en proyectos software», o «modelos con contextos largos y razonamiento».

Al ser un modelo abierto y respaldado por documentación sólida, la información sobre su arquitectura Mixture-of-Experts, sus variantes Base/Chat, y sus casos de uso en programación y agentes es altamente relevante y buscada en la comunidad.

Para los ingenieros y programadores, adoptar DeepSeek V3.1 significa acceder a tecnología de IA de vanguardia sin las barreras de un ecosistema cerrado.

Pueden inspeccionar su funcionamiento, ajustarlo a sus necesidades y desplegarlo donde prefieran.

En última instancia, DeepSeek V3.1 invita a la experimentación y la innovación: es una plataforma sobre la cual construir soluciones inteligentes, eficientes y a escala, manteniendo siempre un control técnico total.

Si estás desarrollando aplicaciones que requieran comprensión del lenguaje natural, razonamiento complejo o manejo de contextos masivos, DeepSeek V3.1 es una pieza clave a considerar en tu arsenal de herramientas.

¡El futuro de los asistentes inteligentes y agentes autónomos está aquí, y está al alcance de la comunidad de desarrolladores!