DeepSeek VL es un modelo multimodal de visión-lenguaje (VL) de código abierto, diseñado para entender y procesar simultáneamente información visual y textual en contextos del mundo real.

A diferencia de los modelos tradicionales que solo manejan texto o solo imágenes, DeepSeek VL combina visión por computadora con un poderoso modelo de lenguaje grande (LLM) para razonamiento visual avanzado. Esto le permite analizar desde imágenes comunes hasta diagramas complejos, extrayendo significado tanto de los píxeles como de las palabras.

En este artículo exploramos las capacidades VL de DeepSeek VL, su arquitectura general, cómo maneja entradas mixtas de texto e imagen, su habilidad de OCR integrado, comprensión de gráficos y más.

También veremos cómo los desarrolladores pueden usar DeepSeek VL en aplicaciones reales – desde asistentes visuales inteligentes hasta la generación de respuestas a partir de documentos escaneados – todo con un tono profesional y técnico enfocado a ingenieros.

Arquitectura híbrida y capacidades del modelo

DeepSeek VL se construye sobre una arquitectura modular que integra múltiples componentes especializados para procesar imágenes y texto de forma unificada. En términos generales, el sistema se compone de tres módulos principales: un codificador de visión híbrido, un adaptador visión-lenguaje y un modelo de lenguaje base. A continuación, describimos estos componentes y cómo contribuyen a las capacidades multimodales del modelo.

Codificador de visión híbrido (imágenes de alta y baja resolución)

El codificador de visión de DeepSeek VL emplea un enfoque híbrido para extraer características tanto de los detalles finos en las imágenes como del contexto global. Consta de dos ramas complementarias:

- Encoder de alta resolución: Una red visual pre-entrenada (basada en un ViTDet derivado de SAM-B) capaz de procesar imágenes de hasta 1024×1024 píxeles. Esta rama se enfoca en capturar características de bajo nivel y detalles granulares de la imagen, asegurando que incluso información pequeña (como texto pequeño o elementos sutiles) sea percibida por el modelo.

- Encoder de baja resolución: Paralelamente, incorpora un modelo visual más ligero (denominado SigLIP-L) que procesa la misma imagen escalada a 384×384 píxeles. Esta rama de baja resolución provee una visión de contexto amplio de la escena, captando la disposición general y relaciones globales en la imagen.

Ambas salidas del codificador de visión se combinan posteriormente. El modelo emplea un adaptador visión-lenguaje que toma las características de alta y baja resolución y las fusiona en una secuencia unificada de tokens visuales.

Específicamente, las características se interpolan y reducen mediante capas convolucionales hasta generar un mapa de características de tamaño 24×24×1024, que luego se reorganiza en 576 vectores de dimensión 1024. Luego, este mapa de 576×1024 proveniente de la rama de alta resolución se concatena con la salida de la rama de baja resolución, produciendo 576 tokens visuales de dimensión 2048 cada uno. Estos embeddings visuales se activan con funciones GeLU y pasan por una capa de proyección para alinearse con el espacio de representación del modelo de lenguaje.

El resultado es un conjunto de tokens visuales integrados que el modelo de lenguaje puede interpretar junto con los tokens de texto.

Esta arquitectura híbrida permite a DeepSeek VL procesar imágenes de alta resolución eficientemente, manteniendo bajo el costo computacional gracias al procesamiento dual.

En lugar de depender exclusivamente de un encoder pesado o reducir la imagen a baja resolución (perdiendo detalle), el diseño captura lo mejor de ambos mundos: detalle fino y contexto global.

Esto es crucial para tareas como leer texto en imágenes (donde la alta resolución importa para OCR) y para entender escenas completas o diagramas grandes (donde el contexto global facilita el razonamiento).

Modelo de lenguaje integrado y entrenamiento conjunto

En el núcleo del sistema se encuentra un modelo de lenguaje (LLM) que sirve como cerebro textual de DeepSeek VL.

Este LLM – conocido como DeepSeek LLM – es el encargado de generar las respuestas en lenguaje natural a partir de la información visual y textual procesada. Un aspecto clave de la arquitectura de DeepSeek VL es cómo se integra el entrenamiento del LLM desde etapas tempranas del pre-entrenamiento multimodal.

A diferencia de enfoques donde primero se entrena la visión y luego se une con un modelo de lenguaje, los creadores de DeepSeek VL incorporaron el entrenamiento del LLM desde el inicio, gestionando cuidadosamente la dinámica competitiva entre la visión y el lenguaje durante el pre-entrenamiento.

Esto asegura que el modelo no sacrifique sus fuertes capacidades lingüísticas al aprender a interpretar imágenes.

En otras palabras, DeepSeek VL retiene la fluidez y comprensión contextual de un LLM moderno, a la vez que aprende a alinear conceptos visuales con palabras.

El entrenamiento de DeepSeek VL se realizó en tres etapas principales:

- Pre-entrenamiento inicial (Stage 1): Se congelaron tanto el encoder visual como el LLM, y se entrenó únicamente el adaptador que conecta visión y lenguaje. El objetivo aquí fue establecer una alineación conceptual entre las representaciones visuales y lingüísticas en el espacio de embeddings común, sin alterar las habilidades innatas del LLM ni del extractor visual.

- Pre-entrenamiento multimodal (Stage 2): En esta fase se descongelaron gradualmente componentes y se entrenó el modelo con grandes cantidades de datos multimodales (imagen-texto) junto con un volumen significativo de datos de texto puro. Al incluir una porción sustancial de datos textuales tradicionales, el modelo equilibra su atención entre modalidades, evitando degradar su comprensión del lenguaje mientras adquiere nuevas capacidades visuales. Este balance es crítico para lograr que el modelo responda con coherencia y conocimiento, incluso cuando la pregunta involucra poco contenido visual o requiere contexto externo.

- Afinación con instrucciones (Stage 3): Finalmente, el modelo pre-entrenado se sometió a un fine-tuning instruccional para especializarlo en seguir indicaciones y mantener diálogos coherentes. Usando un conjunto de datos de instrucciones multimodales (preguntas de usuarios con imágenes y texto), el modelo aprendió a actuar como un asistente visual conversacional. El resultado de esta etapa es la versión DeepSeek VL-Chat, optimizada para dialogar con usuarios de manera interactiva, siguiendo instrucciones al pie de la letra. Esta variante de chat es especialmente útil para integrarla en aplicaciones de tipo chatbot o asistentes de IA que necesiten entender imágenes.

Tamaños de modelo y variantes: La familia DeepSeek VL ofrece dos tamaños de modelo para distintos casos de uso: aproximadamente 1.3 mil millones de parámetros y 7 mil millones de parámetros. Cada tamaño viene en dos variantes: una versión base (pre-entrenada multimodalmente) y una versión chat (afinada con instrucciones para interacción).

Los modelos más grandes (7B) tienden a brindar mayor precisión y mejor razonamiento, mientras que los más pequeños (1.3B) ofrecen velocidad y eficiencia para despliegues con recursos limitados. Todas las versiones admiten secuencias de entrada de hasta 4096 tokens de texto, lo que significa que pueden manejar prompts largos o documentos extensos sin problemas.

Cabe destacar que DeepSeek VL es open-source y se ha liberado públicamente tanto el código como los pesos de los modelos, permitiendo su uso e integración libre (incluso en entornos comerciales, bajo los términos de su licencia)

Entrenamiento con datos de mundo real y cobertura de tareas

Para dotar al modelo de sus amplias habilidades, los autores de DeepSeek VL pusieron gran énfasis en un conjunto de datos diverso y representativo de casos reales. El pre-entrenamiento abarcó múltiples fuentes de datos multimodales, asegurando que el modelo aprendiera a manejar desde escenas cotidianas hasta contenido técnico.

Entre los principales tipos de datos utilizados se incluyen.

- Imágenes web y capturas de pantalla: Porciones del corpus provienen de screenshots de páginas web, interfaces de usuario y contenido digital diverso. Esto entrena al modelo para entender diseños web, elementos de UI y combinaciones de texto e imagen presentes en la información online cotidiana.

- Documentos escaneados y PDF (OCR): Se incluyó una gran cantidad de documentos digitalizados (ej. páginas de libros, PDFs escaneados, artículos) junto con su texto, para que el modelo aprendiera a reconocer caracteres ópticos (OCR) a nivel de documento. Gracias a ello, DeepSeek VL puede leer texto impreso en imágenes incluso bajo condiciones difíciles (por ejemplo, fotos borrosas o documentos con ruido), extrayendo su contenido textual.

- Imágenes con texto en escenas (Scene text): Además del OCR en documentos, el entrenamiento abarcó fotos del mundo real donde el texto aparece integrado en la escena (por ejemplo, letreros de calles, carteles, pantallas de dispositivos). Esto mejora la capacidad del modelo para detectar y leer texto en entornos no estructurados – útil para aplicaciones como asistentes para personas con discapacidad visual o análisis de imágenes de seguridad con textos.

- Gráficos, tablas y diagramas: Para enseñar al modelo a interpretar información visual de tipo gráfico o tabular, se utilizaron datos de imágenes de tablas y gráficos (p.ej., gráficos de líneas, de barras, diagramas de flujo, planos técnicos). De esta forma, DeepSeek VL puede comprender y resumir el contenido de gráficos o extraer conclusiones de datos visualizados en una imagen. Esto abarca habilidades como leer etiquetas y valores en una gráfica o seguir el flujo en un diagrama.

- Código e interfaces a partir de imagen: Un aspecto innovador es la inclusión de datos llamados «Web Code«: pares de imágenes de interfaces gráficas o visualizaciones junto con el código fuente asociado (por ejemplo, código HTML/CSS de una página o código Python que generó una gráfica). Gracias a esto, el modelo desarrolló cierto entendimiento para reconstruir código o describir la lógica subyacente al ver una interfaz o gráfico. Si bien no es un enfoque infalible, sugiere que DeepSeek VL puede asistir en tareas de ingeniería inversa visual, como interpretar un diagrama de flujo en pseudocódigo o estimar cómo fue producida una visualización.

- Pares imagen-texto tradicionales: Naturalmente, también se usaron datasets clásicos de visión-lenguaje, incluyendo imágenes con sus descripciones en lenguaje natural (captions). Esto refuerza la capacidad básica de describir imágenes y sirve de base para el entendimiento visual general.

- Corpus de texto puro: Para mantener la competencia lingüística del LLM, una parte del entrenamiento incluyó enormes colecciones de texto sin imágenes (por ejemplo, Wikipedia, libros, artículos). Esto garantiza que, aunque el modelo se especialice en multimodalidad, no pierda habilidad en tareas puramente de lenguaje, pudiendo brindar explicaciones detalladas o contexto adicional con la misma calidad de un modelo de lenguaje avanzado.

En conjunto, este conjunto de datos extenso y equilibrado le permite a DeepSeek VL desenvolverse en escenarios del mundo real con notable eficacia.

De hecho, los autores construyeron una taxonomía de casos de uso reales y recopilaron datos de ajuste fino basados en instrucciones derivadas de esa taxonomía.

Afinar el modelo con este dataset de instrucciones realistas resultó en mejoras sustanciales en la experiencia de usuario del modelo, ya que aprendió a seguir indicaciones tal como lo esperaríamos en aplicaciones prácticas.

Capacidades visión-lenguaje de DeepSeek VL

Gracias a su arquitectura y entrenamiento, DeepSeek VL posee capacidades avanzadas de visión-lenguaje que abarcan desde la descripción básica de imágenes hasta un profundo razonamiento visual en contextos complejos.

A continuación, destacamos algunas de sus habilidades clave orientadas a desarrolladores e ingenieros que deseen aprovechar este modelo en proyectos.

- Entrada multimodal (texto + imagen) y salida en lenguaje natural: DeepSeek VL puede recibir de forma simultánea imágenes y texto como entrada y generar una respuesta textual coherente. Por ejemplo, es posible proporcionarle una imagen junto con una pregunta o indicación relacionada con esa imagen, y el modelo producirá una respuesta en español u otro idioma deseado. Esta capacidad de combinar contexto textual y visual lo hace muy flexible. Se pueden encadenar varias imágenes en un mismo prompt (ej. fotos consecutivas) junto con descripciones, permitiendo comparaciones o referencias cruzadas entre imágenes. Todo esto se maneja internamente convirtiendo las imágenes en embeddings visuales que el LLM procesa junto al texto, gracias al diseño de tokens multimodales descrito anteriormente.

- Descripción de imágenes y reconocimiento de objetos: Como base de sus habilidades, DeepSeek VL puede describir contenido visual de manera rica y detallada. Dada una imagen, el modelo identifica los objetos, personas, escenarios y acciones presentes, y es capaz de generar una descripción fluida en texto. Esto incluye detalles como colores, posiciones espaciales y relaciones entre elementos. Por ejemplo, ante la foto de una escena urbana, podría responder: «La imagen muestra una calle concurrida con varios automóviles detenidos en un semáforo; a la derecha hay una cafetería con personas sentadas en mesas exteriores» (suponiendo que esos elementos estén en la imagen). Esta descripción va más allá de simples etiquetas, componiendo oraciones coherentes gracias al LLM subyacente.

- Razonamiento visual y comprensión contextual: Una de las fortalezas de DeepSeek VL es su razonamiento multimodal, es decir, la capacidad de inferir y deducir información combinando la vista con el contexto y conocimiento previo. No se limita a enumerar lo que ve, sino que puede responder preguntas complejas sobre la imagen. Por ejemplo, si se le muestra una secuencia de imágenes o un diagrama, puede explicar relaciones causales o pasos del proceso ilustrado. También puede responder preguntas de lógica espacial, como «¿Qué habitación del plano está más cerca del dormitorio principal?» cuando se le da el plano de un apartamento. Esto implica analizar la disposición en la imagen y entender términos como «cerca» o «dormitorio principal» en contexto. Su entrenamiento con datos de diversos dominios le permite incluso manejar preguntas abiertas que requieren sentido común visual (commonsense), por ejemplo: dada una imagen de una persona sosteniendo un paraguas bajo un cielo despejado, ¿por qué podría estar haciéndolo? (posibles respuestas: «Quizás para protegerse del sol»).

- Lectura de texto en imágenes (OCR integrado): DeepSeek VL incluye de forma intrínseca capacidades de OCR (Optical Character Recognition), lo que significa que puede leer texto embebido dentro de las imágenes y usarlo para responder preguntas. A diferencia de pipelines tradicionales donde se aplica un OCR externo antes de pasar el texto a un modelo de lenguaje, DeepSeek VL realiza este paso como parte de su propio proceso de atención multimodal. Si se le proporciona, por ejemplo, la foto de una página de revista o un cartel, el modelo puede extraer el texto y responder preguntas sobre el contenido. Por ejemplo, podríamos preguntarle «¿Quién es el autor del artículo mostrado en esta página?» entregándole la imagen escaneada de un artículo – DeepSeek VL localizará y leerá el nombre del autor en la imagen para responder. Del mismo modo, puede traducir texto encontrado en imágenes, resumir documentos escaneados o leer información de señales de tráfico en fotografías. Esta capacidad de OCR por LLM integrado ahorra a los desarrolladores tener que combinar múltiples herramientas, permitiendo un flujo más sencillo: se ingresa directamente la imagen con texto y el modelo devuelve la respuesta en lenguaje natural.

- Interpretación de gráficos, tablas y diagramas: Otra capacidad destacada es la comprensión de imágenes con datos estructurados. DeepSeek VL fue entrenado para interpretar gráficos (como diagramas de barras, líneas de tiempo, pasteles), tablas incrustadas en imágenes e incluso diagramas de flujo o planos técnicos. Por tanto, al darle una imagen de un gráfico, el modelo puede describir las tendencias mostradas («La gráfica muestra que las ventas aumentaron de enero a marzo y luego descendieron ligeramente en abril») o incluso extraer datos concretos («El valor máximo aproximado es 50 unidades en marzo»). En casos de diagramas, puede explicar su contenido, por ejemplo: «Este diagrama de flujo representa un proceso de decisión: comienza en el nodo A, luego bifurca a B o C dependiendo de X, etc.». Incluso se ha reportado que el modelo puede ayudar a convertir un diagrama en pseudocódigo o código, gracias a su entrenamiento con pares imagen-código. Imaginemos que le mostramos un diagrama de flujo básico y pedimos «Traducir este flujo a código Python»: DeepSeek VL puede generar una función o estructura condicional en Python que refleje la lógica del diagrama (definiendo condiciones

if/elsesegún las flechas, por ejemplo). Esta habilidad resulta muy útil para documentos técnicos escaneados o reportes que incluyan figuras – el modelo no solo lee el texto del pie de figura, sino que entiende la figura en sí. - Contexto y conocimiento incorporado: Al ser construido sobre un LLM competente, DeepSeek VL trae consigo un amplio conocimiento entrenado a partir de texto. Esto significa que puede responder preguntas que requieran información más allá de la imagen misma, combinando la visual con conocimientos generales. Por ejemplo, si se le muestra la foto de la Torre Eiffel y se le pregunta «¿Cuál es la altura de esta estructura?», el modelo sabe que se trata de la Torre Eiffel y puede responder con el dato aproximado (324 metros) basado en su entrenamiento textual, aunque ese número no aparezca en la imagen. Del mismo modo, ante la imagen de una pintura famosa, puede reconocer la obra (si es muy conocida) y aportar contexto histórico o artístico en la respuesta, mezclando descripción visual con información de fondo. Esta combinación de visión, lenguaje y conocimiento hace de DeepSeek VL una herramienta muy poderosa para generar respuestas completas y útiles.

Figura: Ejemplos de indicaciones (prompts) y respuestas generadas por DeepSeek VL en diversas tareas visuales y lingüísticas.

En la imagen superior se ilustra la versatilidad del modelo con casos de uso variados: desde la interpretación de planos arquitectónicos (prompt: “¿Qué baño está más cerca del dormitorio A?” con su correspondiente respuesta razonada en inglés), la identificación de estilo de una pintura (prompt: “What art style is evident in this image?” — “¿Qué estilo de arte es evidente en esta imagen?” — donde reconoce una obra impresionista y explica las pistas visuales), hasta la conversión de diagramas a código (se proporciona un diagrama de flujo y el modelo devuelve código Python equivalente).

También se aprecian ejemplos de lectura y análisis de documentos: un prompt pide resumir la principal contribución de un artículo científico a partir de la imagen de su resumen, y DeepSeek VL responde con un resumen en chino.

Estos casos demuestran cómo el modelo combina la comprensión visual detallada (leyendo diagramas, planos, capturas de interfaces) con la generación de texto informativo, según la tarea solicitada.

Para cada prompt que incluye una imagen, el modelo produce una respuesta textual adaptada, validando su utilidad en escenarios reales como soporte a investigaciones, asistencia en programación y análisis de contenido visual complejo.

Aplicaciones prácticas de DeepSeek VL en el mundo real

DeepSeek VL abre un abanico de posibilidades para aplicaciones de inteligencia artificial multimodal. A continuación, exploramos algunos casos de uso destacados donde este modelo puede agregar valor, especialmente desde la perspectiva de desarrolladores que buscan soluciones de visión por computadora integradas con comprensión de lenguaje.

Asistentes visuales inteligentes

Una de las aplicaciones más evidentes es la creación de asistentes virtuales con capacidad visual, similares a los chatbots tradicionales pero que también pueden «ver».

Por ejemplo, se puede integrar DeepSeek VL en un asistente móvil al cual el usuario le envía fotografías o captura en vivo desde su cámara, y el asistente responde en lenguaje natural.

Imaginemos un turista en un país extranjero: toma una foto de un letrero en otro idioma y pregunta «¿Qué significa este letrero?» – el modelo puede leer el texto en la imagen (OCR) y traducirlo al español, explicando su significado.

O una persona con discapacidad visual podría usar una aplicación para describirle el entorno: envía imágenes desde la cámara y pregunta «¿Qué hay frente a mí?», recibiendo descripciones detalladas de la escena (objetos, colores, distancias relativas) mediante la visión por computadora con IA de DeepSeek VL.

Este tipo de asistente visual también sería útil en tareas cotidianas, como revisar si la estufa quedó apagada con solo tomarle una foto, o analizar el contenido de un menú en un restaurante a partir de una foto del mismo.

La clave es que el usuario interactúa mediante un diálogo natural, y el modelo se encarga de interpretar las imágenes proporcionadas y extraer la información relevante para la respuesta.

Otra vertiente son los asistentes especializados.

Por ejemplo, en el ámbito médico, un asistente impulsado por DeepSeek VL podría analizar imágenes de radiografías, resonancias o gráficas de pacientes junto con preguntas de doctores, ofreciendo segundas opiniones o resúmenes (siempre con la debida validación humana).

En educación, un tutor de IA podría examinar el cuaderno escaneado de un estudiante y responder dudas sobre lo que el estudiante escribió o dibujó.

Las posibilidades son amplias dondequiera que combinar visión y lenguaje sea útil.

Análisis documental y extracción de información (Document AI)

DeepSeek VL es altamente apto para analizar documentos escaneados, PDFs e imágenes de texto para extraer y sintetizar información, lo que resulta valioso en entornos empresariales y administrativos.

Un desarrollador puede construir, por ejemplo, un sistema de Pregunta-Respuesta sobre documentos: el usuario sube la foto de un contrato o un informe y hace preguntas como «¿Cuál es la fecha de vencimiento de este contrato?» o «Resúmeme los puntos clave del informe»; DeepSeek VL puede leer todo el documento (aprovechando su ventana de 4096 tokens para contexto amplio) y responder puntualmente con los datos solicitados.

Esto combina OCR con procesamiento de lenguaje natural para evitar tener que leer manualmente documentos extensos.

En automatización de procesos (RPA) o flujos de trabajo, este modelo podría verificar datos en facturas, extraer tablas de estados financieros en PDF a texto, o validar el contenido de documentos escaneados contra reglas de negocio.

Por ejemplo, un sistema de validación podría mostrarle al modelo la imagen de una factura y preguntarle «¿El nombre del proveedor coincide con el registrado en la base de datos?» – el modelo leerá el nombre en la factura y podrá compararlo (si el nombre esperado se proporciona en el prompt, o incluso recuperándolo de su conocimiento si es una empresa conocida).

La integración de OCR con comprensión semántica permite no solo transcribir, sino entender el contexto: sabe distinguir entre distintos campos (fechas, nombres, montos) por el contexto en que aparecen y puede deducir qué información es relevante para la pregunta.

Asimismo, en el ámbito legal o de investigación, DeepSeek VL puede ayudar a analizar evidencias visuales con texto. Por ejemplo, leer conversaciones de chat tomadas como captura de pantalla e identificar menciones específicas, o revisar documentos históricos escaneados buscando referencias. T

odo ello en un solo paso, sin requerir procesar primero OCR y luego pasar a un modelo de QA separado.

Interpretación de datos visuales y soporte en decisiones

El hecho de que DeepSeek VL entienda gráficos y tablas le permite integrarse en herramientas de business intelligence o análisis de datos donde la visualización es clave.

Un caso de uso es un dashboard interactivo potenciado con lenguaje natural: el usuario podría enviar una captura de un gráfico generado por alguna herramienta (por ejemplo, una gráfica de ventas trimestrales) y preguntar «¿Cuál fue el mes más fuerte en ventas y a cuánto ascendieron?».

El modelo, al haber sido entrenado en procesamiento de imágenes con IA incluyendo gráficos, leerá las etiquetas y valores del eje en la imagen y responderá con algo como: «Marzo fue el mes con mayores ventas, alcanzando aproximadamente 50,000 unidades vendidas.»

Esto convierte cualquier imagen de reporte estático en información consultable vía lenguaje natural, agilizando el análisis.

En ingeniería y desarrollo, consideremos la capacidad de reconstruir código a partir de una interfaz. Un desarrollador puede mostrarle al modelo la captura de una página web o un diseño de componente y pedir «Genera el código HTML/CSS para este diseño».

Dado el entrenamiento con «Web Code», DeepSeek VL podría no dar un código perfecto, pero sí un borrador de código que se aproxime al diseño (por ejemplo, creando un layout con divs, imágenes y estilos básicos reflejando la posición de elementos).

Igualmente, podría traducir una gráfica en su posible código de generación (por ejemplo, sugiere cómo sería un script de Matplotlib o D3.js para obtener una gráfica similar a la imagen).

Esto puede servir de ayuda en la fase de prototipado rápido o para comprender cómo se podría reproducir una visualización particular.

Otro uso práctico es en automatización de pruebas y debugging visual. Con DeepSeek VL, se podría tomar una captura de pantalla de una aplicación en ejecución y hacer preguntas del tipo: «¿Ves algún error en esta interfaz?» o «¿Qué texto aparece en el mensaje de error?», y obtener respuestas útiles.

En juegos de video o realidad aumentada, un bot con este modelo podría ver la pantalla del juego y ayudar al jugador respondiendo dudas (como un asistente que «observa» la pantalla y brinda consejos).

Entornos robóticos y comprensión del entorno

En el campo de la robótica y vehículos autónomos, un modelo como DeepSeek VL puede usarse como un componente de razonamiento visual de alto nivel.

Por ejemplo, un robot móvil equipado con cámaras puede enviar imágenes de lo que ve y preguntar al modelo qué acción tomar en lenguaje natural.

Supongamos un robot doméstico con cámara en la cocina: envía una imagen de la cocina y pregunta «Estoy frente al refrigerador y necesito llevarle una bebida al usuario, ¿qué debo hacer?».

El modelo, combinando la escena visual con conocimiento procedimental, podría responder algo como: «Abre la puerta del refrigerador, identifica una botella de agua en el estante inferior, tómala con la pinza y ciérralo, luego llévala a la persona.»

Este es un razonamiento visual secuencial guiado por IA, que asiste al robot en lenguaje natural.

Si bien la ejecución real queda al robot, modelos como DeepSeek VL pueden servir de cerebro de planificación basado en interpretación visual y lenguaje, especialmente útil en entornos no estructurados donde las reglas deben deducirse de la escena.

En conducción autónoma, un sistema podría preguntar al modelo sobre una imagen de las cámaras del auto: «¿Ves algún peligro en esta escena?» y podría responder «Hay un peatón parado cerca del borde de la acera a la derecha» o «El semáforo está en rojo, debes detenerte».

Nuevamente, no se sugeriría confiar ciegamente en esto para la seguridad, pero como apoyo de análisis es interesante.

Para drones o robots exploradores, describir lo que ven en tiempo real en lenguaje natural también puede ayudar a operadores humanos a tomar decisiones con mayor información.

Ejemplo: Cómo usar DeepSeek VL en tu proyecto

Para desarrolladores, integrar DeepSeek VL es relativamente sencillo gracias a su disponibilidad en plataformas como Hugging Face. A continuación mostramos un ejemplo de uso con Python (utilizando la biblioteca Transformers junto con el paquete oficial de DeepSeek VL). Este fragmento ilustra cómo cargar el modelo DeepSeek VL-7B-chat y hacer que procese una imagen con una pregunta:

from transformers import AutoModelForCausalLM

from deepseek_vl.models import VLChatProcessor

# Identificador del modelo en Hugging Face

modelo_id = "deepseek-ai/deepseek-vl-7b-chat"

# Cargar el procesador multimodal y el modelo de lenguaje

procesador = VLChatProcessor.from_pretrained(modelo_id)

modelo = AutoModelForCausalLM.from_pretrained(modelo_id, trust_remote_code=True).eval()

# Preparar una conversación con prompt e imagen

from PIL import Image

imagen = Image.open("ejemplo.png") # Cargar una imagen de ejemplo

prompt_usuario = {

"role": "User",

"content": "<image_placeholder>¿Qué se muestra en la imagen?",

"images": [imagen]

}

conversacion = [prompt_usuario, {"role": "Assistant", "content": ""}]

# Convertir la entrada en tensores apropiados

inputs = procesador(conversations=conversacion, images=[imagen], return_tensors="pt")

# Generar respuesta con el modelo (ajustar parámetros de generación según necesidad)

ids_respuesta = modelo.generate(**inputs)

# Decodificar la respuesta a texto legible

respuesta = procesador.tokenizer.decode(ids_respuesta[0], skip_special_tokens=True)

print(respuesta)

Explicación: En este código, usamos VLChatProcessor para preparar la entrada multimodal: combinamos la imagen (imagen) con una pregunta en texto ("¿Qué se muestra en la imagen?").

El texto "<image_placeholder>" actúa como marcador dentro del prompt donde se insertará la imagen. El procesador se encarga de convertir tanto el texto como la imagen en un formato numérico que el modelo entiende. Luego, el modelo (AutoModelForCausalLM cargado con trust_remote_code=True dado que DeepSeek VL extiende la clase de Transformers) genera una respuesta de lenguaje natural.

Finalmente, decodificamos los ids de salida a la cadena de texto que representa la respuesta.

Este flujo simplifica para el desarrollador la complejidad interna: el modelo maneja internamente la codificación de la imagen, la atención conjunta entre texto e imagen, y la generación final de la respuesta.

En un entorno real, podrías obtener algo como: «En la imagen se ve un perro de raza labrador jugando en un jardín con una pelota roja» (suponiendo que esa fuera la escena en «ejemplo.png»).

Además, el modelo chat está diseñado para interacción, por lo que podríamos extender la conversación con nuevas preguntas de seguimiento sin volver a proporcionar la imagen, y mantendrá el contexto visual en la memoria a corto plazo de la sesión.

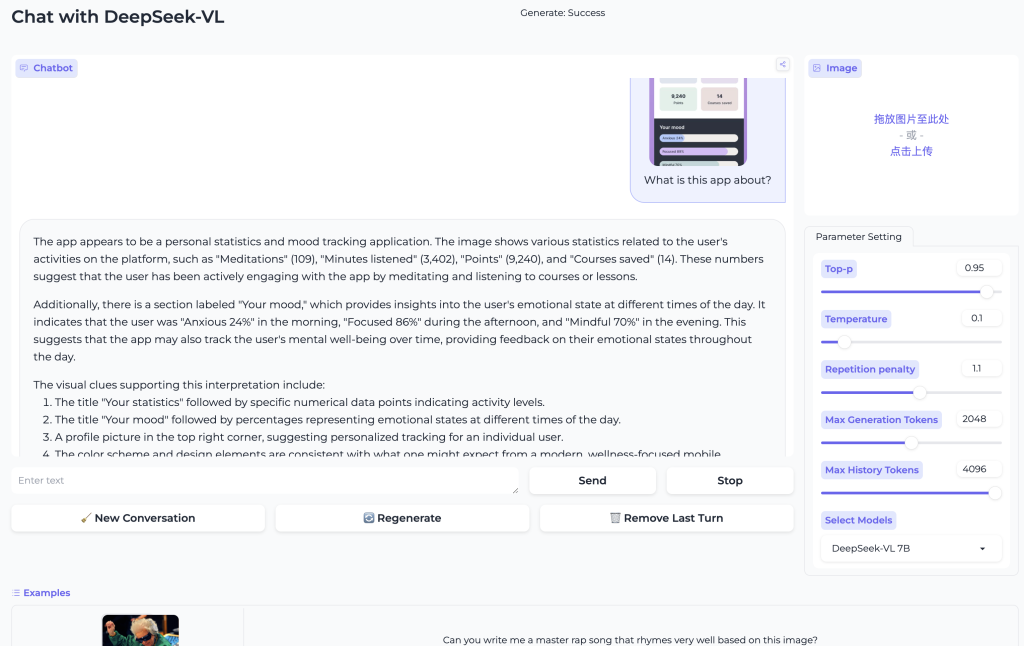

Cabe mencionar que también existe una demo web basada en Gradio donde se puede probar DeepSeek VL de forma interactiva.

Esto permite cargar imágenes y escribir preguntas directamente desde el navegador para ver las respuestas del modelo, lo cual es útil para experimentar con sus capacidades sin tener que instalar nada localmente.

Sin embargo, para integrar en un sistema propio, la vía mostrada con código Python ofrece mayor control (por ejemplo, ajustar los parámetros de generación, procesar lotes de imágenes, etc.).

Conclusiones

DeepSeek VL representa una poderosa herramienta multimodal que combina inteligencia visual y verbal en un solo modelo unificado.

Su arquitectura con un codificador híbrido de imágenes y un LLM integrado le permite abordar tareas complejas que requieren entender tanto píxeles como texto.

Entrenado con datos variados que van desde capturas web, documentos y gráficos hasta texto puro, el modelo ha demostrado un desempeño muy sólido en numerosos benchmarks, manteniendo su robustez tanto en tareas visuales como en lingüísticas.

Para los desarrolladores, esto se traduce en un sistema versátil capaz de impulsar aplicaciones innovadoras: asistentes virtuales que ven y hablan, soluciones de OCR inteligente que no solo transcriben sino comprenden, análisis automatizado de contenido visual en sectores como el empresarial, educativo o médico, y muchas más posibilidades en el horizonte.

En términos de implementación, el hecho de ser open-source y estar disponible en modelos de diferentes tamaños (1.3B y 7B) con licenciamiento permisivo, facilita su adopción e integración en proyectos reales.

Los ingenieros pueden empezar con la variante pequeña para entornos con recursos limitados, o con la grande para máxima precisión, e incluso afinar adicionalmente el modelo en dominios específicos si fuese necesario.

En resumen, DeepSeek VL es un exponente destacado de la nueva generación de modelos multimodales que llevan la visión por computadora y el procesamiento de lenguaje natural con IA al siguiente nivel.

Su capacidad de razonamiento visual, lectura de texto en imágenes (OCR por LLM), comprensión de gráficos y diálogo contextual lo hacen especialmente atractivo para crear aplicaciones que antes habrían requerido combinar múltiples sistemas dispares.

Ahora, con un único modelo, los desarrolladores pueden dotar a sus aplicaciones de una visión inteligente, logrando que entiendan e interpreten el mundo visual con la misma facilidad con la que procesan el texto.

Las oportunidades van desde mejorar la accesibilidad y automatización, hasta apoyar decisiones basadas en información visual compleja.

DeepSeek VL nos muestra cómo unificar dos modalidades fundamentales –la visión y el lenguaje– abre la puerta a nuevas experiencias de IA más ricas y útiles en el mundo real.